电子发烧友网报道(文/李弯弯)在深度学习中,经常听到一个词“模型训练”,但是模型是什么?又是怎么训练的?在人工智能中,面对大量的数据,要在杂乱无章的内容中,准确、容易地识别,输出需要的图像/语音

2022-10-23 00:19:00 24277

24277 训练和微调大型语言模型对于硬件资源的要求非常高。目前,主流的大模型训练硬件通常采用英特尔的CPU和英伟达的GPU。然而,最近苹果的M2 Ultra芯片和AMD的显卡进展给我们带来了一些新的希望。

2023-07-28 16:11:01 2126

2126

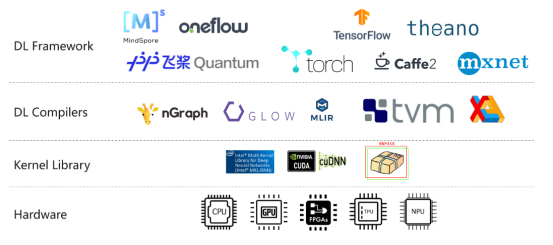

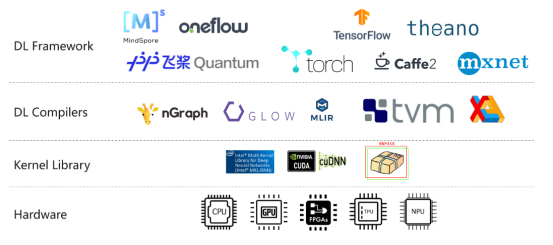

分布式深度学习框架中,包括数据/模型切分、本地单机优化算法训练、通信机制、和数据/模型聚合等模块。现有的算法一般采用随机置乱切分的数据分配方式,随机优化算法(例如随机梯度法)的本地训练算法,同步或者异步通信机制,以及参数平均的模型聚合方式。

2018-07-09 08:48:22 13609

13609

为了训练出高效可用的深层神经网络模型,在训练时必须要避免过拟合的现象。过拟合现象的优化方法通常有三种。

2020-12-02 14:17:24 2322

2322

随着预训练语言模型(PLMs)的不断发展,各种NLP任务设置上都取得了不俗的性能。尽管PLMs可以从大量语料库中学习一定的知识,但仍旧存在很多问题,如知识量有限、受训练数据长尾分布影响鲁棒性不好

2022-04-02 17:21:43 8765

8765 NLP领域的研究目前由像RoBERTa等经过数十亿个字符的语料经过预训练的模型汇主导。那么对于一个预训练模型,对于不同量级下的预训练数据能够提取到的知识和能力有何不同?

2023-03-03 11:21:51 1339

1339 为什么?一般有 tensor parallelism、pipeline parallelism、data parallelism 几种并行方式,分别在模型的层内、模型的层间、训练数据三个维度上对 GPU 进行划分。三个并行度乘起来,就是这个训练任务总的 GPU 数量。

2023-09-15 11:16:21 12112

12112

、并行和并发能力增强、类型系统增强等方面的语言特性。本期我们结合JS和TS以及相关的开发框架的发展,为大家介绍eTS的起源和演进思路。一、JSJS语言由Mozilla创造,最初主要是为了解决页面中的逻辑

2022-07-14 11:04:10

浅析变频器发展现状和趋势(原文链接)变频器:利用电力半导体器件的通断作用将工频电源变换为另一频率的电能控制装置。其作用对象主要是电动机。分类:交—交(频率电压可变)、交—直—交(整流、逆变)性能优劣

2021-09-03 06:40:59

训练好的ai模型导入cubemx不成功咋办,试了好几个模型压缩了也不行,ram占用过大,有无解决方案?

2023-08-04 09:16:28

Edge Impulse是一个应用于嵌入式领域的在线的机器学习网站,不仅为用户提供了一些现成的神经网络模型以供训练,还能直接将训练好的模型转换成能在单片机MCU上运行的代码,使用方便,容易上手。本文

2021-12-20 06:51:26

),其中y取值1或-1(代表二分类的类别标签),这也是GBDT可以用来解决分类问题的原因。模型训练代码地址 https://github.com/qianshuang/ml-expdef train

2019-01-23 14:38:58

本教程以实际应用、工程开发为目的,着重介绍模型训练过程中遇到的实际问题和方法。在机器学习模型开发中,主要涉及三大部分,分别是数据、模型和损失函数及优化器。本文也按顺序的依次介绍数据、模型和损失函数

2018-12-21 09:18:02

能否直接调用训练好的模型文件?

2021-06-22 14:51:03

印制板从单层发展到双面、多层和挠性,并且仍旧保持着各自的发展趋势。由于不断地向高精度、高密度和高可靠性方向发展,不断缩小体积、减少成本、提高性能,使得印制板在未来电子设备的发展工程中,仍然保持着

2020-10-21 16:37:02

`本篇主要介绍:人工神经网络的起源、简单神经网络模型、更多神经网络模型、机器学习的步骤:训练与预测、训练的两阶段:正向推演与反向传播、以TensorFlow + Excel表达训练流程以及AI普及化教育之路。`

2020-11-05 17:48:39

学习的方法,将预训练的resnet18模型从原来的1000类分类任务,改造为适应自定义的30类分类任务。

ResNet18介绍

ResNet18是一种基于深度残差网络(ResNet)的卷积神经网络模型

2023-10-16 15:03:16

准备开始为家猫做模型训练检测,要去官网https://maix.sipeed.com/home 注册帐号,文章尾部的视频是官方的,与目前网站略有出路,说明训练网站的功能更新得很快。其实整个的过程

2022-06-26 21:19:40

TOP1的桂冠,可想大家对本书的认可和支持!

这本书为什么如此受欢迎?它究竟讲了什么?下面就给大家详细~~

本书主要内容

本书围绕大语言模型构建的四个主要阶段——预训练、有监督微调、奖励建模和强化

2024-03-11 15:16:39

` EasyDL网站可以免费生成针对EdgeBoard板卡FZ5的离线训练模型SDK,该SDK可以完美与FZ5硬件契合,最重要的是——free(免费)。下面就是针对FZ5生成模型SDK的实例——图片

2021-03-23 14:32:35

我正在尝试使用自己的数据集训练人脸检测模型。此错误发生在训练开始期间。如何解决这一问题?

2023-04-17 08:04:49

医疗模型人训练系统是为满足广大医学生的需要而设计的。我国现代医疗模拟威廉希尔官方网站

的发展处于刚刚起步阶段,大部分仿真系统产品都源于国外,虽然对于模拟人仿真已经出现一些产品,但那些产品只是就模拟人的某一部分,某一个功能实现的仿真,没有一个完整的系统综合其所有功能。

2019-08-19 08:32:45

卷积神经网络模型发展及应用转载****地址:http://fcst.ceaj.org/CN/abstract/abstract2521.shtml深度学习是机器学习和人工智能研究的最新趋势,作为一个

2022-08-02 10:39:39

问题最近在Ubuntu上使用Nvidia GPU训练模型的时候,没有问题,过一会再训练出现非常卡顿,使用nvidia-smi查看发现,显示GPU的风扇和电源报错:解决方案自动风扇控制在nvidia

2022-01-03 08:24:09

CV:基于Keras利用训练好的hdf5模型进行目标检测实现输出模型中的脸部表情或性别的gradcam(可视化)

2018-12-27 16:48:28

CV:基于Keras利用CNN主流架构之mini_XCEPTION训练情感分类模型hdf5并保存到指定文件夹下

2018-12-26 11:08:26

使用TensorFlow的transform_graph工具生成一个优化的8位模型,该模型效率更高,但精度较低。

4.在设备上对优化的模型进行基准测试,并选择最符合您部署需求的模型。

本教程使用预训练

2023-08-02 06:43:57

我正在尝试使用 eIQ 门户训练人脸检测模型。我正在尝试从 tensorflow 数据集 (tfds) 导入数据集,特别是 coco/2017 数据集。但是,我只想导入 wider_face。但是,当我尝试这样做时,会出现导入程序错误,如下图所示。任何帮助都可以。

2023-04-06 08:45:14

数字预失真平台系统模型是怎样构成的?如何对数字预失真平台系统进行仿真测试?

2021-04-21 07:23:32

PyTorch Hub 加载预训练的 YOLOv5s 模型,model并传递图像进行推理。'yolov5s'是最轻最快的 YOLOv5 型号。有关所有可用模型的详细信息,请参阅自述文件。详细示例此示例

2022-07-22 16:02:42

Transformers已成为计算机视觉最新进展的核心。然而,从头开始训练ViT模型可能会耗费大量资源和时间。在本文中旨在探索降低ViT模型训练成本的方法。引入了一些算法改进,以便能够在有限的硬件

2022-11-24 14:56:31

tensorflow模型部署系列的一部分,用于tflite实现通用模型的部署。本文主要使用pb格式的模型文件,其它格式的模型文件请先进行格式转换,参考tensorflow模型部署系列————预训练模型导出。从...

2021-12-22 06:51:18

),其中y取值1或-1(代表二分类的类别标签),这也是GBDT可以用来解决分类问题的原因。模型训练代码地址 https://github.com/qianshuang/ml-expdef train

2019-01-25 15:02:15

目前官方的线上模型训练只支持K210,请问K510什么时候可以支持

2023-09-13 06:12:13

我在matlab中训练好了一个神经网络模型,想在labview中调用,请问应该怎么做呢?或者labview有自己的神经网络工具包吗?

2018-07-05 17:32:32

介绍了基于事例的智能维修训练系统中学生模型的结构组成和实现方法。该模型釆用了模糊测量方法即贴近度和择近原则来对学生的知识水平

2009-09-15 10:11:51 14

14 浅析第四代移动通信

引言 移动通信威廉希尔官方网站

飞速发展,已经历了3个主要发展阶段。每一代的发展都是威廉希尔官方网站

的突破和观念的创新。第一代起源于20世纪80年

2010-01-23 10:19:45 1099

1099 浅析LED路灯的发展和应用

摘 要:本文简要分析了城市道路照明大功率LED路灯在发展和应用中“产品的标准化和通用性、国家标准的制定、光学设计、散热等主要

2010-04-20 11:13:46 1342

1342 飞行训练成绩评估模型的建立与实现,有兴趣的同学可以下载学习

2016-05-04 14:37:53 0

0 为基础,重新定义服务起源在图形数据库中的存储结构,并提供基于此存储结构的聚合操作。然后提出了基于静态权值、基于混合操作与基于实时任务三种不同的服务起源追踪模型。实验结果表明该服务起源追踪机制能够满足聚合、追踪等

2017-12-17 10:58:13 0

0 白菜白光起源、发展及代表性电路图

2018-02-03 10:34:14 61

61 深度学习模型和数据集的规模增长速度已经让 GPU 算力也开始捉襟见肘,如果你的 GPU 连一个样本都容不下,你要如何训练大批量模型?通过本文介绍的方法,我们可以在训练批量甚至单个训练样本大于 GPU

2018-12-03 17:24:01 668

668 正如我们在本文中所述,ULMFiT使用新颖的NLP威廉希尔官方网站

取得了令人瞩目的成果。该方法对预训练语言模型进行微调,将其在WikiText-103数据集(维基百科的长期依赖语言建模数据集Wikitext之一)上训练,从而得到新数据集,通过这种方式使其不会忘记之前学过的内容。

2019-04-04 11:26:26 23192

23192

机器学习模型的训练,通常是通过学习某一组输入特征与输出目标之间的映射来进行的。一般来说,对于映射的学习是通过优化某些成本函数,来使预测的误差最小化。在训练出最佳模型之后,将其正式发布上线,再根据未来

2020-04-10 08:00:00 0

0 在这篇文章中,我会介绍一篇最新的预训练语言模型的论文,出自MASS的同一作者。这篇文章的亮点是:将两种经典的预训练语言模型(MaskedLanguage Model, Permuted

2020-11-02 15:09:36 2334

2334 本文把对抗训练用到了预训练和微调两个阶段,对抗训练的方法是针对embedding space,通过最大化对抗损失、最小化模型损失的方式进行对抗,在下游任务上取得了一致的效果提升。 有趣的是,这种对抗

2020-11-02 15:26:49 1802

1802

BERT的发布是这个领域发展的最新的里程碑之一,这个事件标志着NLP 新时代的开始。BERT模型打破了基于语言处理的任务的几个记录。在 BERT 的论文发布后不久,这个团队还公开了模型的代码,并提供了模型的下载版本

2020-11-24 10:08:22 3200

3200 本期推送介绍了哈工大讯飞联合实验室在自然语言处理重要国际会议COLING 2020上发表的工作,提出了一种字符感知预训练模型CharBERT,在多个自然语言处理任务中取得显著性能提升,并且大幅度

2020-11-27 10:47:09 1582

1582

导读:预训练模型在NLP大放异彩,并开启了预训练-微调的NLP范式时代。由于工业领域相关业务的复杂性,以及工业应用对推理性能的要求,大规模预训练模型往往不能简单直接地被应用于NLP业务中。本文将为

2020-12-31 10:17:11 2217

2217

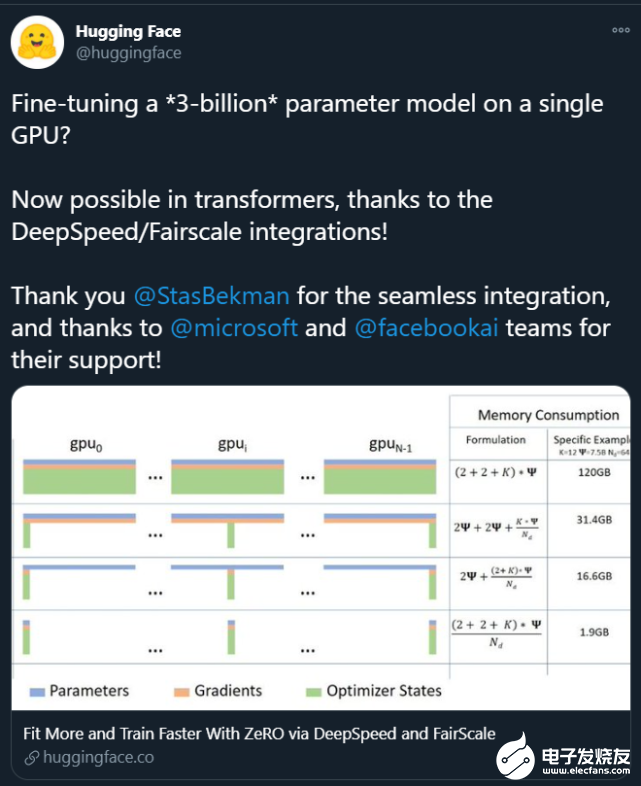

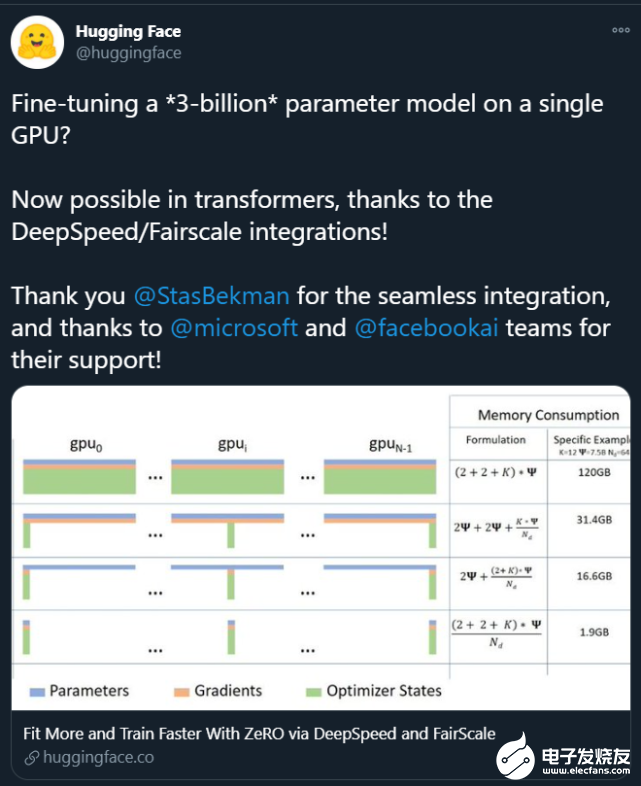

。这些大模型的出现让普通研究者越发绝望:没有「钞能力」、没有一大堆 GPU 就做不了 AI 研究了吗? 在此背景下,部分研究者开始思考:如何让这些大模型的训练变得更加接地气?也就是说,怎么用更少的卡训练更大的模型? 为了解决这个问题,来自微软、加州大学默塞德分校的研究

2021-02-11 09:04:00 2167

2167

为提高卷积神经网络目标检测模型精度并增强检测器对小目标的检测能力,提出一种脱离预训练的多尺度目标检测网络模型。采用脱离预训练检测网络使其达到甚至超过预训练模型的精度,针对小目标特点

2021-04-02 11:35:50 26

26 作为模型的初始化词向量。但是,随机词向量存在不具备语乂和语法信息的缺点;预训练词向量存在¨一词-乂”的缺点,无法为模型提供具备上下文依赖的词向量。针对该问题,提岀了一种基于预训练模型BERT和长短期记忆网络的深度学习

2021-04-20 14:29:06 19

19 本文首先介绍了用小样本训练模型会导致的问题,再介绍了Few-Shot Learning的基本原理即三大思路下的方法。

2021-06-23 15:02:11 6238

6238 本文关注于向大规模预训练语言模型(如RoBERTa、BERT等)中融入知识。

2021-06-23 15:07:31 3468

3468

在某一方面的智能程度。具体来说是,领域专家人工构造标准数据集,然后在其上训练及评价相关模型及方法。但由于相关威廉希尔官方网站

的限制,要想获得效果更好、能力更强的模型,往往需要在大量的有标注的数据上进行训练。 近期预训练模型的

2021-09-06 10:06:53 3351

3351

大模型的预训练计算。 大模型是大势所趋 近年来,NLP 模型的发展十分迅速,模型的大小每年以1-2个数量级的速度在提升,背后的推动力当然是大模型可以带来更强大更精准的语言语义理解和推理能力。 截止到去年,OpenAI发布的GPT-3模型达到了175B的大小,相比2018年94M的ELMo模型,三年的时间整整增大了

2021-10-11 16:46:05 2226

2226

大模型的预训练计算。 上篇主要介绍了大模型训练的发展趋势、NVIDIA Megatron的模型并行设计,本篇将承接上篇的内容,解析Megatron 在NVIDIA DGX SuperPOD 上的实践

2021-10-20 09:25:43 2078

2078 2021 OPPO开发者大会:NLP预训练大模型 2021 OPPO开发者大会上介绍了融合知识的NLP预训练大模型。 责任编辑:haq

2021-10-27 14:18:41 1492

1492

浅析碟式离心机的分离影响因素及模型

2021-11-12 17:10:04 3

3 NLP中,预训练大模型Finetune是一种非常常见的解决问题的范式。利用在海量文本上预训练得到的Bert、GPT等模型,在下游不同任务上分别进行finetune,得到下游任务的模型。然而,这种方式

2022-03-21 15:33:30 1843

1843 “强悍的织女模型在京东探索研究院建设的全国首个基于 DGX SuperPOD 架构的超大规模计算集群 “天琴α” 上完成训练,该集群具有全球领先的大规模分布式并行训练威廉希尔官方网站

,其近似线性加速比的数据、模型、流水线并行威廉希尔官方网站

持续助力织女模型的高效训练。”

2022-04-13 15:13:11 783

783 利用 NVIDIA TLT 快速准确地训练人工智能模型的探索表明,人工智能在工业过程中具有巨大的潜力。

2022-04-20 17:45:40 2330

2330

由于乱序语言模型不使用[MASK]标记,减轻了预训练任务与微调任务之间的gap,并由于预测空间大小为输入序列长度,使得计算效率高于掩码语言模型。PERT模型结构与BERT模型一致,因此在下游预训练时,不需要修改原始BERT模型的任何代码与脚本。

2022-05-10 15:01:27 1173

1173 中 training_config 设置组的 “enable_qat” 参数设为 “false” 就行,然后直接执行指令块的命令,TAO 就会启动视觉类容器来执行模型训练任务。

2022-05-13 10:57:19 1180

1180 为了减轻上述问题,提出了NoisyTune方法,即,在finetune前加入给预训练模型的参数增加少量噪音,给原始模型增加一些扰动,从而提高预训练语言模型在下游任务的效果,如下图所示,

2022-06-07 09:57:32 1972

1972 本文对任务低维本征子空间的探索是基于 prompt tuning, 而不是fine-tuning。原因是预训练模型的参数实在是太多了,很难找到这么多参数的低维本征子空间。作者基于之前的工作提出

2022-07-08 11:28:24 935

935 表示输入的特征,在传统的对抗训练中, 通常是 token 序列或者是 token 的 embedding, 表示 ground truth. 对于由 参数化的模型,模型的预测结果可以表示为 。

2022-07-08 16:57:09 1047

1047 今天给大家带来一篇IJCAI2022浙大和阿里联合出品的采用对比学习的字典描述知识增强的预训练语言模型-DictBERT,全名为《Dictionary Description Knowledge

2022-08-11 10:37:55 866

866 电子发烧友网报道(文/李弯弯)在深度学习中,经常听到一个词“模型训练”,但是模型是什么?又是怎么训练的?在人工智能中,面对大量的数据,要在杂乱无章的内容中,准确、容易地识别,输出需要的图像/语音

2022-10-23 00:20:03 7253

7253 汽车环视威廉希尔官方网站

发展趋势浅析

2022-11-02 08:16:10 4

4 另一方面,从语言处理的角度来看,认知神经科学研究人类大脑中语言处理的生物和认知过程。研究人员专门设计了预训练的模型来捕捉大脑如何表示语言的意义。之前的工作主要是通过明确微调预训练的模型来预测语言诱导的大脑记录,从而纳入认知信号。

2022-11-03 15:07:08 707

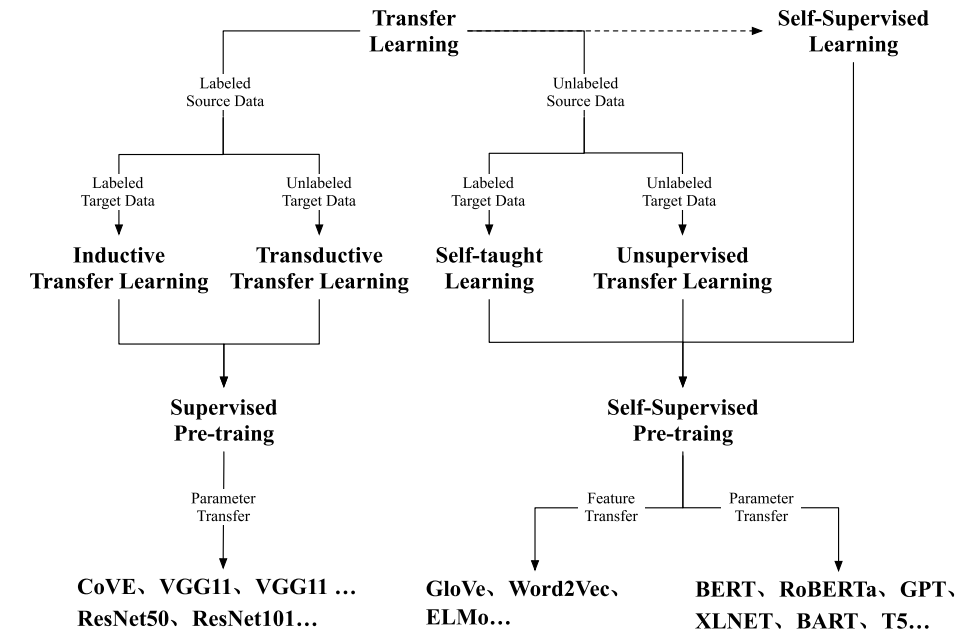

707 随着BERT、GPT等预训练模型取得成功,预训-微调范式已经被运用在自然语言处理、计算机视觉、多模态语言模型等多种场景,越来越多的预训练模型取得了优异的效果。

2022-11-08 09:57:19 3714

3714 NVIDIA 发布了 TAO 工具套件 4.0 。该工具套件通过全新的 AutoML 功能、与第三方 MLOPs 服务的集成以及新的预训练视觉 AI 模型提高开发者的生产力。该工具套件的企业版现在

2022-12-15 19:40:06 722

722 BERT类模型的工作模式简单,但取得的效果也是极佳的,其在各项任务上的良好表现主要得益于其在大量无监督文本上学习到的文本表征能力。那么如何从语言学的特征角度来衡量一个预训练模型的究竟学习到了什么样的语言学文本知识呢?

2023-03-03 11:20:00 911

911 预训练 AI 模型是为了完成特定任务而在大型数据集上训练的深度学习模型。这些模型既可以直接使用,也可以根据不同行业的应用需求进行自定义。 如果要教一个刚学会走路的孩子什么是独角兽,那么我们首先应

2023-04-04 01:45:02 1025

1025 作为人工智能领域的基础,训练数据集对于模型的训练和优化至关重要。在过去的几十年中,随着计算机威廉希尔官方网站

和硬件性能的不断提升,人工智能威廉希尔官方网站

得到了快速的发展,但是训练数据集作为基础部分,却一直是制约其发展

2023-04-26 17:27:21 836

836 作为深度学习领域的 “github”,HuggingFace 已经共享了超过 100,000 个预训练模型

2023-05-19 15:57:43 494

494

预训练 AI 模型是为了完成特定任务而在大型数据集上训练的深度学习模型。这些模型既可以直接使用,也可以根据不同行业的应用需求进行自定义。

2023-05-25 17:10:09 595

595 因为该模型的训练时间明显更长,训练了1.4 万亿标记而不是 3000 亿标记。所以你不应该仅仅通过模型包含的参数数量来判断模型的能力。

2023-05-30 14:34:56 642

642

本文章将依次介绍如何将Pytorch自训练模型经过一系列变换变成OpenVINO IR模型形式,而后使用OpenVINO Python API 对IR模型进行推理,并将推理结果通过OpenCV API显示在实时画面上。

2023-06-07 09:31:42 1058

1058

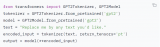

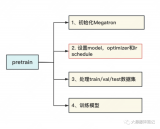

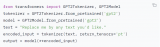

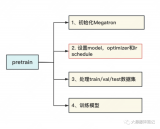

前文说过,用Megatron做分布式训练的开源大模型有很多,我们选用的是THUDM开源的CodeGeeX(代码生成式大模型,类比于openAI Codex)。选用它的原因是“完全开源”与“清晰的模型架构和预训练配置图”,能帮助我们高效阅读源码。我们再来回顾下这两张图。

2023-06-07 15:08:24 2186

2186

在一些非自然图像中要比传统模型表现更好 CoOp 增加一些 prompt 会让模型能力进一步提升 怎么让能力更好?可以引入其他知识,即其他的预训练模型,包括大语言模型、多模态模型 也包括

2023-06-15 16:36:11 277

277

卷积神经网络模型训练步骤 卷积神经网络(Convolutional Neural Network, CNN)是一种常用的深度学习算法,广泛应用于图像识别、语音识别、自然语言处理等诸多领域。CNN

2023-08-21 16:42:00 885

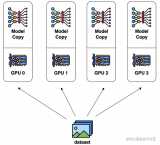

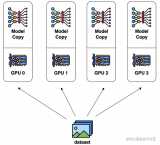

885 数据并行是最常见的并行形式,因为它很简单。在数据并行训练中,数据集被分割成几个碎片,每个碎片被分配到一个设备上。这相当于沿批次(Batch)维度对训练过程进行并行化。每个设备将持有一个完整的模型副本,并在分配的数据集碎片上进行训练。

2023-08-24 15:17:28 537

537

在《英特尔锐炫 显卡+ oneAPI 和 OpenVINO 实现英特尔 视频 AI 计算盒训推一体-上篇》一文中,我们详细介绍基于英特尔 独立显卡搭建 YOLOv7 模型的训练环境,并完成了 YOLOv7 模型训练,获得了最佳精度的模型权重。

2023-08-25 11:08:58 819

819

生成式AI和大语言模型(LLM)正在以难以置信的方式吸引全世界的目光,本文简要介绍了大语言模型,训练这些模型带来的硬件挑战,以及GPU和网络行业如何针对训练的工作负载不断优化硬件。

2023-09-01 17:14:56 1046

1046

finetune)、rlhf(optional). State of GPT:大神 Andrej 揭秘 OpenAI 大模型原理和训练过程 。 supervised finetune 一般在 base

2023-09-19 10:00:06 506

506

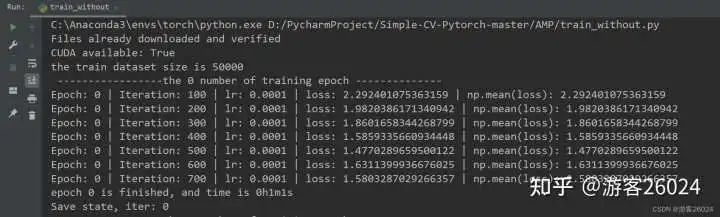

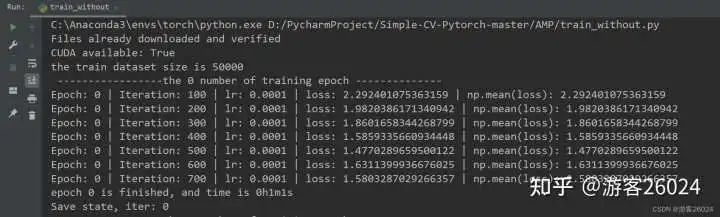

的博文,对 Pytorch的AMP ( autocast与Gradscaler 进行对比) 自动混合精度对模型训练加速 。 注意Pytorch1.6+,已经内置torch.cuda.amp,因此便不需要加载

2023-11-03 10:00:19 1054

1054

算法工程、数据派THU深度学习在近年来得到了广泛的应用,从图像识别、语音识别到自然语言处理等领域都有了卓越的表现。但是,要训练出一个高效准确的深度学习模型并不容易。不仅需要有高质量的数据、合适的模型

2023-12-07 12:38:24 547

547

Hello大家好,今天给大家分享一下如何基于深度学习模型训练实现圆检测与圆心位置预测,主要是通过对YOLOv8姿态评估模型在自定义的数据集上训练,生成一个自定义的圆检测与圆心定位预测模型

2023-12-21 10:50:05 529

529

Hello大家好,今天给大家分享一下如何基于深度学习模型训练实现工件切割点位置预测,主要是通过对YOLOv8姿态评估模型在自定义的数据集上训练,生成一个工件切割分离点预测模型

2023-12-22 11:07:46 259

259

谷歌模型训练软件主要是指ELECTRA,这是一种新的预训练方法,源自谷歌AI。ELECTRA不仅拥有BERT的优势,而且在效率上更胜一筹。

2024-02-29 17:37:39 337

337 谷歌在模型训练方面提供了一些强大的软件工具和平台。以下是几个常用的谷歌模型训练软件及其特点。

2024-03-01 16:24:01 184

184

电子发烧友App

电子发烧友App

评论