相信大家还记得曾经游戏中的主人公,可以随着按键旋转跳跃,通过三维/二维模型或者实现录制好的视频来响应不同指令的动作。而最近来自Facebook的研究人员提出了一个能从真实视频中抽取可控制主角的模型Vid2Game,这意味你可以将视频中喜欢的主人公变成可以在游戏中控制的主角。

让我们先来看看效果,从真实视频中抽取的主角被放置到了新背景中,随着按键的控制左右移动挥拍击球。

黑衣服的运动员被妥妥地安排到了不同的背景中,随着键盘的指令移动。这是怎么做到的呢?为了实现对主体的控制和生成需要解决一下几个问题:首先需要将主体从环境中分离出来以便在新的任意的背景中生成;由于渲染阴影、反射、运动效果等、这种分离不是二值化的;用户给出的控制信号任意的x,y位移、如何编码并将控制量馈入主体生成中;最后需要处理生成序列过程中积累误差的影响。

那么文章中具体是如何做到的呢?

下面让我们一起来看看背后的原理。Vid2Game包含了两个神经网络和三个主要步骤的工作流程,首先利用第一个神经网络将当前位姿和控制信号映射到下一时刻的新位姿;随后利用新位姿和给定的背景输出希望的帧,包括背景和主体以及主体的mask;最后将生成的主体以背景融合生成最终输出。这种通用的方法可以被广泛用于多种不同运动场景中。给定视频中的主角可以根据用户的控制,生成在目标背景中运动的视频。两个序列形式工作的模型分别是Pose2Pose和Pose2Frame。

Pose2Pose网络基于用户的控制序列信号以自回归的方式操作给定的位姿,实现在特定的域内基于2D控制信号引导人体位姿生成。

通过输入t-1时刻的位姿和对应物体、在用户控制序列的操作下生成t时刻的主角位姿和对应物体。上图中我们可以看到输入的运动员位姿图和对应的球拍、同时输入的还有控制量。我们还可以看到中间的n-2个条件残差模块是基于质心位移量进行处理的。在训练时,质心唯一来自于训练序列的编码、而推理时则来自于用户输入。

随后将生成的位姿及给定的背景输入Pose2Frame将生成高分辨率的真实视频序列。同样以运动员作为例子,将运动员位姿和网球拍的序列输入,模型将生成一个RGB图像和mask图像.RGB图像考虑了运动员在环境中需要包括了阴影、反射等渲染,而mask辅助融合运动员与给定背景。通过mask与生成的rgb相乘得到运动员部分的RGB图像、再通过背景抠出mask区域随后融合运动与与给定背景,即得到运动员在新环境中生成的受用户控制的帧。

对于判别器部分、模型主要关注多尺度情况下二进制阈值主体。其中o为基准图像f为生成图像,在放入多尺度判别器前需要进行均值pooling减采样,。放入VGG分类器中的图像则保持了原始分辨率用于给出感知损失。Pose2Pose和Pose2Frame的生成器和判别器都使用了pix2pixHD架构来作为基础网络,并进行了一系列改进。同时利用了基于DensePose的方法来对位姿进行表示,同时使用了语义分割的方法来对运动员手持物体进行抽取。

通过这样的方法,就可以在希望的场景中合成你可控制的主角了。这对于未来个性化游戏、虚拟显示等具有十分重要的意义。从各种视频中抽取主角、并可以通过键盘在游戏中控制真的很棒!

让我们来跳一支舞吧:

控制你的主角四处漫游:

到任何想去的地方打球:

与龙来一场战斗吧:

-

神经网络

+关注

关注

42文章

4771浏览量

100739 -

图像

+关注

关注

2文章

1084浏览量

40457 -

Facebook

+关注

关注

3文章

1429浏览量

54731

原文标题:Facebook提出Vid2Game模型,帮助你来控制视频里的主人公动起来~

文章出处:【微信号:thejiangmen,微信公众号:将门创投】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

研究人员提出了“Skim-RNN”的概念,用很少的时间进行快速阅读

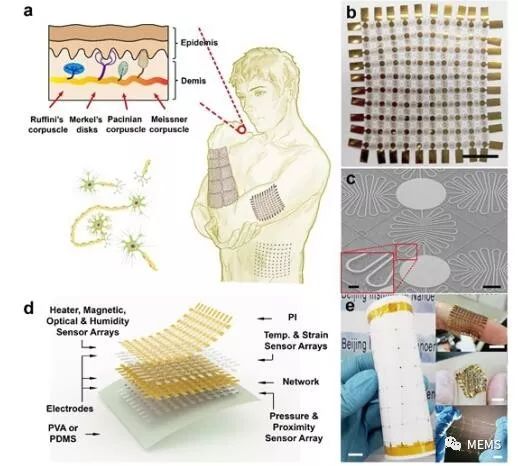

研究人员提出了一种柔性可拉伸扩展的多功能集成传感器阵列

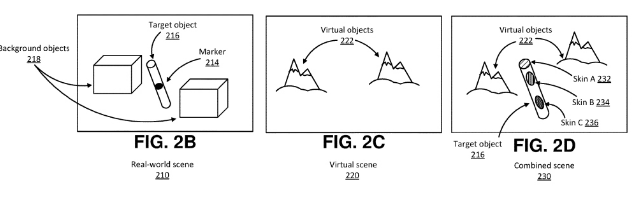

Facebook提出了一种在虚拟现实环境中表征真实世界对象的解决方案

Facebook构建虚拟空间训练AI

研究人员们提出了一系列新的点云处理模块

Facebook的研究人员提出了一个能从真实视频中抽取可控制主角的模型Vid2Game

Facebook的研究人员提出了一个能从真实视频中抽取可控制主角的模型Vid2Game

评论