作者:Arm 战略与生态部人工智能和开发者平台与服务高级副总裁 Alex Spinelli

通过 Arm 计算平台与 ExecuTorch 框架的结合,使得更小、更优化的模型能够在边缘侧运行,加速边缘侧生成式 AI 的实现。

新的 Llama 量化模型适用于基于 Arm 平台的端侧和边缘侧 AI 应用,可减少内存占用,提高精度、性能和可移植性。

全球 2,000 万名 Arm 开发者能够更迅速地在数十亿台边缘侧设备上大规模开发和部署更多的智能 AI 应用。

Arm 正在与 Meta 公司的 PyTorch 团队携手合作,共同推进新的 ExecuTorch 测试版 (Beta) 上线,旨在为全球数十亿边缘侧设备和数百万开发者提供人工智能 (AI) 和机器学习 (ML) 功能,进而确保 AI 真正的潜力能被最广泛的设备和开发者所使用。

借助 ExecuTorch 和新的 Llama 量化模型,Arm 计算平台优化生成式 AI 性能

Arm 计算平台无处不在,为全球众多边缘侧设备提供支持,而 ExecuTorch 则是专为移动和边缘侧设备部署 AI 模型而设计的 PyTorch 原生部署框架。两者的紧密合作,使开发者能够赋能更小、更优化的模型,包括新的 Llama 3.2 1B 和 3B 量化模型。这些新模型可以减少内存占用、提高准确性、增强性能和提供可移植性,成为小型设备上的生成式 AI 应用的理想选择,如虚拟聊天机器人、文本摘要和 AI 助手。

开发者无需额外的修改或优化,便可将新的量化模型无缝集成到应用中,从而节省时间和资源。如此一来,他们能够迅速在广泛的 Arm 设备上大规模开发和部署更多的智能 AI 应用。

随着 Llama 3.2 大语言模型 (LLM) 新版本的发布,Arm 正在通过 ExecuTorch 框架优化 AI 性能,使得在 Arm 计算平台边缘设备运行的真实生成式 AI 工作负载能更为快速。在 ExecuTorch 测试版发布的首日起,开发者便能享有这些性能的提升。

集成 KleidiAI,加速端侧生成式 AI 的实现

在移动领域,Arm 与 ExecuTorch 的合作意味着众多生成式 AI 应用,如虚拟聊天机器人、文本生成和摘要、实时语音和虚拟助手等,完全能够在搭载 Arm CPU 的设备上以更高的性能运行。这一成果得益于 KleidiAI,它引入了针对 4 位量化优化的微内核,并通过 XNNPACK 集成到了 ExecuTorch 中,因此,在 Arm 计算平台上运行 4 位量化的 LLM 时,无缝加速 AI 工作负载的执行。例如,通过 KleidiAI 的集成,Llama 3.2 1B 量化模型预填充阶段的执行速度可以提高 20%,使得一些基于 Arm 架构的移动设备上的文本生成速度超过了每秒 400 个词元 (token)。这意味着,终端用户将从他们移动设备上获得更快速、响应更灵敏的 AI 体验。

为物联网的边缘侧 AI 应用加速实时处理能力

在物联网领域,ExecuTorch 将提高边缘侧 AI 应用的实时处理能力,包括智能家电、可穿戴设备以及自动零售系统等。这意味着物联网设备和应用能够以毫秒级的速度响应环境变化,这对保障安全性和功能可用性至关重要。

ExecuTorch 可在 Arm Cortex-A CPU 和 Ethos-U NPU 上运行,以加速边缘侧 AI 应用的开发和部署。事实上,通过将 ExecuTorch 与 Arm Corstone-320 参考平台(也可作为仿真固定虚拟平台 (FVP) 使用)、Arm Ethos-U85 NPU 驱动程序和编译器支持集成到一个软件包中,开发者可在平台上市前几个月就着手开发边缘侧 AI 应用。

更易获取、更快捷的边缘侧 AI 开发体验

ExecuTorch 有潜力成为全球最受欢迎的高效 AI 和 ML 开发框架之一。通过将应用最广泛的 Arm 计算平台与 ExecuTorch 相结合,Arm 正在通过新的量化模型加速 AI 的普及,让开发者能够更快地在更多设备上部署应用,并将更多生成式 AI 体验引入边缘侧。

-

ARM

+关注

关注

134文章

9097浏览量

367588 -

AI

+关注

关注

87文章

30897浏览量

269117 -

人工智能

+关注

关注

1791文章

47279浏览量

238519

原文标题:ExecuTorch 测试版上线,加速 Arm 平台边缘侧生成式 AI 发展

文章出处:【微信号:Arm社区,微信公众号:Arm社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

中信建投建议关注端侧AI模组机会

从Apple Intelligence到IoT Intelligence,端侧生成式AI时代加速到来

GE医疗与亚马逊云科技达成战略合作,通过生成式AI加速医疗健康领域转型

NVIDIA推出NVIDIA AI Computing by HPE加速生成式 AI 变革

IBM与SAP深化生成式AI领域合作

Arm平台赋能移动端生成式AI

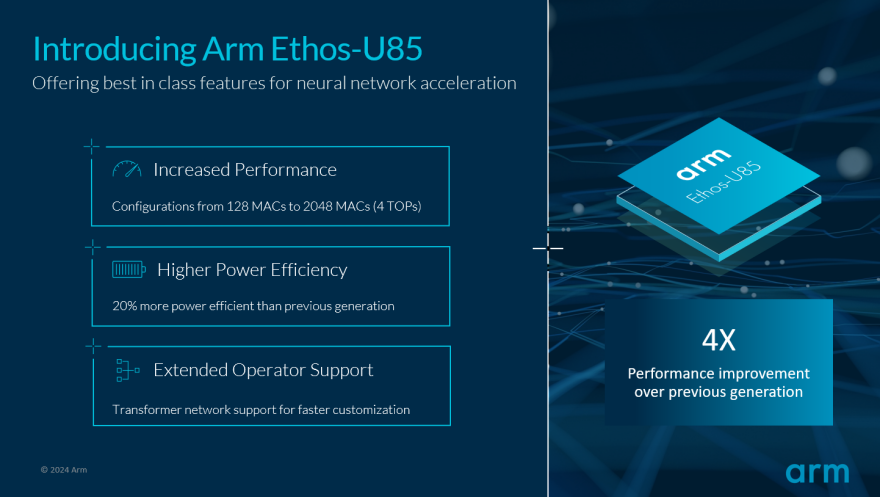

Arm推动生成式AI落地边缘!全新Ethos-U85 AI加速器支持Transformer 架构,性能提升四倍

Arm与ExecuTorch合作加速端侧生成式AI实现

Arm与ExecuTorch合作加速端侧生成式AI实现

评论