AI 计算资源的需求正不断增长。从概念验证到企业部署需要针对生成性 AI 工作负载进行优化的强大计算基础设施。同时,AI 开发项目需要更多的计算资源来支持不断增长的 AI 工程师和研究人员创建模型和应用程序。数据中心和云服务提供商 (CSP) 对 AI 加速硬件的需求超过供应。当前的桌面计算资源可能不适合 AI 增强型工作流程,因此出现硬件短缺的问题。

挑战

在快速发展的生成式 AI 领域,企业正寻求利用这项尖端威廉希尔官方网站 来获得竞争优势并加速创新。然而,生成式 AI 带来了一些挑战,可能会阻碍其有效部署和利用:

快速原型设计:开发人工智能应用程序需要快速原型设计和迭代,但缺乏工具、预建资源和计算能力会拖慢这一进程。

部署复杂性:在不同基础设施上部署 AI 模型既耗时又容易出错。

数据隐私和安全:对专有数据进行微调模型通常需要将敏感信息发送到外部服务器,这带来了重大风险。

性能优化:实现低延迟和高吞吐量对于实时应用至关重要,但如果没有专门的硬件和软件,则很难实现。

可扩展性:有效扩展数据处理和机器学习任务需要强大而有力的计算资源。

NVIDIA NIM和NVIDIA RTX驱动的 AI 工作站通过提供优化、安全且可扩展的 AI 开发解决方案,以及满足企业特定需求所需的惊人计算能力来解决这些挑战,促进生成式 AI 的有效部署和利用。

NVIDIA NIM 在搭载 RTX 威廉希尔官方网站 的

AI 工作站上的应用

NVIDIA NIM 是 NVIDIA AI Enterprise 的一部分,是一套易于使用的预构建容器工具,目的是帮助企业客户加速在云、数据中心和工作站中部署生成式 AI 模型。通过 NIM 可以部署广泛的 AI 模型 - 包括开源社区模型,NVIDIA AI Foundation 模型,和自定义模型。

RTX 驱动的 AI 工作站上的 NVIDIA NIM 微服务为开发人员集成生成式 AI 功能提供了强大而高效的解决方案。NIM 提供具有行业标准 API 的预构建容器,简化了 AI 模型部署,并允许开发人员专注于应用程序开发而不是基础设施管理。在 AI 工作站上本地运行 NIM 可让开发人员控制其数据,确保隐私和安全,同时避免与云托管 API 相关的延迟、成本和合规性问题。

NVIDIA RTX 驱动的 AI 工作站可在云端、数据中心和桌面上使用,配备最新的NVIDIA GPU (用于实体工作站的 NVIDIA RTX 5880 Ada 架构 GPU 和用于 RTX 虚拟工作站的 NVIDIA 数据中心 GPU),可为计算密集型 AI 工作负载提供支持。每个工作站最多配备四个 NVIDIA RTX 5880 Ada 架构 GPU,AI 工作站可提供令人惊叹的 4.4 petaFLOPS 综合 AI 计算性能和 192GB 系统 GPU 总显存,以促进快速原型设计和测试。这些工作站加快了开发周期并能够无缝扩展到生产环境。AI 工作站上的 NIM 支持各个领域的各种模型⸺包括最新的大语言模型 (LLM),如 Qwen 和 YiLarge,使开发人员能够轻松创建复杂的 AI 驱动的应用程序,并能够随时使用最先进的功能。

快速创建支持 RAG 的应用程序

RTX 驱动的 AI 工作站上的 NIM 微服务为创建本地 RAG 应用程序提供了强大的解决方案,确保对数据和模型的完全控制,尤其是对于数据安全和隐私至关重要的行业。开发人员可以快速制作 RAG 应用程序的原型、部署和迭代,在安全的本地环境中开发创新。

此外,运行 NIM 微服务的多 GPU 工作站可以作为小型团队的集中式 RAG 应用程序中心,提供企业级生成式 AI 功能,而无需依赖云资源。这些基于工作站的 RAG 应用程序可以处理多模态输入,包括文本、语音和图像,同时得益于 NVIDIA 的优化推理引擎,实现高性能、低延迟响应。

利用 NVIDIA NIM 随时随地

构建生成式 AI 应用程序

NVIDIA 开发者计划会员现可免费使用 NVIDIA NIM 预构建容器工具。

注册开发者计划 (NVIDIA Developer Program),可免费访问并下载 NIM,用于在一定数量 GPU 上进行研究,开发和测试(详情参照申请页)。当准备投入生产时,开发人员可以获得 NVIDIA AI Enterprise,它提供企业级安全性、支持和 API 稳定性。

NVIDIA NIM 可以帮助开发人员实现:

通过针对低延迟、高吞吐量 AI 推理优化的加速推理引擎获得卓越性能。

在任何地方的 NVIDIA GPU 上运行 AI 模型并保持对 AI 应用程序和数据的控制。

使用行业标准 API 和流行的应用程序开发工具、框架简化 AI 应用程序开发。

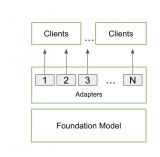

通过无缝部署 NIM 来针对特定用例定制模型,以便根据数据对模型进行微调。

使用详细的可观察性指标和 Helm 图表在 Kubernetes 上扩展 NIM,最大限度地提高操作性和规模。

了解如何优化生成 AI 应用程序的开发以部署在任何 NVIDIA 加速基础设施上,同时仍然保持对 IP 和 AI 应用程序的完全控制。

-

NVIDIA

+关注

关注

14文章

4985浏览量

103026 -

AI

+关注

关注

87文章

30830浏览量

268992 -

人工智能

+关注

关注

1791文章

47244浏览量

238370 -

机器学习

+关注

关注

66文章

8414浏览量

132607

原文标题:NVIDIA 解决方案:借助搭载 NVIDIA RTX 的 AI 工作站和 NVIDIA NIM 加速并优化 AI 开发

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NVIDIA推出适用于网络安全的NIM Blueprint

NVIDIA助力企业创建定制AI应用

NVIDIA 携手全球合作伙伴推出 NIM Agent Blueprints,助力企业打造属于自己的 AI

RTX AI PC和工作站提供强大AI性能

借助NVIDIA NIM加速AI应用部署

NVIDIA NIM微服务带来巨大优势

全新NVIDIA NIM微服务将生成式AI引入数字环境

NVIDIA NIM:打造AI领域的AI-in-a-Box,提高AI开发与部署的高效性

英伟达推出全新NVIDIA AI Foundry服务和NVIDIA NIM推理微服务

宁畅推出首款专业级AI桌面工作站W350 G50

NVIDIA推出用于支持在全新GeForce RTX AI笔记本电脑上运行的AI助手及数字人

英伟达推出AI模型推理服务NVIDIA NIM

NVIDIA将全球数百万开发者转变为生成式 AI 开发者

NVIDIA NIM 革命性地改变模型部署,将全球数百万开发者转变为生成式 AI 开发者

NVIDIA NIM在搭载RTX威廉希尔官方网站

的AI工作站上的应用

NVIDIA NIM在搭载RTX威廉希尔官方网站

的AI工作站上的应用

评论