对于许多机器学习算法来说,最终要解决的问题往往是最小化一个函数,我们通常称这个函数叫损失函数。在神经网络里面同样如此,损失函数层(CostLayer)和Optimizers因而应运而生(……),其中:

CostLayer 用于得到损失

Optimizers 用于最小化这个损失

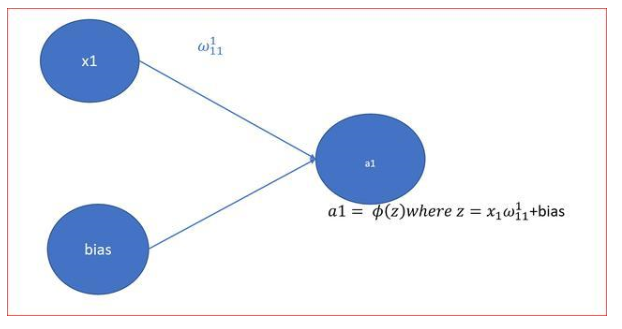

需要一提的是,在神经网络里面,可以这样来理解损失:它是输入 x 经过前传算法后得到的输出和真实标签y 之间的差距。如何定义这个差距以及如何缩小这个差距会牵扯到相当多的数学知识,我们这里就只讲实现,数学层面的内容(有时间的话)(也就是说基本没可能)(喂)会在数学系列里面说明。感谢万能的 tensorflow,它贴心地帮我们定义好了损失函数和 Optimizers,所以我们只要封装它们就好了

CostLayer

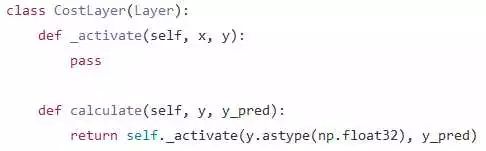

先定义一个基类:

相当于我们把 Layer 的激活函数“偷换”成了损失函数。calculate 函数用于直接计算损失,它只在复杂模型中分析模型表现时用到,可以暂时不管

再定义实际应用的 CostLayer,我们以应用最广泛的 CrossEntropy 为例:

Optimizers

这一部分的封装做得更加没有营养,大部分代码都仅仅是为了和我自己造的轮子的接口 一致。最关键的部分只有两行:

其中 self._opt 是 tensorflow 帮我们定义好的 Optimizers 中的一个,它的作用也很简单粗暴:更新 session 中的各个变量以使得损失 x 向最小值迈进

以上,CostLayer 和 Optimizers 的定义、功能和实现就说得差不多了;再加上前几章,一个完整的、较朴素的神经网络就完全做好了,它支持如下功能:

自定义激活函数

任意堆叠 Layer

通过循环来堆叠重复的结构

通过准确率来评估模型的好坏

这不算是一个很好的模型、但已经具有了基本的雏形,走到这一步可以算是告一段落。接下来如果要拓展的话,大致流程会如下:

在训练过程中记录下当前训练的结果、从而画出类似这样的曲线:

让模型支持比较大规模数据的训练,它包括几个需要改进的地方:

我们目前没有把数据分割成一个个小 batch 来训练我们的模型;但当数据量大起来的时候、这种处理是不可或缺的

我们目前做预测时是将整个数据扔给模型让它做前传算法的。数据量比较大时,这样做会引发内存不足的问题,为此我们需要分批前传并在最后做一个整合

我们目前没有进行交叉验证,这使我们的模型比较容易过拟合。虽然其实让用户自己去划分数据也可以,但留一个接口是好的习惯

最后也是最重要的,当然就是把我们的模型扩展成一个支持 CNN 模型了。这是一个巨坑、且容我慢慢来填……

-

神经网络

+关注

关注

42文章

4771浏览量

100723

原文标题:从零开始学人工智能(6)--Python · 神经网络(五)· Cost & Optimizer

文章出处:【微信号:AI_shequ,微信公众号:人工智能爱好者社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

神经网络中的损失函数层和Optimizers图文解读

神经网络中的损失函数层和Optimizers图文解读

评论