MiniCPM-V 2.0: 具备领先OCR和理解能力的高效端侧多模态大模型

一背景

今年4月份,面壁智能&清华大学自然语言处理实验室推出MiniCPM系列的最新多模态版本MiniCPM-V 2.0。该模型基于MiniCPM 2.4B和SigLip-400M构建,共拥有2.8B参数。MiniCPM-V 2.0具有领先的光学字符识别(OCR)和多模态理解能力。该模型在综合性OCR能力评测基准OCRBench上达到开源社区的最佳水平,甚至在场景文字理解方面实现接近Gemini Pro的性能。简单来说,就是能够实现更好地理解图片中内容,实现精准的“以图生文”的能力,所见即所得。

本文将通过走马观花的方式,初探MiniCPM-V 2.0的新特性。同时也将分享基于爱芯元智的AX650N芯片适配MiniCPM-V 2.0的最新进展,向业界对端侧多模态大模型部署的开发者提供一种新的思路,促进社区对端侧多模态大模型的探索。

二MiniCPM-V介绍

2.1 MiniCPM-V 2.0特性

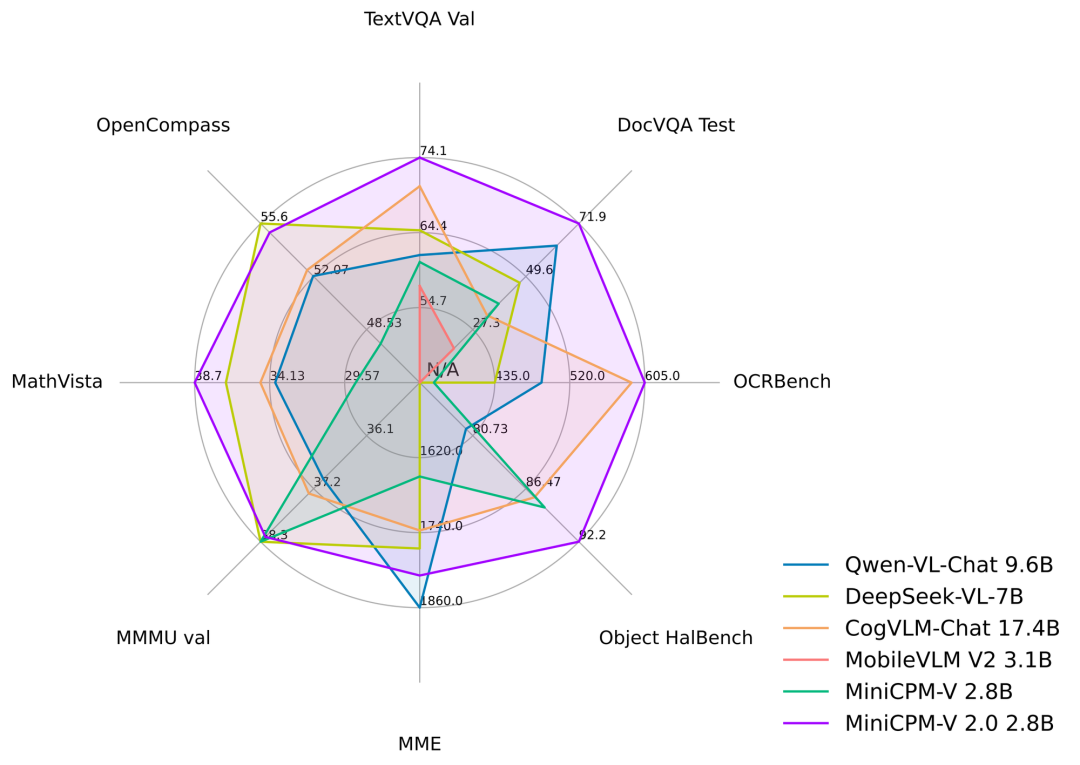

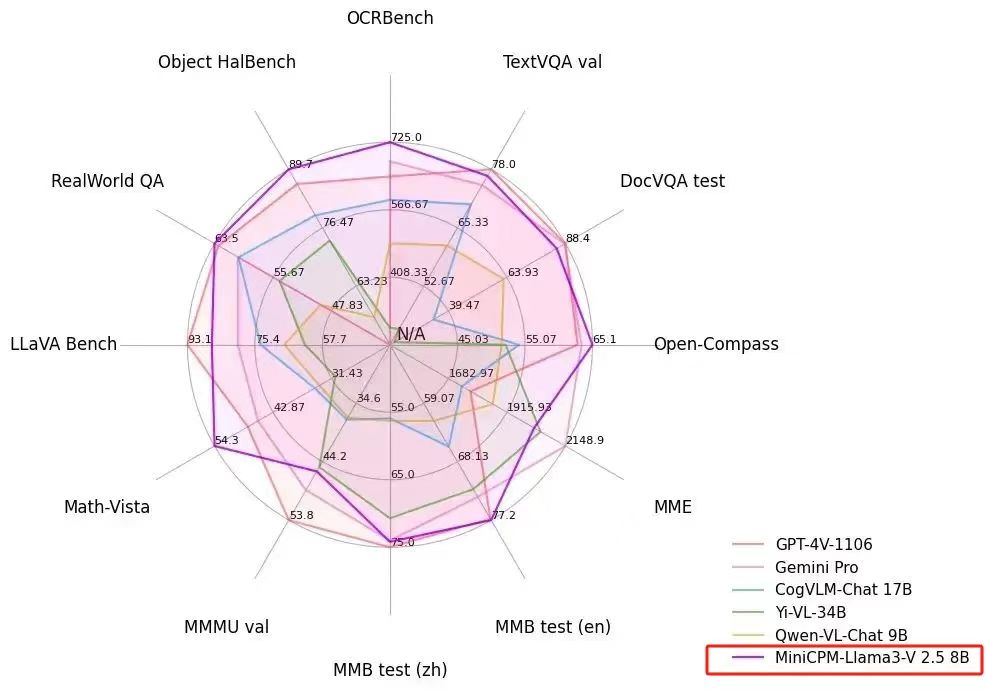

● 领先的OCR和多模态理解能力。MiniCPM-V 2.0显著提升了OCR和多模态理解能力,场景文字理解能力接近Gemini Pro,在多个主流评测基准上性能超过了更大参数规模(例如17-34B)的主流模型。

● 可信行为。MiniCPM-V 2.0是第一个通过多模态RLHF对齐的端侧多模态大模型。该模型在Object HalBench达到和GPT-4V相仿的性能。

● 任意长宽比高清图像高效编码。MiniCPM-V 2.0可以接受180万像素的任意长宽比图像输入(基于最新的LLaVA-UHD威廉希尔官方网站 ),这使得模型可以感知到小物体、密集文字等更加细粒度的视觉信息。

● 高效部署。MiniCPM-V 2.0可以高效部署在大多数消费级显卡、个人电脑以及移动手机等终端设备。

● 双语支持。MiniCPM-V 2.0提供领先的中英双语多模态能力支持。该能力通过VisCPM[ICLR'24]论文中提出的多模态能力的跨语言泛化威廉希尔官方网站 实现。

2.2 多模态“小钢炮”

MiniCPM-V 2.0与参数规模更大的多模态大模型相比,也表现出优秀的成绩,不愧是业界“小钢炮”。

三芯片介绍

3.1 AX650N

爱芯元智第三代高能效比智能视觉芯片AX650N。集成了八核Cortex-A55 CPU,高能效比NPU,支持8K@30fps的ISP,以及H.264、H.265编解码的 VPU。接口方面,AX650N支持64bit LPDDR4x,多路MIPI输入,千兆Ethernet、USB、以及HDMI 2.0b输出,并支持32路1080p@30fps解码内置高算力和超强编解码能力,满足行业对高性能边缘智能计算的需求。通过内置多种深度学习算法,实现视觉结构化、行为分析、状态检测等应用,高效率支持基于Transformer结构的视觉大模型和语言类大模型。提供丰富的开发文档,方便用户进行二次开发。

四上版部署

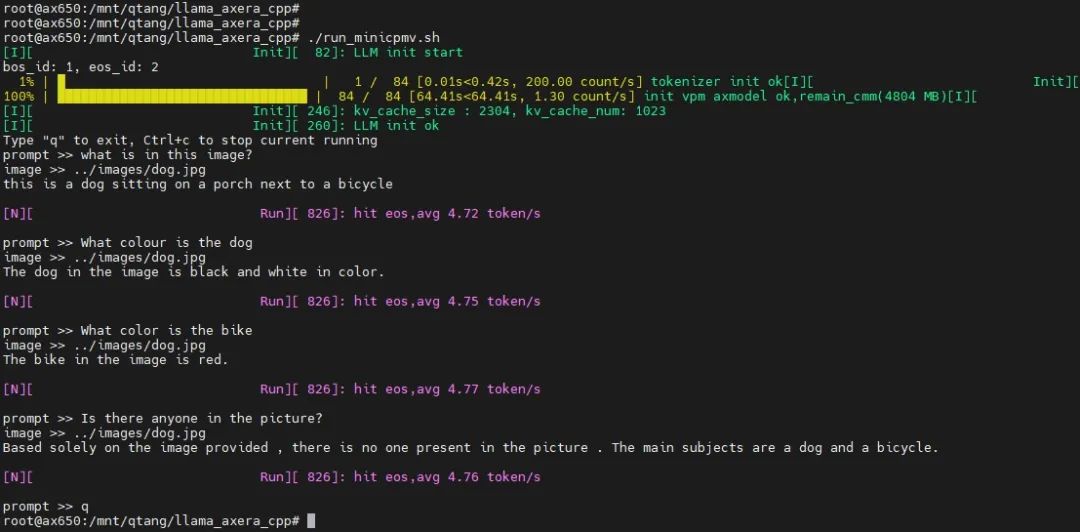

我们已实现“命令行”和“UI”两种示例,其中“命令行”版本已上传到网盘中,欢迎试用。

4.1 命令行版本

测试图片:

测试结果:

4.2 GUI版本

4.3 性能统计

| 项目 | 描述 |

| 输入图片大小 | 280 x 280 |

| Image Encoder | 0.8s |

| Input Prompt | 96 tokens |

| Prefill Time | 0.4s |

| Decoder | 5 tokens/s |

五结束语

随着大语言模型小型化的快速发展,越来越多有趣的多模态AI应用将逐渐从云端服务迁移到边缘侧设备和端侧设备。我们会紧跟行业最新动态,适配更多的端侧大模型,欢迎大家持续关注。

-

自然语言处理

+关注

关注

1文章

618浏览量

13553 -

爱芯元智

+关注

关注

1文章

78浏览量

4830 -

大模型

+关注

关注

2文章

2425浏览量

2645

原文标题:爱芯分享 | 基于AX650N部署MiniCPM-V 2.0

文章出处:【微信号:爱芯元智AXERA,微信公众号:爱芯元智AXERA】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于AX650N/AX630C部署多模态大模型InternVL2-1B

爱芯元智发布第三代智能视觉芯片AX650N,为智慧生活赋能

【爱芯派 Pro 开发板试用体验】爱芯元智AX650N部署yolov5s 自定义模型

【爱芯派 Pro 开发板试用体验】爱芯元智AX650N部署yolov8s 自定义模型

爱芯元智第三代智能视觉芯片AX650N高能效比SoC芯片

基于AX650N部署DETR

基于AX650N部署EfficientViT

爱芯元智AX650N成端侧、边缘侧Transformer最佳落地平台

多模态大模型产业高峰论坛成功举办 ChatImg2.0、软通天璇2.0 MaaS平台重磅发布

基于AX650N部署视觉大模型DINOv2

爱芯元智AX620E和AX650系列芯片正式通过PSA Certified安全认证

基于AX650N芯片部署MiniCPM-V 2.0高效端侧多模态大模型

基于AX650N芯片部署MiniCPM-V 2.0高效端侧多模态大模型

评论