电子发烧友网报道(文/周凯扬)AI大模型似乎陷入了一个怪圈,尽管对于深度学习、数据优化和爆款应用的研究从来没有终止,但大多数人开口问的第一句话就是,“你有卡吗”?从行业对GPU的狂热追求来看,未来继续扩展大模型的机会,似乎只会被大公司掌握在手中。

xAI拉拢戴尔和超微打造AI超算,马斯克继续买买买

xAI作为2023年3月才成立的一家初创公司,在构建算力基础设施的投入上却一点也不含糊,不过这也多亏了背后的金主埃隆马斯克。近日,戴尔CEO Michael Dell宣布他们正在打造一个由英伟达GPU驱动的AI工厂,为xAI的Grok模型提供动力。不过马斯克随即表示,戴尔只是其中一半服务器集群的供应商,另外一半的超算系统则是由超微打造。

由此推测,这一AI工厂应该就是马斯克在月初提到的10万块H100液冷训练集群了,尽管有两家供应商同时为xAI打造服务器,但市面上的GPU需求依然维持在高位,还需要几个月这一集群才会正式上线,用于Grok的下一代大模型迭代。

H100这张2023年发布的GPU可以说是目前全球大模型算力供应的主力,无论是OpenAI还是xAI,其最新模型都是基于该GPU训练迭代的。H100无论是显存容量、带宽和算力性能都实现了一轮新的突破,甚至可以说H100带动了这一代AI大模型的发展,然而在GTC之后,马斯克已经开始眼馋最新的B200了。他认为考虑到目前的威廉希尔官方网站

演进速度,实在不值得把1GW的电力供应给H100。

为此xAI也已经开始在规划下一代系统,据马斯克透露,该系统将由30万块B200 GPU组成,但上线时间需要等到明年夏天了。B200速度高达H100的4倍,更是可以轻松做到单机柜1exaflop的算力表现,更何况在能耗成本上,B200相比H100改善了20多倍,即便是大规模部署,也不会让厂商面临供电和碳足迹的双重困扰。

尽管xAI的AI超算目标已经明确,但对于马斯克旗下的另一家公司特斯拉而言,其威廉希尔官方网站

路线依旧不算明朗。虽然特斯拉也开启了新一轮的英伟达GPU采购潮,但其内部也在继续发展自研的Dojo超算。只不过近年来Dojo的情报越来越少,就连马斯克自己也将其列入“远景计划”之列。

OpenAI与微软,“鲸级”超算已在全速运转中

相信不少人都还记得去年11月首度上榜TOP500的微软超算Eagle,这台空降第三的AI超算凭借14400个英伟达H100和561PFlop/s的算力,不仅让Azure系统再次闯进了前十,还拿下了当下云端超算最高的排名。而当时的Azure还未部署完成,虽然最新的排名中Eagle依然维持在第三的位置,但其核心数已经近乎翻倍。

这台超算为OpenAI的GPT-4训练和推理提供了极大的助力,但这远没有达到微软的财力极限。早在3月底,就有消息传出微软和OpenAI正在打造一个代号名为“星门”的AI超算,耗资高达1000亿美元。微软CTO Kevin Scott称不少有关其超算计划的推测简直错得可笑,但也指出他们确实会为这一计划付出不少努力和成本。

在上个月举办的Microsoft Build中,Kevin Scott公开透露了他们未来的超算扩展计划。2020年,微软为OpenAI打造了第一台AI超算,正是因为这台机器才孕育了GPT-3。而他们构建的下一个系统,也就是Eagle,则用于训练GPT-4。Kevin Scott选择了用海洋生物来描述这些超算的规模,比如首台超算可以用鲨鱼来描述,Eagle则是虎鲸,而他们的下一台超算规模则可以比拟蓝鲸。

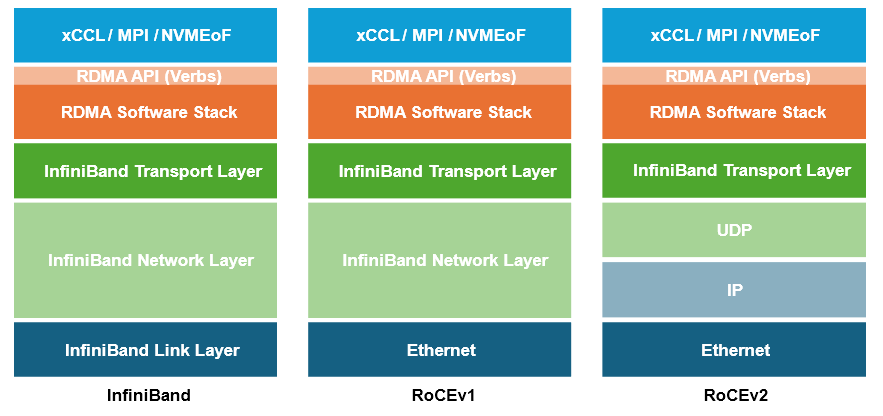

Kevin Scott更是强调,别看现在Eagle可以排到第三名的位置,从现在开始微软每个月都会部署五台同样规模的超算,也就是说每月都有至少搭载72000个H100 GPU或同等规模系统投入应用,每月带来2.8exaflops的算力增长。同时,他们用来连接GPU的高速和InfiniBand线缆可以绕地球至少五周,也就是说长度在20万公里以上总线缆长度。

很明显,作为已经凭借OpenAI获得成功的微软来说,接下来需要赢下的就是这场Scaling之战。

TPU和GPU并用,谷歌的Hypercomputer

尽管不少巨头都在考虑如何自研芯片来降低购置海量GPU带来的成本,但真的成功将其用于大模型的训练中去的,已经迭代至第六代的谷歌TPU,恰好就为谷歌解决了这个问题。TPU作为谷歌和博通联合设计了几代的产品,在谷歌自己推出的各种新模型训练与推理中,重要性已经等同于英伟达的GPU了。

谷歌本身作为在AI算法和大模型上耕耘了诸多时间的巨头,从设计芯片之初就知道他们需要何种计算资源,正因如此,TPU几乎将所有的面积都分给了低精度的张量计算单元。这种ASIC方案也让谷歌大幅降低了打造AI Hypercomputer的成本。

但谷歌作为云服务厂商巨头还是逃不开通用性的问题,谷歌的TPU更多是为Gemini的模型做了优化,尽管TPU支持PyTorch、Tensorflow等常见AI模型,但在追求极致性能的选择上,还是难以媲美GPU。正因如此,在谷歌和其他大模型开发者的眼中,TPU固然性能不弱,但更像是一个性价比之选。用于已经成功商业化模型的降本增效属于不错的选择,但如果想要在这个竞争激烈的大模型市场杀出重围,那就只有谷歌能将TPU物尽其用。

在不少AI芯片厂商的宣传中,为了抬高自己的专用产品定位,将英伟达的GPU还是定性为图形处理单元。可在H100这种规模的GPU上,无论是性能和能效,也毫不输某些专用开发环境下的ASIC,至于未来更复杂的图形处理,英伟达也推出了L4 GPU这样的对应方案。

在今年GTC上,谷歌的云服务部门也宣布和英伟达达成深度合作关系,通过英伟达的H100和L4 GPU支持使用其云服务的AI开发者。同时谷歌也将购置GB200 NVL72系统,基于谷歌云的A3实例为开发者提供DGX Cloud的云端LLM托管方案,这也是对现有H100机器的升级。除此之外,就连谷歌自己的JAX框架,也在双方的合作之下,在英伟达的GPU上得到了支持。可以看出,谷歌还是采取两手抓的策略,TPU和GPU一并重要。

全力追逐Scaling Laws的大厂们

对于AI大模型而言,模型大小、数据集大小和计算成本之间不仅组成了三元关系,也代表了模型性能。而Scaling Laws这一扩展法则定义了三者之间势必会存在某种比例扩展,只不过如今看来,其边际效应已经变得越来越大。以GPT为例,如果GPT-6继续按照这样的比例扩展下去,且不说性能提升有限,即便微软这样的商业巨头也很难撑起成本的剧增。

可就是这样微不可察的差距,甚至对于AI大模型的常见应用聊天机器人来说只是速度和精度上的一些差距,却决定了他们在之后的十几年里能否继续制霸下去。微软作为已经在操作系统上实现霸权地位的厂商,自然也明白先入为主的重要性。

在边际效应的影响下,即便后入局的巨头,也有不少迎头赶上的机会,比如近期传出正在秘密研发Metis聊天机器人的亚马逊。亚马逊同样拥有自研服务器芯片的威廉希尔官方网站

积累,但主要优势还是在CPU上,AI加速器相关的产品(Inferentia和Trainium)依旧有比较大的改进空间,而且与亚马逊自己的业务还没有紧密结合起来。如果亚马逊愿意去打造这样一个聊天机器人应用,很有可能后续也会加强在GPU上的投入,而不再紧紧作为云托管方案。

-

gpu

+关注

关注

28文章

4729浏览量

128899 -

AI

+关注

关注

87文章

30762浏览量

268905

发布评论请先 登录

相关推荐

《算力芯片 高性能 CPUGPUNPU 微架构分析》第3篇阅读心得:GPU革命:从图形引擎到AI加速器的蜕变

GPU算力开发平台是什么

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】--全书概览

名单公布!【书籍评测活动NO.43】 算力芯片 | 高性能 CPU/GPU/NPU 微架构分析

算力服务器为什么选择GPU

摩尔线程与师者AI携手完成70亿参数教育AI大模型训练测试

万卡集群解决大模型训算力需求,建设面临哪些挑战

卡都去哪了?AI超算成了GPU的无底黑洞

卡都去哪了?AI超算成了GPU的无底黑洞

评论