电子发烧友网报道(文/黄山明)现如今,不少终端产品中都安装了AI程序,不过这些AI程序基本上都需要通过互联网访问云端AI服务,来实现各种智能化功能,例如语音识别、图像识别、自然语言处理等。这种模式下,用户的终端设备并不需要强大的本地AI处理能力,而是将数据上传至云端服务器,在那里由大型AI模型进行复杂的计算处理,并将结果返回给用户。

但随着人们需求提升,尤其是对设备的响应速度与稳定性,还有个性化服务需求的增加,本地AI可以根据用户的特定习惯和偏好进行优化,使得体验更为个性化和无缝。

更重要的一点是,本地处理用户数据可以减少数据泄露的风险,因为数据不需要被发送到云端服务器,这在一定程度上增强了用户对隐私的保护。并且在没有互联网连接的情况下,本地AI仍然可以正常运作,而依赖云端的智能家居设备可能会失去部分或全部功能。

高通的现任CEO安蒙曾公开表示,“真正有趣的地方在于让生成式AI在智能手机本地运行,而不是云端”,安蒙认为“生成式AI的变革意义在于终端上的信息能够帮助AI成为无处不在的个人助手”。

当然,部署本地AI除了上述的原因外,网络通畅性也至关重要。虽然如今5G已基本完成覆盖,但完全跟不上AI的发展速度。数据显示,一家波音787每秒产生5GB的数据,而全球每时每刻都有数千驾飞机正在空中飞行,高通发布的《混合AI是AI的未来》中显示,相比传统方式,生成式AI的搜索成本增加了10倍,全球每天产生超过100亿次的搜索查询量。

随着边缘计算威廉希尔官方网站

的进步,越来越多的智能设备具备了一定程度的本地AI计算能力,能够在离数据源头更近的地方进行预处理或初步决策,减轻云端压力的同时也提高了效率。

不仅是高通,包括英伟达、AMD、英特尔等企业都认为,本地AI计算、AI应用本地化将会是未来主要发展方向之一。

本地AI面临的难题

想要在本地部署AI,让设备可以离线运行,就需要确保终端设备具备足够的计算能力,如CPU、GPU或TPU,以保证在有限的空间和功耗预算内完成实时推理。另一方面,AI模型往往体积庞大,尤其是在深度学习领域。要在本地部署,必须优化模型大小,使其适合小型化的智能家居设备有限的内存和存储资源。

为了适应硬件限制,需对AI模型进行剪枝、量化或知识蒸馏等操作,以降低计算复杂度和资源占用。同时开发节能型AI算法和硬件架构,确保在提供智能服务的同时不影响设备整体的能源效率。

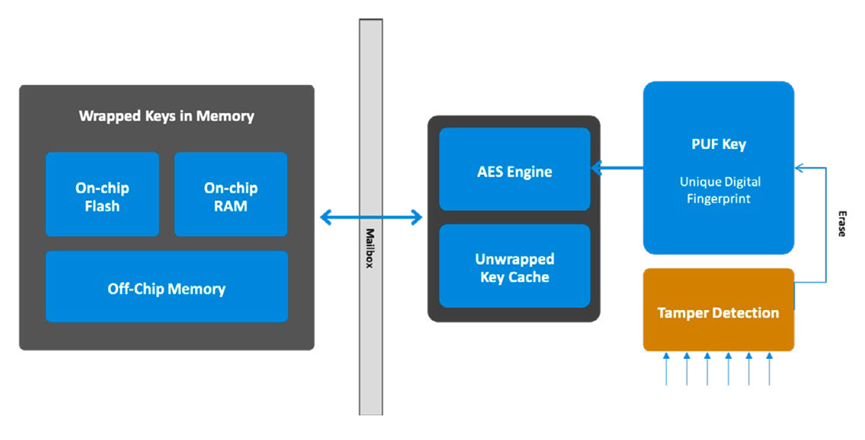

在数据处理与隐私保护上,需要确保本地存储和处理的数据受到充分的安全保护,防止未经授权的访问和泄露。还要确保AI算法能在特定的嵌入式操作系统上稳定运行,并适配各类传感器及设备接口驱动。

不过即使在本地处理,也需要与云端及其他智能家居设备之间保持良好互联,以便在必要时进行数据交换和协同工作。

体验上,本地AI需要提供与云端相似的用户体验,包括快速响应用户命令并做出准确判断。设计合理的故障检测和恢复机制,并能方便地进行远程或本地固件更新,包括AI模型的迭代升级。

因此,在目前来看,普通个人用户想要在本土部署大模型AI的门槛较高,一个是普通用户在威廉希尔官方网站

能力上无法完成本体部署,另一方面,AI威廉希尔官方网站

比如AI生图等功能对性能要求较高,普通的芯片难以应付,而专用芯片价格又比较昂贵。

同时,不管是什么类型的AI应用,算力都是绕不开的话题,如何做到快速响应、低延迟等特点,就需要有强力的本地AI算力支持。针对那些大型的家电设备而言可能还好,但对于一些小型的智能家居产品,如智能助手、智能中控屏等,在追求更强AI算力的同时,还需要平衡好功耗,降低对内存带宽、显存的高依赖。

当然,阻碍本土AI应用发展的最大难题,或许不在威廉希尔官方网站

层面,而在于商业运作上,如何实现有效的盈利模式,让企业有动力去推进本地AI。

小结

尽管云端AI服务广泛应用,但在特定需求和环境下,本地AI仍然具有不可替代的价值。现代智能设备通常采用混合策略,即根据应用场景灵活利用云端和本地AI资源。而本地AI的部署,也将是主流AI芯片企业未来的重要发展方向。

-

AI

+关注

关注

87文章

30763浏览量

268909 -

智能家居

+关注

关注

1928文章

9556浏览量

184960

发布评论请先 登录

相关推荐

传感器类型在智能家居中的应用

云端ai开发环境怎么样

智能家居之旅(15):HA传感器采集主板低功耗设计的遭遇

人工智能如何强化智能家居设备的功能

有了云端,智能家居还有必要部署本地AI吗?

有了云端,智能家居还有必要部署本地AI吗?

评论