3月19日消息,NVIDIA宣布成功研发AI加速卡——Blackwell GB200,预计年内开始交付。这是NVIDIA在GTC开发者大会上所公布的最新成果。

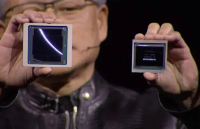

GB200创新性的运用了NVIDIA独创的新一代AI图形处理器架构Blackwell。NVIDIA CEO黄仁勋明确指出:“尽管Hopper已然优秀,但我们需要更强的GPU推动发展。”

得益于NVIDIA每两年进行一次GPU架构升级以提高性能的策略,全新的基于Blackwell的加速卡比之前的H100更为强大,尤其适用于AI相关任务。

Blackwell GPU卓越表现使得AI性能达到惊人的20PetaFLOPS。相比之下,基于Hoper架构的H100仅为4PetaFLOPS。NVIDIA强调,这种额外的处理能力将极大地便利人工智能厂商顺利培训复杂且大规模的模型。

Blackwell GPU大大刷新了人们的认知,其庞大身形由台积电4纳米(4NP)工艺制成,包含两个独立制造的裸晶(Die),共有2080亿个晶体管。为了方便捆绑芯片,它采用NVLink 5.0威廉希尔官方网站 。两枚Blackwell芯片在同一封装中,相较以往的GPU而言,整体性能显著提升达2.5倍,若处理FP4八精度浮点运算,则性能甚至可飙升至5倍之多。校园秘

关于GB200,NVIDIA宣称,其合成物包括两个B200 Blackwell GPU以及一个基于Arm的Grace CPU。很多人惊讶地发现 NvTech的首批量产计算机将其性能获得了提升超过30倍,同时降低成本和能耗。根据NVIDIA的数据分析,他们现有的硬件只用2000个Blackwell GPU就够再去完成诸如1.8万亿个参数模型这样的运算任务,且只消耗4兆瓦的电力。在参数为1,750亿的GPT-3 LLM基准测试中,Nvidia的GB200的性能甚至超越了H100 7倍。规律纪律意识

对于致力于拥有庞大需求企业的成品服务,NVIDA推出了包含36个CPU及72个Blackwell GPU的NVL72服务器,并附赠一体式水冷散热解决方案,产能可实现高达720 PetaFLOPS的AI训练性能,或者达到惊人的1,440 PetaFlops。另外,还有144个壁搏立帆、576个GPU以及240TB的内存。单据一份官方报道显示,早先以至于要运行一带有1.8万亿个参数模型的堆栈,原先需要8000个 Hopper GPU,外加15兆瓦的电力。

英伟达透露,同类机型已被亚马逊、谷歌、微软和甲骨文计划纳入他们的云服务产品之中,由于对具体采购量的保密,外界暂无确切消息。但据Nvidia表示,已经接到了Amazon AWS对于采用2万片 Blackwell芯片建成的服务器集群的购买计划。通过Node-to-Node NVLink 5.0,每个机架将被18块GB200芯片和9块交换机装满。而不同于此,英伟达的 Skeeter InfiniBand可连接多达144个节点,Quantum-X800 InfiniBand则最高可支持64个节点。

-

NVIDIA

+关注

关注

14文章

4983浏览量

103010 -

gpu

+关注

关注

28文章

4733浏览量

128911 -

AI

+关注

关注

87文章

30805浏览量

268942

发布评论请先 登录

相关推荐

大模型向边端侧部署,AI加速卡朝高算力、小体积发展

EPSON差分晶振SG3225VEN频点312.5mhz应用于AI加速卡

英伟达Blackwell可支持10万亿参数模型AI训练,实时大语言模型推理

YXC高频差分晶振,频点312.5mhz,高精度.高稳定性,应用于AI加速卡

苹果AI模型训练新动向:携手谷歌,未选英伟达

NVIDIA突破美国禁令,将在中东部署其高性能AI/HPC GPU加速卡

英伟达总市值破2.5万亿美元

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

英伟达发布最强AI加速卡Blackwell GB200

英伟达发布性能大幅提升的新款B200 AI GPU

今日看点丨英伟达发布最强 AI 加速卡--Blackwell GB200;三星面临罢工 存储市场供需引关注

英伟达发布超强AI加速卡,性能大幅提升,可支持1.8万亿参数模的训练

英伟达发布超强AI加速卡,性能大幅提升,可支持1.8万亿参数模的训练

评论