NVIDIA AI GPU无疑是当下的硬通货,从科技巨头到小型企业都在抢。

Meta(Facebook) CEO扎克伯格近日就透露,为了训练下一代大语言模型Llama 3,Meta正在建造庞大的计算平台,包括将在今年底前购买多达35万块NVIDIA H100 GPU。

届时,再加上其他GPU,Meta拥有的总算力将相当于几乎60万块H100!

根据市调机构Omdia的数据,Meta 2023年买了多达15万块NVIDIA GPU,能与之媲美的只有微软,而亚马逊、甲骨文、谷歌、腾讯等都只拿到了5万块左右。

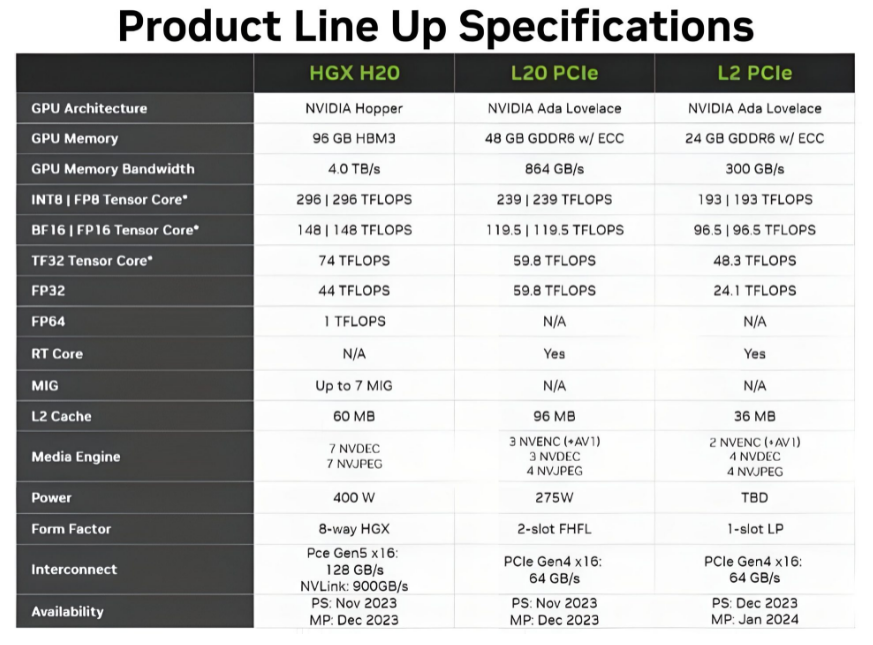

SemiAccurate的首席分析师Dylan Patel指出,2024年第一季度,H100、H200、GH100、GH200、H20等基于最新Hopper架构的GPU出货量有望达到77.3万块,第二季度增至81.1万块。

而在2023年第二季度,Hopper家族GPU只出货了大约30万块。

另外值得一提的是,Meta也在购买AMD最新的Instinct MI300系列GPU,但具体数量不详。

微软也是AMD Instinct的大客户。

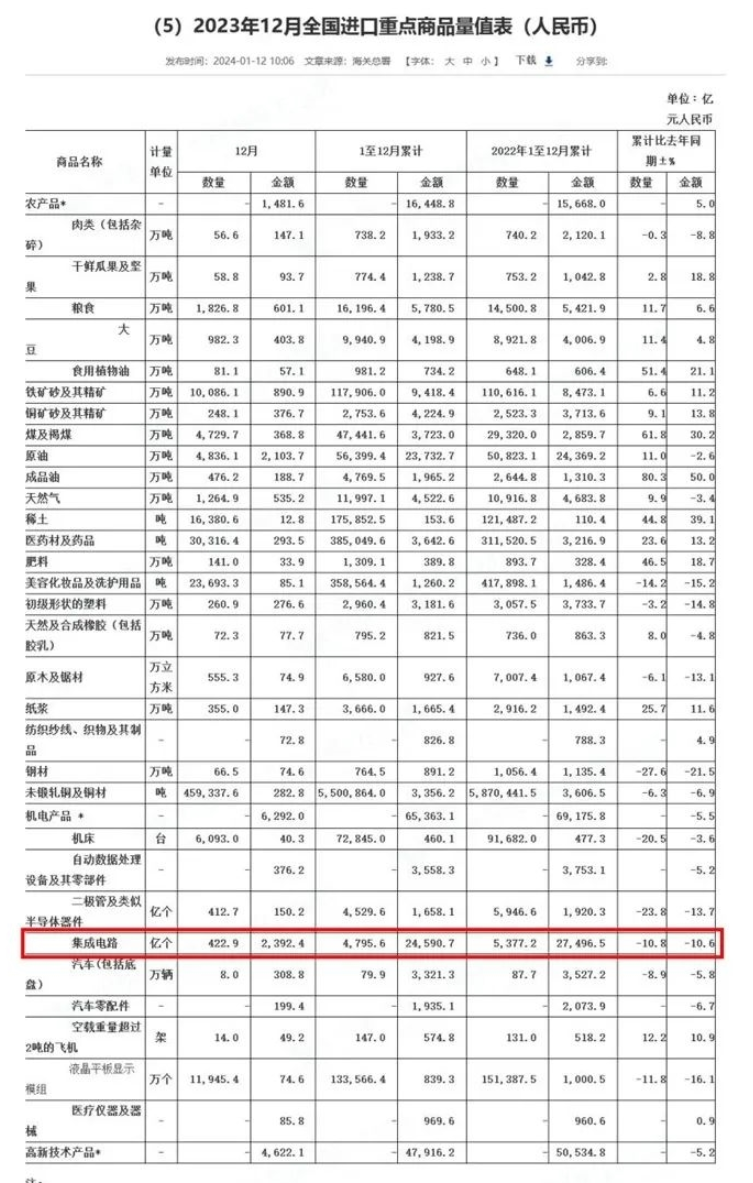

据海关总署公布的最新数据,2023年全年中国集成电路进口数量为4795.6亿颗,同比减少10.8%,金额为24590.7亿元人民币,同比减少了10.6%。

不过,进口金额如果以美元计,将是3490亿美元,与2022年相比大跌15.4%。

此外,2023年中国进口的二极管和类似半导体组件(普通商品芯片的代表)的数量也大幅下降了23.8%至4529.6亿颗,进口金额同比下滑23.8%至1658.1亿元人民币。

虽然由于全球经济疲软,2023年全球芯片市场也出现了11%的同比下滑至5330 亿美元,但中国的芯片进口额(以美元计)下滑幅度更大。

至于原因也不难猜测,全球经济恢复缓慢、中国通货紧缩、中美贸易战、厂商供应链转移和分散、美国对中国半导体全面封锁……

审核编辑:刘清

-

半导体

+关注

关注

334文章

27161浏览量

217621 -

NVIDIA

+关注

关注

14文章

4967浏览量

102901 -

gpu

+关注

关注

28文章

4717浏览量

128813

原文标题:巨头豪购35万块NVIDIA最强GPU H100:还在买AMD

文章出处:【微信号:hdworld16,微信公众号:硬件世界】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

Supermicro推出直接液冷优化的NVIDIA Blackwell解决方案

英伟达H100芯片市场降温

马斯克自曝训练Grok 3用了10万块NVIDIA H100

英伟达去年数据中心GPU出货量占比约98%

首批1024块H100 GPU,正崴集团将建中国台湾最大AI计算中心

德克萨斯大学将创建一个学术界最强大的生成性人工智能研究中心

英伟达GB200芯片售价7万美元,服务器单价或达30万

特斯拉和xAI筹集H100芯片,以推动L5级自动驾驶和“终极真相人工”的实现

H100 GPU供应改善,AI市场需求依旧强劲

扎克伯格的Meta斥资数十亿美元购买35万块Nvidia H100 GPU

Meta计划至2024年末购买35万张H100加速卡

NVIDIA GPU因出口管制措施推迟发布

巨头豪购35万块NVIDIA最强GPU H100

巨头豪购35万块NVIDIA最强GPU H100

评论