这篇mylangrobot项目由neka-nat创建,本文已获得作者Shirokuma授权进行编辑和转载。

https://twitter.com/neka_nat

GitHub-mylangrobot :GitHub - neka-nat/mylangrobot: Language instructions to mycobot using GPT-4V

引言

本项目创建了一个使用GPT-4V和myCobot的一个演示,演示机械臂简单得到拾取操作,这个演示使用了一个名叫SoM(物体检测对象)的方法,通过自然语言生成机器人动作。通俗点换一句话来说就是,机器接受自然语言,去寻找目标然后让机械臂进行抓取的一个案例。

本项目的亮点主要是GPT-4V的图像处理和SoM物体检测算法相结合,通过自然语言和机器交互实现机械臂运动。

软件

SoM

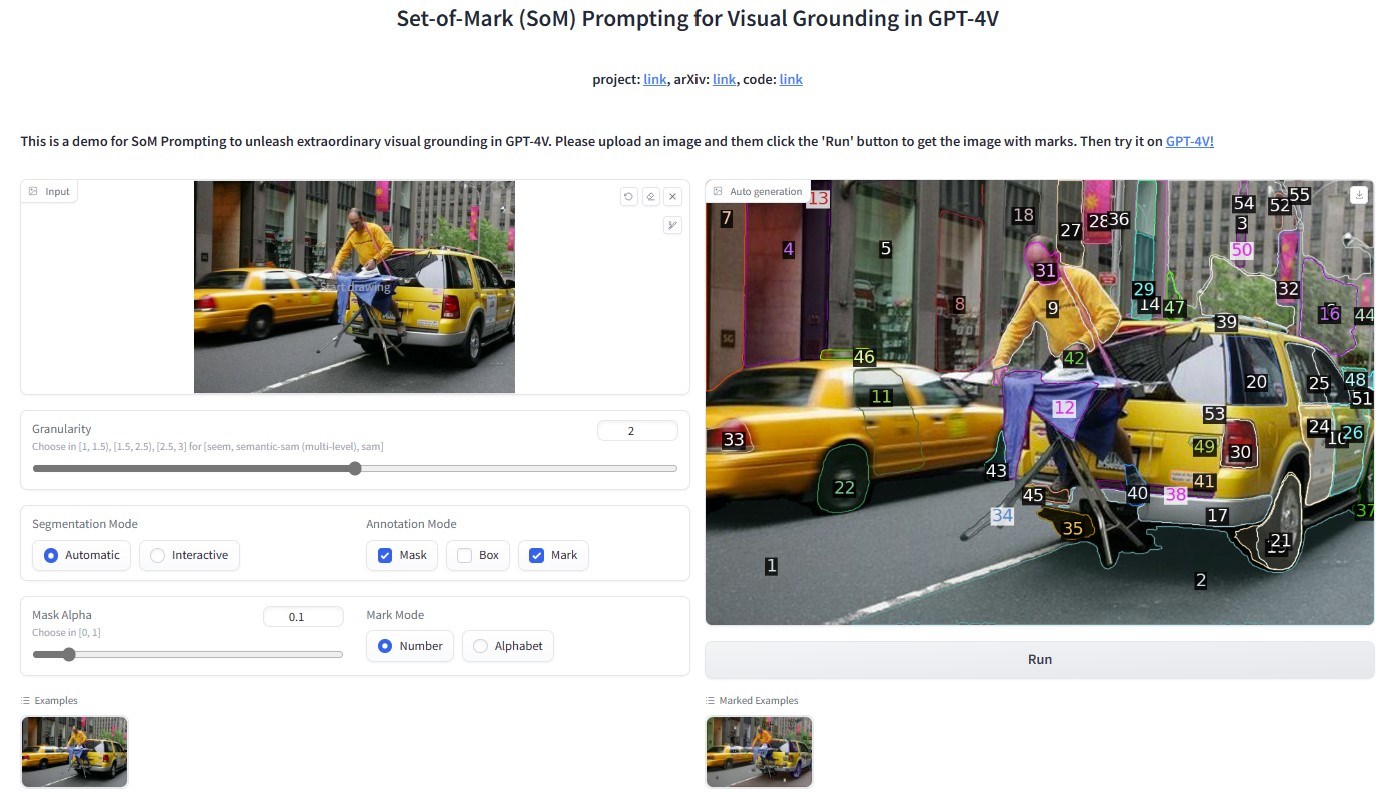

Set of Mark(SoM)是一种用于增强大型语言模型的视觉理解能力。图像经过SoM处理之后能够在图像上添加一系列的标记,这些标记能够被语言类模型识别和处理。这些标记有助于模型更准确的识别和理解图像中的物体和内容。

这使得语言模型能够针对图像中的元素进行更精准的分析和描述,从而提高其在视觉任务上的表现。

GPT-4V

我们常聊的GPT是一个大预言模型,我们可以跟它进行对话聊天。在迭代新的版本的GPT-4V是一个大模型多模态语言模型,它不单单能处理文本信息,现在还能够处理图像信息。能够对图像理解,图像生成,图像描述的功能,这样大模型结合GPT-4的强大自然语言处理能力和现金的图像分析威廉希尔官方网站

,可以提供更高效和更准确的视觉和语言综合能力。

下面是OpenAI 提供的例子

简要介绍:将一个视频提供给GPT4,通过GPT-4V对图像的处理,生成对视频讲解的内容的过程。原文链接:Processing and narrating a video with GPT's visual capabilities and the TTS API | OpenAI Cookbook

User:

"These are frames from a video that I want to upload. Generate a compelling description that I can upload along with the video."

视频中某一帧的图像

#GPT-4V对图像的描述处理

GPT4:

"

审核编辑 黄宇

-

机器人

+关注

关注

211文章

28390浏览量

206959 -

人工智能

+关注

关注

1791文章

47208浏览量

238303 -

GPT

+关注

关注

0文章

354浏览量

15348 -

机械臂

+关注

关注

12文章

513浏览量

24558

发布评论请先 登录

相关推荐

【「具身智能机器人系统」阅读体验】+初品的体验

《具身智能机器人系统》第1-6章阅读心得之具身智能机器人系统背景知识与基础模块

【书籍评测活动NO.51】具身智能机器人系统 | 了解AI的下一个浪潮!

报名开启!深圳(国际)通用人工智能大会将启幕,国内外大咖齐聚话AI

英伟达利用人工智能和Omniverse加速人形机器人开发

FPGA在人工智能中的应用有哪些?

人工智能与机器人的区别

其利天下威廉希尔官方网站 ·搭载无刷电机的扫地机器人的前景如何?

5G智能物联网课程之Aidlux下人工智能开发(SC171开发套件V1)

晶泰科技携手ABB机器人打造柔性智能自动化的实验室

创想焊缝跟踪系统适配欢颜机器人真正实现焊接自动化和智能化

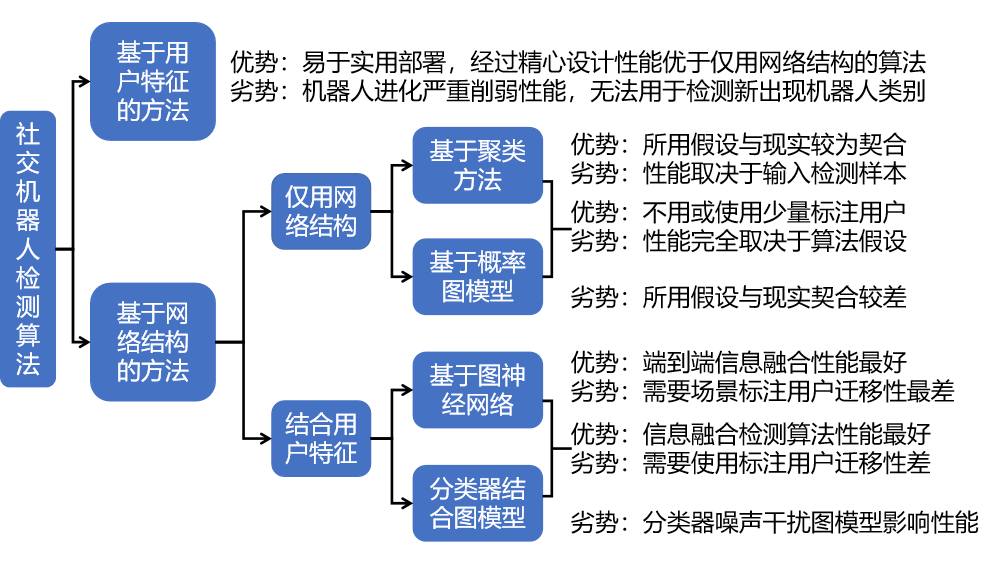

网络社交机器人检测的关键威廉希尔官方网站

利用人工智能和机器人威廉希尔官方网站

实现复杂的自动化任务!

利用人工智能和机器人威廉希尔官方网站

实现复杂的自动化任务!

评论