电子发烧友网报道(文/周凯扬)随着AI芯片逐渐成为半导体市场的香饽饽,与之相关的附属产物也在不断升值,被一并炒热。就拿高带宽内存HBM来说,无论是英伟达的GPU芯片,还是初创公司打造的AI芯片,又或是大型CSP自研的服务器芯片,都开始引入HBM。

成为新时代另一主流的HBM

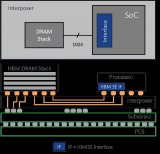

过去HBM主要用于AMD或英伟达的高端GPU产品中,这与成本息息相关,比如额外的硅中介层、更大的封装等,增加的系统成本使得HBM只会出现在一些顶级消费级产品中,甚至两者最终都在消费级产品上放弃了HBM,改用于数据中心这样的企业级场景。

可随着人工智能/机器学习的需求驱动这类产品用量增长,内存墙的瓶颈开始显现。我们不再缺超高性能的CPU,缺的反而是超高性能的GPU/AI加速器,以及更高带宽的内存,应对大量低延时的数据移动。

所以HBM被认为是AI/ML时代下的首选内存,为某些算法提供了训练所需的最大带宽,比如最近英伟达公布的第二代Grace Hopper Superchip,就分成了不同GPU内存配置的版本,率先推出的是搭载96GB HBM3的版本,明年第二季度将推出搭载144GB HBM3e的版本。

HBM的市场供应已经发生变动

要说HBM的供应商,主要是SK海力士、三星和美光。TrendForce通过当下各大供应商的生产计划数据分析,内存厂商正在提高其产能,比如扩大TSV产线等。预计到2024年,HBM供应将增加105%。其中SK海力士因为收获了来自英伟达的大量订单,所以尚且占据头号交椅的位置。而在三星的奋起直追下,已经拉近了与SK海力士的市占比距离。

三星作为存储厂商和晶圆代工厂,既提供了HBM方案也提供了对应的多HBM封装方案,这种一站式的方案也收获了更多的订单。根据韩媒的报道,三星与可能会与英伟达在年末达成服务与供应协议,为英伟达的H100以之后搭载HBM3的芯片提供HBM产能,

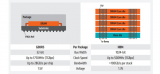

至于美光虽然也有HBM产品,但主要优势还是在传统内存上。可随着生成式AI一炮走红之后,美光也开始决心在HBM产品上奋起直追。比如上个月底,美光就基于其先进的1β工艺节点,发布了业界首个8-high 24GB HBM3第二代产品,带宽可达1.2TB/s以上,并宣布已经开始送样。

美光也在通稿中专门提到了该HBM产品对于GPT-4等生成式AI应用起到的助力,比如为AI推理提供更高的能效比,以及为运营者提供更优的TCO解决方案。此外,美光已经开始准备12-high的36GB版本,并计划于2024年第一季度送样。

至于HBM的价格问题,鉴于目前主流芯片用的还是HBM2和HBM2e,且出货量仍在增加,所以短期内不会有太大的波动。不过,TrendForce预计随着HBM3的推出,以及H100等基于HBM3设计的AI芯片逐渐面世,老一代HBM内存的价格应该会有所下跌,让位给ASP价格更高但性价比依然有所提升的HBM3。

小结

尽管HBM以及后续迭代的版本解决了当下AI计算的内存墙问题,但内存厂商们考虑到传统内存最近的库存情况,明显对于满足客户需求、扩大市场份额以及避免产能过剩有了新的权衡,在产能扩张的决策上也会更加谨慎。

发布评论请先 登录

相关推荐

爱普生投影机成为高校教室焕新的新宠儿

军工领域新宠儿:一体化摄像机机芯模组的应用与突破

DDR5内存面临涨价潮,存储巨头转向HBM生产

岳信:高效、精准、可靠汽车线束连接器气密性检测的科技新宠儿

MX系列数字调音台如何成为音响扩声系统新宠儿

SK海力士、三星电子:HBM内存供应充足,明年HBM4将量产

SK海力士加速HBM4E内存研发,预计2026年面市

SK海力士将采用台积电7nm制程生产HBM4内存基片

英伟达CEO赞誉三星HBM内存,计划采购

什么是HBM3E内存?Rambus HBM3E/3内存控制器内核

SK海力士宣布HBM内存生产配额全部售罄

掌控未来:DCS vs PLC,谁将成为工业控制的新宠儿?

深度解析HBM内存威廉希尔官方网站

继续加大产量,HBM成内存厂商的新宠儿

继续加大产量,HBM成内存厂商的新宠儿

评论