电子发烧友网报道(文/周凯扬)随着AI计算在数据中心逐渐占据主导地位,整个服务器系统架构中的虚拟化、网络交换对硬件提出了更高的需求,为了降低进一步CPU的负载,DPU也就应运而生。通过使用DPU,各种架构的CPU不仅降低了功耗,还提升了效率,完美符合当下对绿色计算的追求。

DPU真的能省钱吗?

虽然依据各大DPU厂商的说法,大规模使用DPU可以降低总成本,不过这一观点在过去以FPGA和ASIC主导的SmartNIC设计架构的时期很难成立。FPGA更高的成本使得云服务厂商难以通过较低的成本来实现规模化。而ASIC方案灵活可编程的能力较低,难以跟上时刻在迭代和扩充的网络环境,后续升级成本较高。

而如今普及的SoC方案,则通过结合不同的架构,降低成本的同时极大地提高了其灵活性。比如博通的Stingray就是Arm+ASIC的SoC方案,英特尔的IPU则是FPGA+x86或FPGA+Arm的SoC方案,Marvell的OCTEON 10也是Arm+ASIC的SoC方案等等。

这也就是为何不少云服务厂商纷纷投入使用DPU的原因,通过卸载CPU的负载,降低了整个系统的功耗,从而大幅降低了能源成本。以使用英伟达DPU的爱立信为例,据其公布的数据,他们在使用DPU后将服务器CPU的功耗降低至145W,相比过去节约了24%的能耗。

这样的数字在单个CPU,以及短运行周期内看起来似乎不算什么,但对于大型数据中心而言,这样的数字就意味着单个DPU应用就可以在三年间省下近200万美元的成本。同样可以从中受益的还有OVS这一虚拟交换机应用,根据英伟达公布的数据,在使用BlueField-2来承接原本由CPU负责的交换任务后,单台服务器的功耗可降低29%,达到305W。对于10000台服务器的数据中心来说,也就是3年内近500万美元的成本节约。

CSP纷纷选择了自研DPU

至于从云厂商的角度,那DPU是否省钱这一问题的答案就更明显了。不少云服务厂商开始意识到,与其选择第三方DPU,倒不如走上自研这条路。头部CSP发现自研DPU不仅可以减少系统成本,还能解决数据中心在管理和虚拟化上的局限性,从而保证其产品优势。

比如字节跳动早在2020年就开启了自研DPU氦卡的研发,从2021年至今已经发布了氦卡的1.0、1.5和2.0版本。目前最新的氦卡2.0一斤支持到网络、存储和虚拟化全量加速。这对于字节旗下的火山引擎来说,不仅实现了IaaS、PaaS和存储资源统一的完全并池,也降低了成本,据字节跳动公布的数据氦卡使其TCO下降高达10%。

百度也在去年底发布了其自研DPU太行的2.0版本,新的DPU 2.0支持Intel、AMD和ARM平台,也同时支持计算、存储、网络和虚拟化等功能。百度也基于太行2.0 DPU这一计算底座,打造了vQPE、BTHv、BOE、BDMA、RDMA和BHQoS六大自研引擎,做到多协议、多场景、跨平台和低时延。

这与此前百度公布的太行DPU发展路径一致,从路线图上来看,未来的太行DPU 3.0将定位为云原生的IO引擎,实现BVC共平台、硬件资源的全面解耦以及软件定义实例等,做到端到端的极致性能。

写在最后

其实随着CSP纷纷自研DPU,这对于不少第三方DPU厂商都提出了一定的挑战。首先大型CSP厂商都有这样的能力去组建一个团队,来为其量身打造自研DPU,甚至是直接通过收购来完成这一目的,比如微软年初收购的Fungible。可以说,未来DPU厂商的竞争压力将进一步放大,不仅要和同行对手卷,还要和自己的客户卷。但好在对于使用云服务的用户来说,DPU的出现一定会进一步降低使用成本。

-

DPU

+关注

关注

0文章

358浏览量

24171

发布评论请先 登录

相关推荐

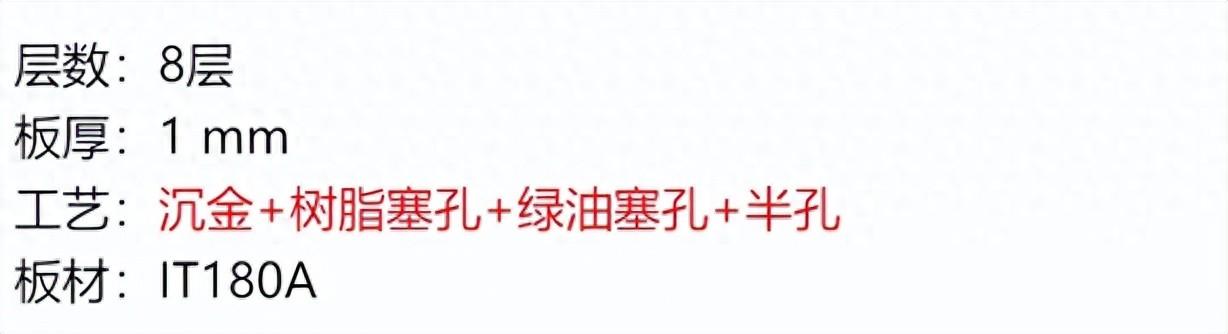

在树脂塞孔的设计上,工程师总觉得这样操作是节约成本其实是浪费

在树脂塞孔的设计上,工程师总觉得这样操作是节约成本,其实是浪费

IaaS+on+DPU(IoD)+下一代高性能算力底座威廉希尔官方网站 白皮书

芯片软件全上阵 DPU“全家桶”来了!中科驭数成功举办2024产品发布会

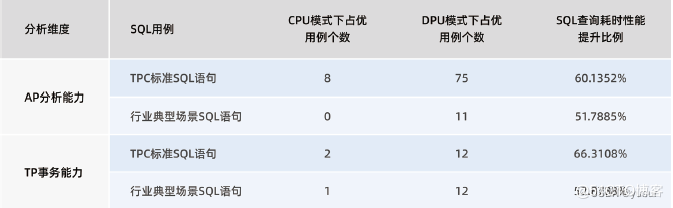

“Spark+Hive”在DPU环境下的性能测评 | OLAP数据库引擎选型白皮书(24版)DPU部分节选

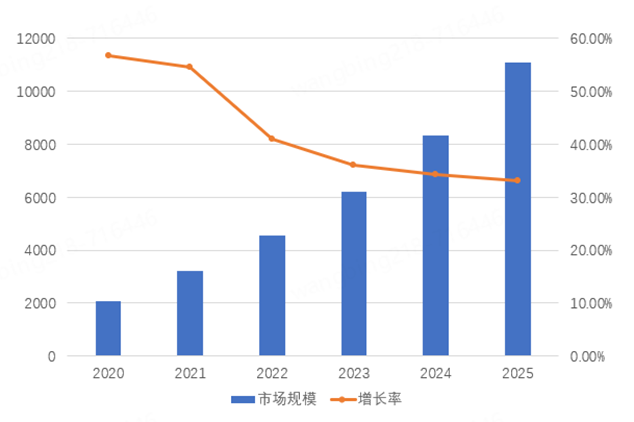

DPU,云厂商的节约成本的王牌

DPU,云厂商的节约成本的王牌

评论