电子发烧友网报道(文/吴子鹏)在交出一份相当不理想的Q1财报之后,三星电子终于决定,将削减存储芯片的产量,减产有望缓解供应过剩,提振陷入寒冬的半导体行业。

对于DRAM行业而言,这真的是巨大的利好,预计Q2将成为最后的调整期,然后产业走势开始上扬。元大证券分析师Gilhyun Baik表示,DRAM的价格在本季度预计将下降约10%,而过去两个季度的降幅分别为30%和20%,降价走势明显在收窄。

此前,我们在三星电子财报分析的文章中已经解读过三星电子对DRAM市场的影响力,这里不再展开。不过,就在市场回暖的过程中,DRAM大厂美光科技又抛出了一个重磅消息,DRAM在AI大模型风靡的当下,或将成为继GPU之外,另一个算力核心。

ChatGPT带火新存储威廉希尔官方网站 CXL

实际上,不仅是美光科技发出过此番言论。华西证券近日在研报中也指出,在AI的大时代下,DRAM有望成为继GPU后,另外一重要算力核心,同时DRAM的价值当前也被严重低估。

华西证券在研报中特别提到了CXL(Compute Express Link,计算快速链接)这项新威廉希尔官方网站

,认为随着CXL的应用渗透率提升,服务器也从传统围绕CPU的设计思路转向为以DRAM为中心的架构。AI将成为DRAM下一增长周期中最重要的增长引擎。

CXL是Compute Express Link Consortium联盟推出的一种新协议,是 PCI-e协议的升级威廉希尔官方网站

,主要解决处理器、加速器和内存之间的cache一致性问题。

CXL威廉希尔官方网站

的推出有望克服两大难题:内存墙和I/O墙。其中,内存墙是指内存性能严重限制CPU性能发挥的现象;I/O墙和内存墙类似,是指I/O性能严重限制CPU性能发挥的现象。

这两个墙问题的出现是因为,过去计算架构是以CPU为核心的,因此为了尽可能发挥CPU的性能,配置了多级存储,并且是计算和存储分离的,这就造成了内存墙,I/O墙则是因为数据传输的任务越来越多。

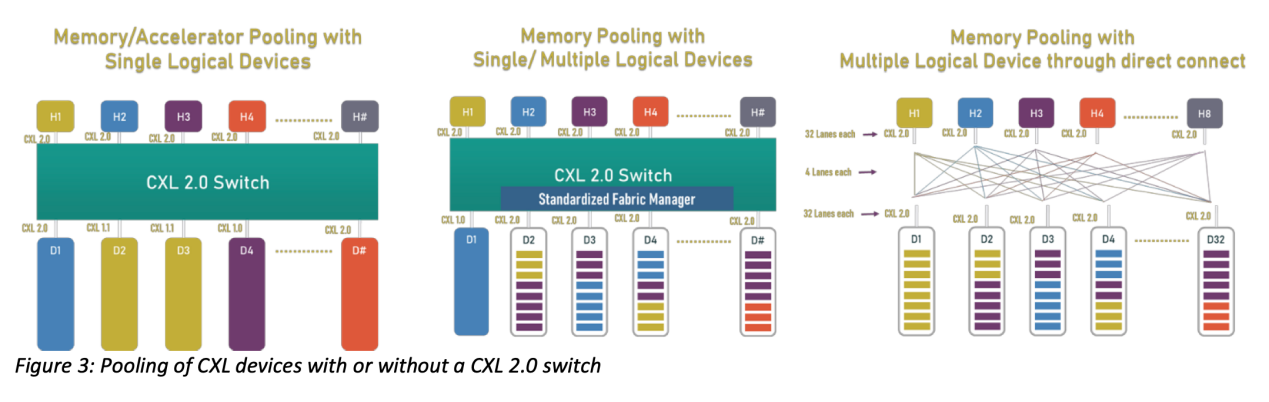

于是,产业界开始思考如何从数据存储端去解决问题。因此,我们看到,在CXL2.0标准中就开始推动内存的池化。通过下图能够看到,内存池化的好处是非常明显的,它让内存不再专属于某一个CPU,上面的CPU和下面的内存可以灵活地互联互通,因此大大提升了内存的使用效率。

图源:CXL联盟官网

2022年8月,CXL 3.0标准发布。CXL 3.0 侧重于在互连的几个关键领域实现重大改进。第一个是物理方面,CXL 3.0将其每通道吞吐量翻了一番,达到64 GT/秒;在逻辑方面,CXL 3.0大大扩展了标准的逻辑能力,允许复杂的连接拓扑和结构,以及在一组CXL设备内更灵活的内存共享和内存访问模式。

CXL 3.0标准进一步强化内存池化的概念,能够从硬件层面实现内存共享。CXL标准的快速发展也得到了行业的广泛关注,CXL联盟也随之成立,由英特尔牵头,联合阿里巴巴、戴尔EMC、Meta、谷歌、HPE、华为和微软共同建立,随后AMD、Arm加入其中。

并且,CXL标准不仅缓解了当前内存传输的带宽限制,也使得方案转变的重点从CPU转移到了内存产品,因此CXL存储器扩充成为主要的演进路线,而与之关系最密切的就是DRAM。

支持CXL标准的内存也被成为CXL内存,除了传输速度大幅提升,CXL内存另一个显著变化是内存容量的巨大变化,三星、SK海力士研发的CXL内存已经可以做到单条96GB甚至128GB,因此实现TB级别的内存已经不是什么难事。

在ChatGPT领域,CXL内存的主要应用场景目前还集中在具有高性能GDDR或HBM本地内存的通用加速器,也就是给GPU带来更好地内存支持。随着大模型数量和体量的提升,对于CXL内存的需求量也会快速提升,因此将其称为继GPU之后的另一大算力芯片也不为过。

在泛AI领域,CXL内存还可用作没有本地内存的专用加速器但可以利用CXL.io协议和 CXL.cache与主机处理器的内存;以及用于内存扩展板和存储级内存。

HBM大单、急单增加

正如上文中提到的,对于ChatGPT类型的AI大模型,主要需求集中在GDDR或HBM等高性能内存产品上,其中HBM的需求增加非常明显。当然,目前这部分产品主要还是遵循JEDEC组织颁布的标准,已经ready的最新标准是HBM3。

根据韩国媒体报道,近一段时间韩国内存大厂三星和SK海力士都接到了很多HBM内存的大单和急单。报道指出,全球最大的GPU公司英伟达一直在要求SK海力士提供最新的HBM3内存颗粒。供应链人士指出,最高性能的DRAM相比,HBM3目前的价格已经达到其5倍。

美光科技在2023财年第二财季业绩会纪要中指出,“如今,AI 服务器的DRAM需求量可以达到普通服务器的8倍,NAND需求量则是3倍。我们的产品路线图包括HBM3和CXL创新,期待可以在未来分享有关这些解决方案的更多细节。”“AI 的最新发展为大型语言模型或 LLM(例如 ChatGPT)的转换功能奠定了基石。”

美光科技的发言揭露的两大威廉希尔官方网站

趋势:其一是未来的HBM一定是和CXL深度融合,进一步提升HBM内存在容量和带宽方面的性能;其二是AI也将推动内存的威廉希尔官方网站

变革,HBM-PIM内存计算威廉希尔官方网站

有望成为AI大模型领域的新宠。

当前,对于AI大模型这波机遇,国内的内存产业有怎样的机会呢?从公开消息来看,目前国内还没有规模量产HBM内存的企业。江波龙董秘此前在投资平台表示,HBM威廉希尔官方网站

属于内存芯片英国威廉希尔公司网站

与内存模组应用的结合。公司目前暂未涉及相关的内存芯片设计研发,但公司将保持对该威廉希尔官方网站

的持续关注,并在产品应用层面上提前开展相关的研发布局工作。

不过,国内已经有公司在涉猎CXL内存领域。前不久,澜起科技已经宣布,其PCIe 5.0/CXL 2.0 Retimer芯片成功实现量产。

小结

ChatGPT以及国内AI大模型密集的发布给DRAM产业带来了新的发展机遇。由于应用的特殊性,AI大模型对HBM这种高级内存需求量更大,而国内在这方面还处于威廉希尔官方网站

攻关的阶段,没有公开的实质性进展。不过,CXL威廉希尔官方网站

的发展可能为国产DRAM企业带来转机,让普通DRAM内存能够参与到AI应用里。

从整体产业走势来看,三星减产和AI大模型需求将分别从供给和需求端带动DRAM产业,进入全新的旺周期。

-

DRAM

+关注

关注

40文章

2313浏览量

183459 -

GPT

+关注

关注

0文章

354浏览量

15359

发布评论请先 登录

相关推荐

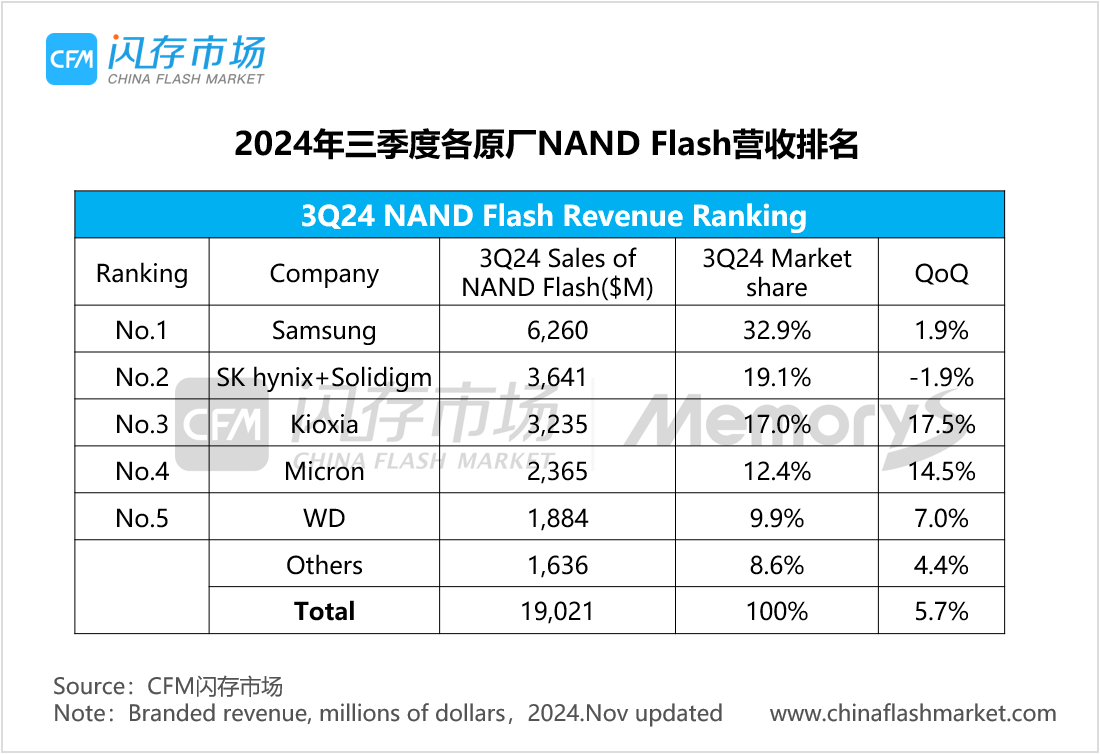

2024年第三季度全球DRAM市场营收环比增长13.6%

2023年全球DRAM内存模组市场营收下滑,金士顿领跑

大涨96.8%,前三季度全球存储市场规模突破1200亿美元,3Q24 NAND Flash/DRAM市场营收排名出炉

预计第四季度DRAM市场仅HBM价格上涨

国产MCU有推荐吗?最好是经过市场验证的!

直播预告 | 探索干簧传感威廉希尔官方网站 在汽车市场的应用潜力

DRAM与NAND市场迎高增长,2024年收入飙升

OpenAI 推出 GPT-4o mini 取代GPT 3.5 性能超越GPT 4 而且更快 API KEY更便宜

SK海力士加大1b DRAM产能以满足市场需求

三星/SK海力士DRAM大幅扩产,恢复至削减前水平,存储新周期开启

DRAM市场恢复元气,还想在GPT市场干票大的?

DRAM市场恢复元气,还想在GPT市场干票大的?

评论