01

—

方法介绍

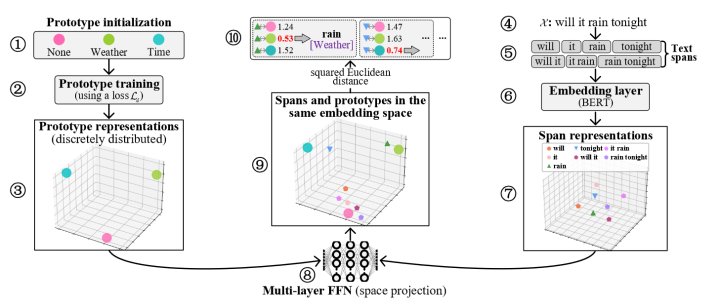

Few-shot NER的三阶段:Train、Adapt、Recognize,即在source域训练,在target域的support上微调,在target域的query上测试。

如上图,左边(1-3)表示的是原型的loss1(训练目标为各个原型分散分布),右边(4-7)表示的是span的representation获取,中间(8)是一个多层FFN(为了使得原型表示和span表示最终映射到同一个向量空间),中间(9-10)则是计算原型和span在同一个空间的loss2(为了使得实体span更靠近原型表示)

02

—

和过往工作相比

1、使得Adapt阶段不只是通过对support集中的实体词表示平均得到实体原型表示,而是能够进行finetune(文中提到Ma et al. (2022) claim that the finetuning method is far more effective in using the limited information in support sets.)

2、过往的原型网络的训练方法使得最终的原型表示较接近,本文通过构造loss1(上一段提到的)使得原型表示分散开

03

—

实验结果

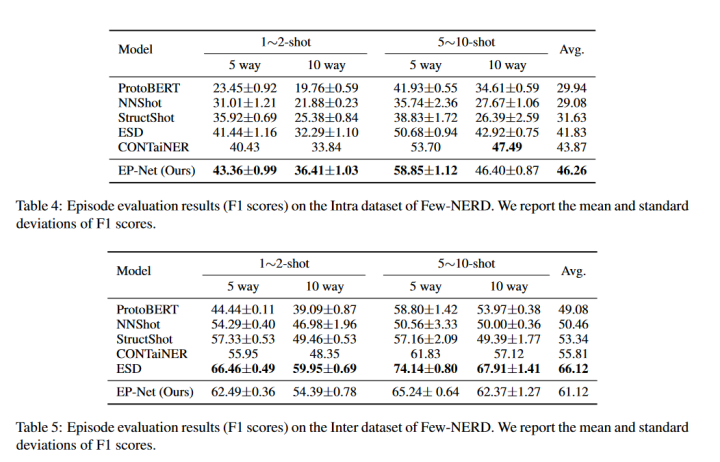

这里仅挑选附录部分的FEW-NERD实验结果

从实验结果来看,在INTRA上效果较好,在INTER上不如ESD。其中INTRA是指source和target之间的实体的粗粒度类型无交集,INTER则在粗粒度上有交集(细粒度上无交集)。(另外,2022年还有一篇SOTA文章Decomposed metalearning for few-shot named entity recognition,这里没有进行对比)

04

—

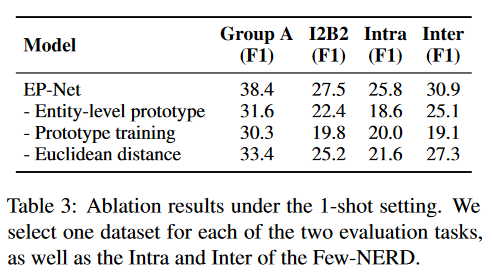

消融实验

1、使用token-level

2、缺少loss1(把原型打散的loss,方法介绍中有说)

3、使用cosine similarity而不是Euclidean distance来衡量span-prototype相似度

-

网络

+关注

关注

14文章

7557浏览量

88742 -

Target

+关注

关注

0文章

13浏览量

8465

原文标题:COLING2022 | 少样本NER:分散分布原型增强的实体级原型网络

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于将 CLIP 用于下游few-shot图像分类的方案

三阶段充电器的关键参数疑点

中国联通召开学习实践活动第三阶段工作会议

中芯国际将在2019年量产14纳米FinFET,并勾勒28纳米三阶段蓝图

5G第三阶段测试规划详解

五大设备商的5G三阶段测试进展对比

我国5G完成第三阶段测试 离5G商用又近了一步

华为完成中国5G威廉希尔官方网站 研发试验第三阶段测试 刷新业界纪录

京东方投34亿元建12英寸OLED微显示器件生产线,分三阶段

介绍两个few-shot NER中的challenge

UBBF 2023 | 迈向F5.5G,华为发布三阶段全光目标网架构

迈向F5.5G,华为发布三阶段全光目标网架构

基于显式证据推理的few-shot关系抽取CoT

Few-shot NER的三阶段

Few-shot NER的三阶段

评论