笔者最近在集中时间学习对抗生成网络(GAN),特别是深度生成先验进行多用途图像修复与处理,需要对图像修复与处理经典论文进行回顾和精读。

将从图像修复与处理的经典之作DGP《Exploiting Deep Generative Prior for Versatile Image Restoration and Manipulation》开始,重启精读之路。

DGP提出了一种挖掘GAN中图像先验的方式,在多个任务上揭示了GAN作为一种通用图像先验的潜力。

论文提出了同时插值隐变量和生成器的渐变式图像反演方法,可以应用于复杂图片的对抗防御,在实验中DGP所展现出的强大的像素间空间关系interwetten与威廉的赔率体系 能力也十分有趣。

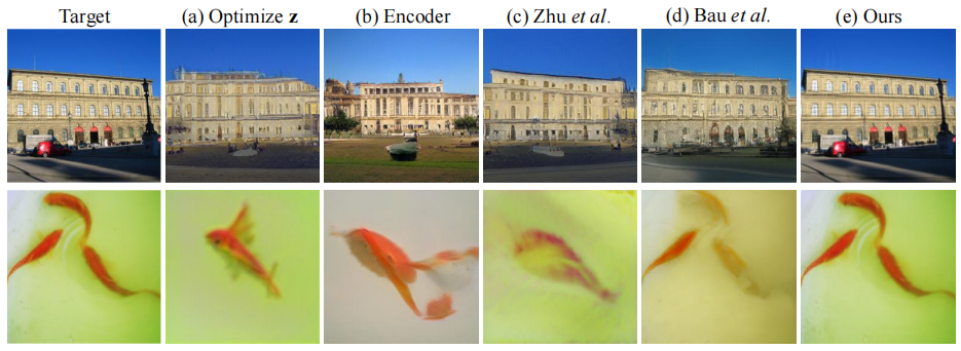

Deep generative prior的图像复原效果

01深度生成先验

深度图像先验DIP仅依靠输入图像的统计信息,无法应用于需要更一般的图像统计信息的任务,如图像上色和图像编辑。

我们更感兴趣的是研究一种更通用的图像先验,即在大规模自然图像上训练的GAN生成器用于图像合成。具体来说,是一个基于GAN-inversion的图像重构过程。

在实践中,仅仅通过优化隐向量z难以准确重建ImageNet这样的复杂真实图像。训练GAN的数据集(ImageNet)本身是自然图片中很少的一部分,GAN受限于有限的模型性能和mode collapse,其模拟的图片分布与训练集图片分布也存在鸿沟。

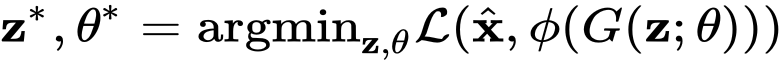

即使存在以上限制,GAN仍然学习了丰富的图片信息,为了利用这些信息并且实现精确重建,我们让生成器online地适应于每张目标图片,即联合优化隐向量z和生成器参数。

我们将此新的目标称为深度生成先验(DGP),DGP显著提高了图像重构的效果。设计合适的距离度量和优化策略非常关键,在重建过程中,生成器原始的生成先验被修改了,输出真实自然图像的能力可能会下降。

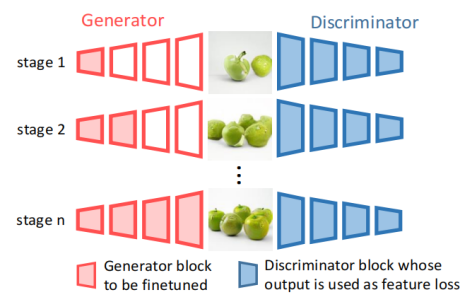

02判别器指引的渐进式重建

从 latent space Z 中随机抽取几百个候选的初始 latent code,并选择在度量L下重构效果最好的一个。

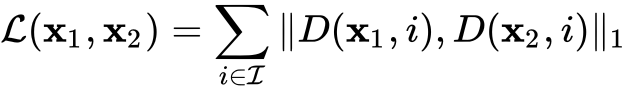

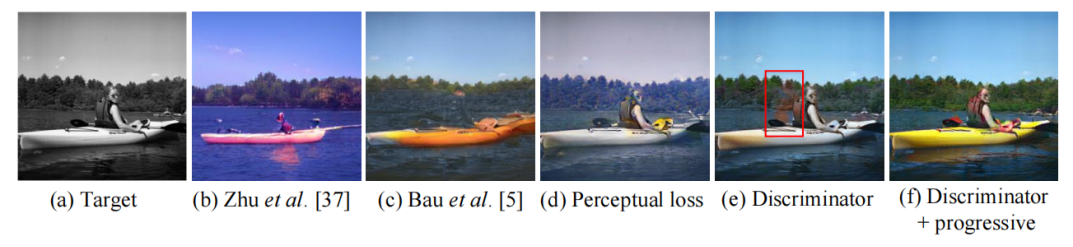

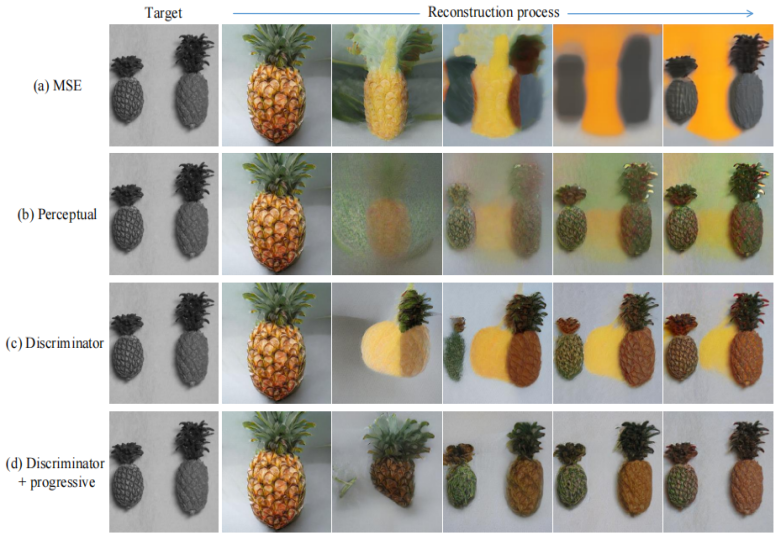

在GAN重建中,传统的距离度量方法是 MSE 或 Perceptual loss。优化生成器参数时,将这些传统距离度量用在图像恢复如上色任务中,常常无法准确恢复颜色,并且重建过程中图像会变得模糊,需要设计更好的优化方式来保留生成器的原有信息。

我们在该工作中选择使用与生成器对应的判别器来作为距离度量。与Perceptual loss所采用的VGGNet不同,判别器并非在一个第三方的任务上训练,而是在预训练时就与生成器高度耦合,它天然地适用于调整生成器的输出分布。

使用这种基于判别器的距离度量时,重建的过程更加自然和真实,最终颜色恢复的效果也更好。

其中D(x, i)代表以x作为输入时判别器第i个block输出的特征

虽然改进的距离度量带来了更好的效果,但是图像复原的结果仍存在非自然痕迹,因为生成器在针对目标图片优化时,浅层参数匹配好图片整体布局之前,深层参数就开始匹配细节纹理了。

上面的苹果图是几种训练策略的对比,从三行效果可以看出,有的苹果在训练初期没被染上色后期还是没被染上色,我们把这种现象称作“信息滞留”。

对策就是:使用渐进式重建的策略,即在微调生成器时,先优化浅层,再逐渐过渡到深层,让重建过程“先整体后局部”。

与非渐进策略相比,这种渐进策略更好地保留了缺失语义和现有语义之间的一致性。

03重建结果

使用BigGAN模型,基于ImageNet进行训练,使用ImageNet验证集中的1000张图像进行实验,取每类的第一张,相比于其他方法,DGP取得了非常高的PSNR和SSIM,视觉上的重建误差几乎难以察觉。

04实验

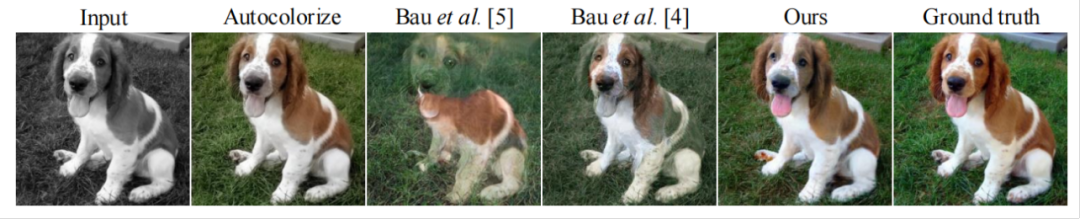

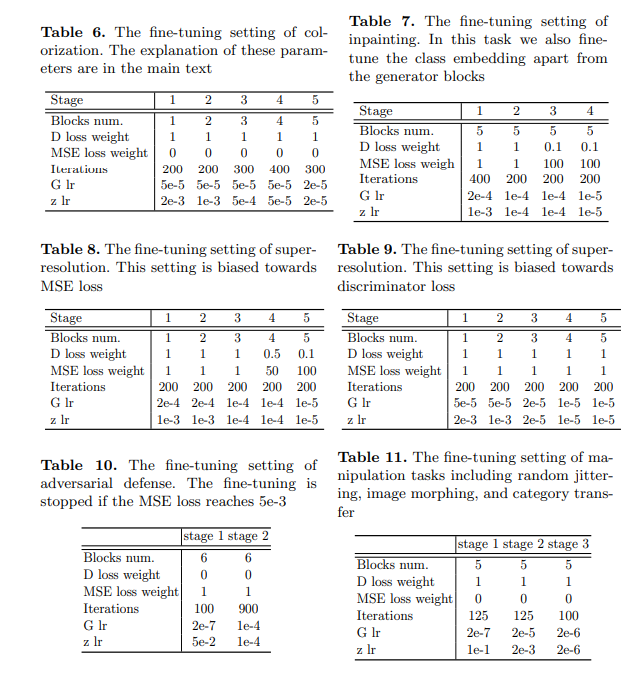

因为GAN刻画了自然图像的先验,因此可以完成很多的任务:比如上色、补全、超分辨率等等,还能进行图像处理。下面放一些效果图。

图像上色

使用ResNet50上的分类精度作为定量评估结果, 下列方法的精度分别为 51.5%, 56.2%, 56.0%, 62.8%。

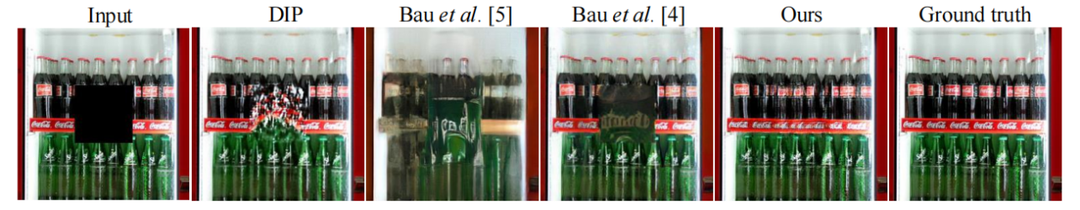

图像补全

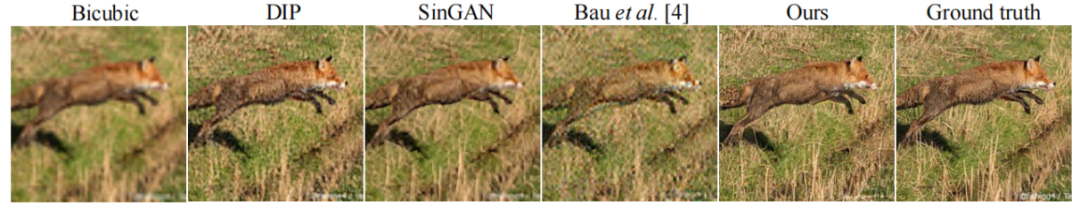

超分辨率

灵活性

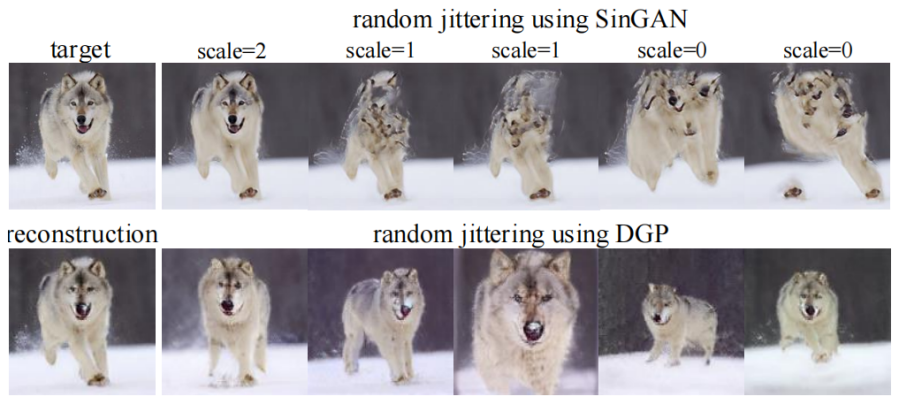

随机扰动

总结

GAN作为图像领域最强大的生成式模型之一,学习到了丰富的自然图像流形,可以对自然图像的恢复和编辑带来巨大帮助。

利用好大规模预训练模型的能力是深度学习目前各个领域的流行前沿,可以减少对训练数据的需求,整合相近的研究领域。

未来更强大的生成式模型,将带来更具实际应用价值的图像恢复和编辑应用,有望在更广泛的领域落地

审核编辑 :李倩

-

GaN

+关注

关注

19文章

1935浏览量

73414 -

生成器

+关注

关注

7文章

315浏览量

21010 -

图像修复

+关注

关注

0文章

11浏览量

2263

原文标题:深度学习论文精读[GAN]:利用深度生成先验进行多用途图像修复与处理

文章出处:【微信号:CVSCHOOL,微信公众号:OpenCV学堂】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

经典图神经网络(GNNs)的基准分析研究

FPGA在图像处理领域的优势有哪些?

图像处理器的发展历史

图像处理器是什么意思

图像识别威廉希尔官方网站 包括自然语言处理吗

图像处理中的卷积运算

经典卷积网络模型介绍

计算机视觉和图像处理的区别和联系

机器视觉图像采集卡:关键的图像处理设备

图像修复与处理经典论文回顾和精读

图像修复与处理经典论文回顾和精读

评论