在今年 3 月的 GTC 2022 大会上,阿里云带来了推理优化/部署、深度学习编译器、大模型部署、训练优化等主题的内容,分享云端机器学习平台 PAI (Machine Learning Platform for AI) 最新的创新实践,并已在【阿里灵杰】知乎号陆续发布三篇演讲内容深度回顾。同时阿里云也分享了其设计研发的高性能云手游解决方案——弹性云手机。

专家带你解读,免费学习不间断

阿里云的精彩分享均已在 NVIDIA On-Demand 上线。

云端 Triton 生产实践

NVIDIA Triton 推理服务器是一款功能全面、可扩展且功能强大的推理解决方案,在边缘设备和云上皆可部署。在云上将 Triton 部署到生产环境中时,应考虑效率、可扩展性以及与 Triton 自身外的云上基础设施的集成。本演讲将介绍阿里云中通过 PAI-EAS 提供 Triton 作为云服务的关键见解:

1) 一键部署 Triton 集群

2) 根据请求吞吐量扩展 Triton 集群

3) 与 OSS(对象存储服务)原生集成

4) Triton 和 GPU 共享调度。

通过 PAI-Blade 更易用、更可靠地使用 TensorRT

TensorRT 是由 NVIDIA 推出的业界领先的推理加速器,在深度学习推理场景应用广泛,但是通过 TensorRT 来优化深度学习模型仍有一定门槛。首先,通过 TensorRT 解析模型时会遇到转换失败或表现不理想的情况。其次,从零开始搭建网络比较耗时且难以扩展。此外,在生产环境里增加新的推理框架需要严谨的评估。本次演讲将介绍如何通过一站式 AI 加速器 PAI-Blade 解决上述问题。PAI-Blade 能够实现 TensorRT 后端上的自动圈图和自动化运行。同时还可以与 TensorRT Plugin 协同工作,以实现更好的性能。目前 PAI-Blade 提供对 TensorFlow 和 PyTorch 的产品化支持。

PaiSparse:面向深度学习的稀疏加速库

随着超大语言模型的流行, 如何部署超大模型正在成为迫切需要解决的问题。非结构化剪枝可以将模型规模缩小 99%,让超大语言模型在单卡上部署成为可能。然而超大模型稀疏后会呈现不同的非零分布,而这些分布会直接影响硬件的计算量并影响最终的执行时间。同时与传统的 HPC 任务不同的是,基于训练后的稀疏矩阵分布的 tuning 在深度学习推理中是可以进行的。因此我们提出一个面向深度学习的稀疏加速库:PaiSparse,可以自动生成更高效的稀疏算子。实验表明,与 cuSparse 相比, PaiSparse 可以提速 1.5~5 倍。

PTXC:使用 XLA 编译器通过云 GPU 扩展 PyTorch 训练

在工业界实践中,模型训练和部署的效率、规模和适配性关系到最终的应用效果。为满足 PyTorch eager-first 的 GPU 编译流程, Lazy Tensor 架构被提出来。通过采用实践验证过的产品化 XLA 编译器和分布式引擎, PTXC 能在阿里云 GPU 集群中以基于编译优化的方式一键快速搭建易用、弹性且高效的 PyTorch 模型训练系统。

阿里云基于 AI 编译器的通用透明性能解决方案

本次演讲将从云服务厂商的视角,分享在云端和机器学习平台上大规模部署 AI 编译器的实战经验。我们将详细介绍近期刚刚开源的动态 shape 深度学习编译器 BladeDISC,包括它的背景和主要特性,具体设计架构和实现细节,动态 shape 语义下的性能优化经验,未来计划以及在 NVIDIA 设备上的应用等。

未来游戏趋势:通过阿里云弹性云手机解决方案打造云游戏

基于 NVIDIA GPU 及原生的 ARM 平台,阿里云设计研发了高性能的云手游解决方案——弹性云手机,可实现虚拟化渲染及显存隔离,在确保隔离的情况下充分发挥 GPU 性能。此外,弹性云手机无缝对接阿里巴巴云游戏流媒体平台,该平台兼容多种流媒体协议,并具备完整的“渲染-编码-串流”云手游架构。

原文标题:NVIDIA On-Demand 观看阿里云机器学习平台 PAI 的精彩演讲

文章出处:【微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

审核编辑:汤梓红

-

NVIDIA

+关注

关注

14文章

4986浏览量

103068 -

机器学习

+关注

关注

66文章

8418浏览量

132646 -

阿里云

+关注

关注

3文章

956浏览量

43045

原文标题:NVIDIA On-Demand 观看阿里云机器学习平台 PAI 的精彩演讲

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

如何选择云原生机器学习平台

阿里云PAI获首个国际标准认证,领跑AI云平台

什么是机器学习?通过机器学习方法能解决哪些问题?

使用机器学习和NVIDIA Jetson边缘AI和机器人平台打造机器人导盲犬

AI干货补给站 | 深度学习与机器视觉的融合探索

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

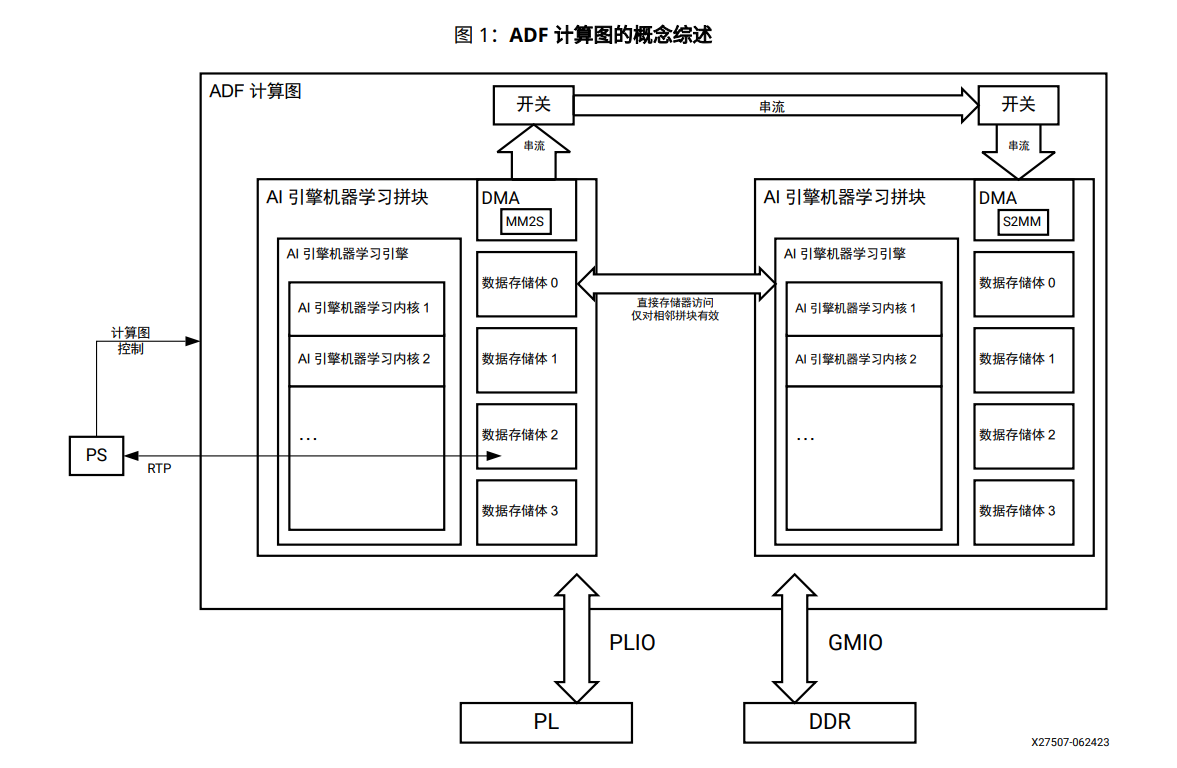

AI引擎机器学习阵列指南

云端机器学习平台PAI最新的创新实践

云端机器学习平台PAI最新的创新实践

评论