EC改进方案选型

接上篇,介绍一下整个容灾方案在性能和可靠性方面如何做验证。

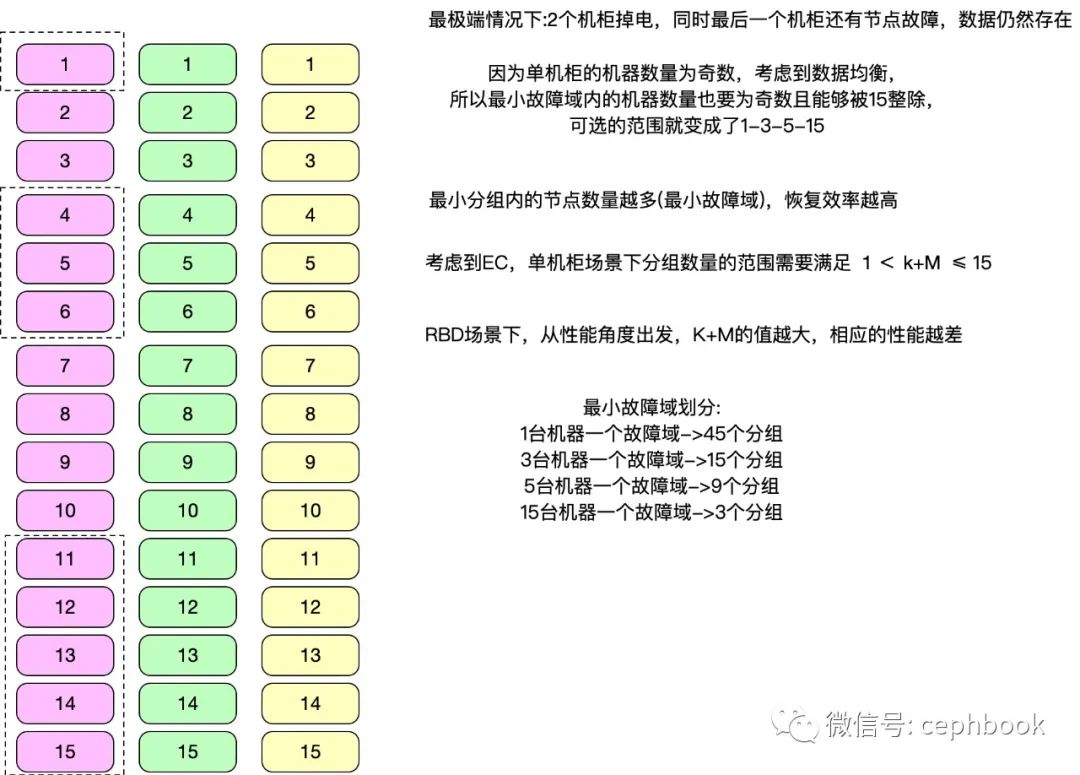

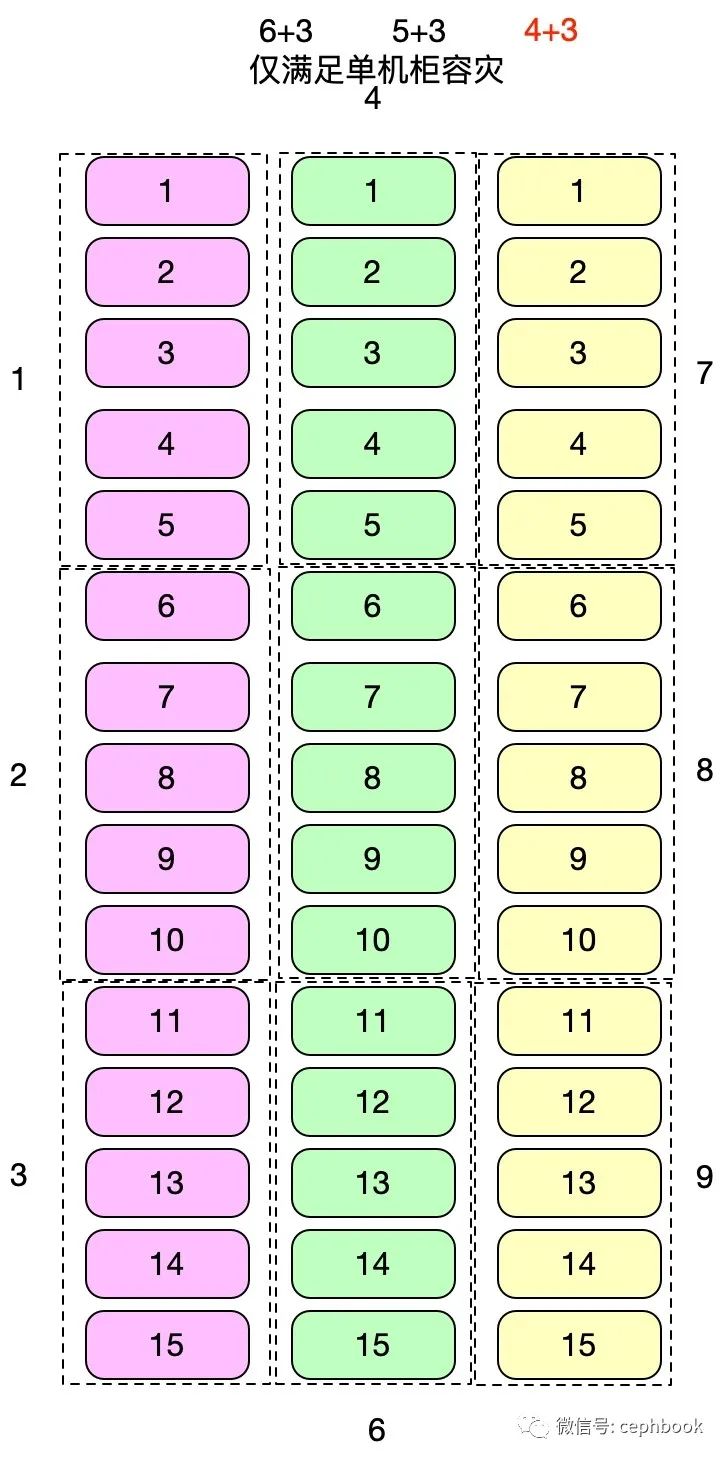

3个机柜,每个机柜15台机器,总共45台,需要在RBD场景下,找到成本、性能、数据可靠性的三者平衡点。

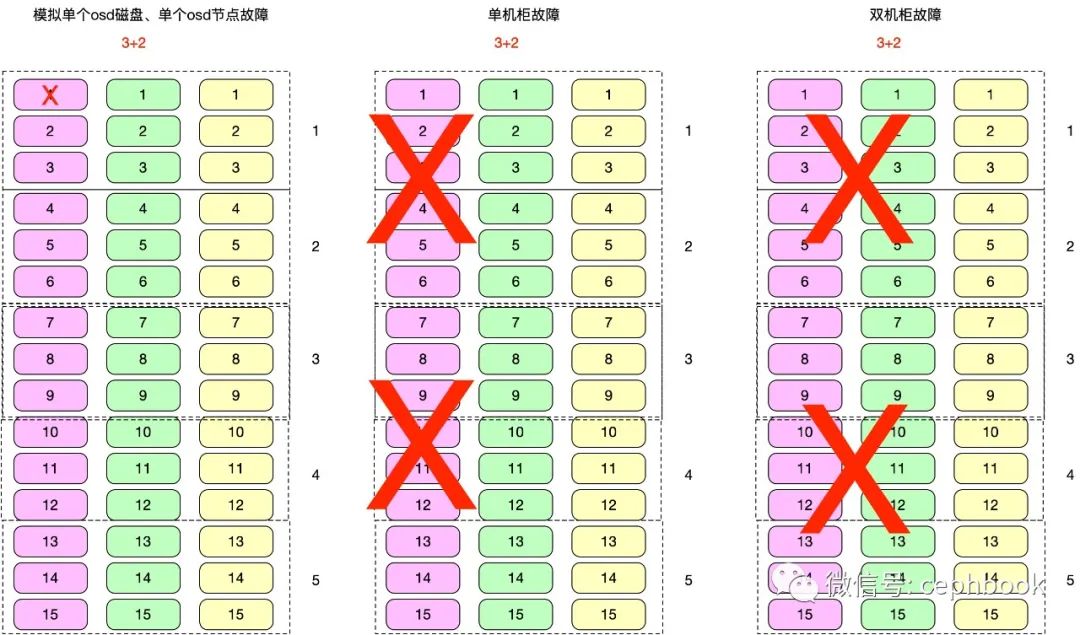

跨机柜容灾方案1

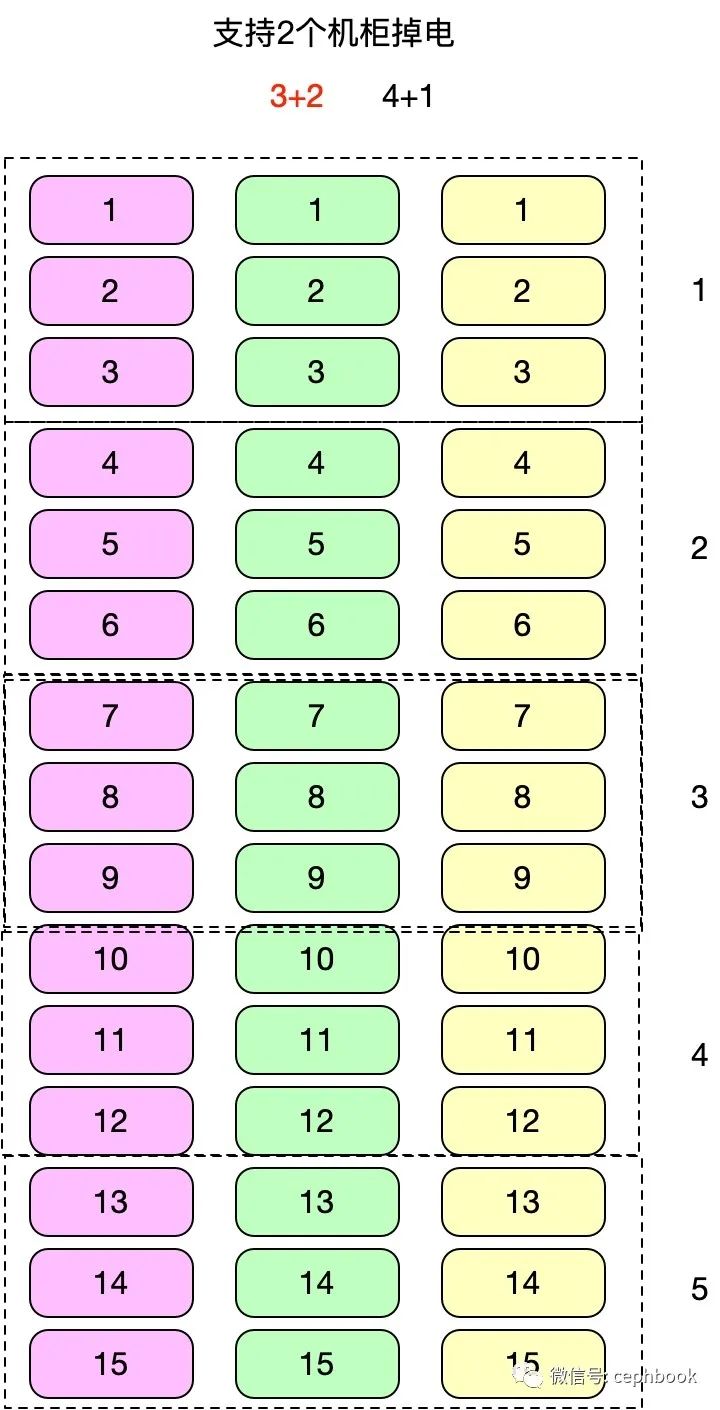

支持2个机柜级别的容灾,跨3个机柜单个分组共9个节点,共5个分组,对应的理论收益情况如下

| 名称 | K | M | D | 3副本得盘率 | EC得盘率 | 硬件成本节约比率 | 磁盘数据迁移量(ISA) | 磁盘数据迁移量(CLAY) | 数据恢复负载降低比率 |

|---|---|---|---|---|---|---|---|---|---|

| 3+2 | 3 | 2 | 4 | 33.33333333 | 60 | 180 | 3 | 2 | 33.33333333 |

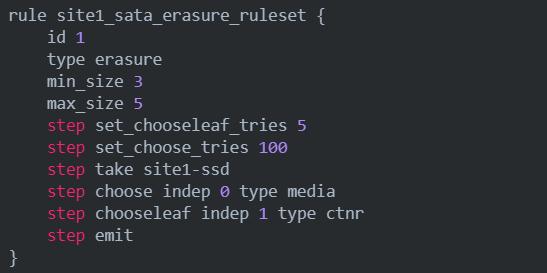

对应的crush rule如下

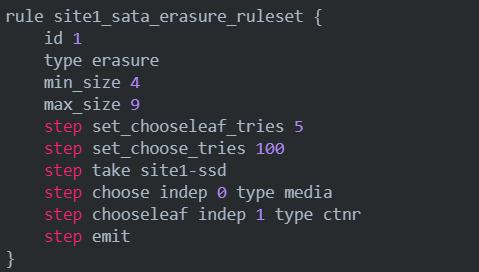

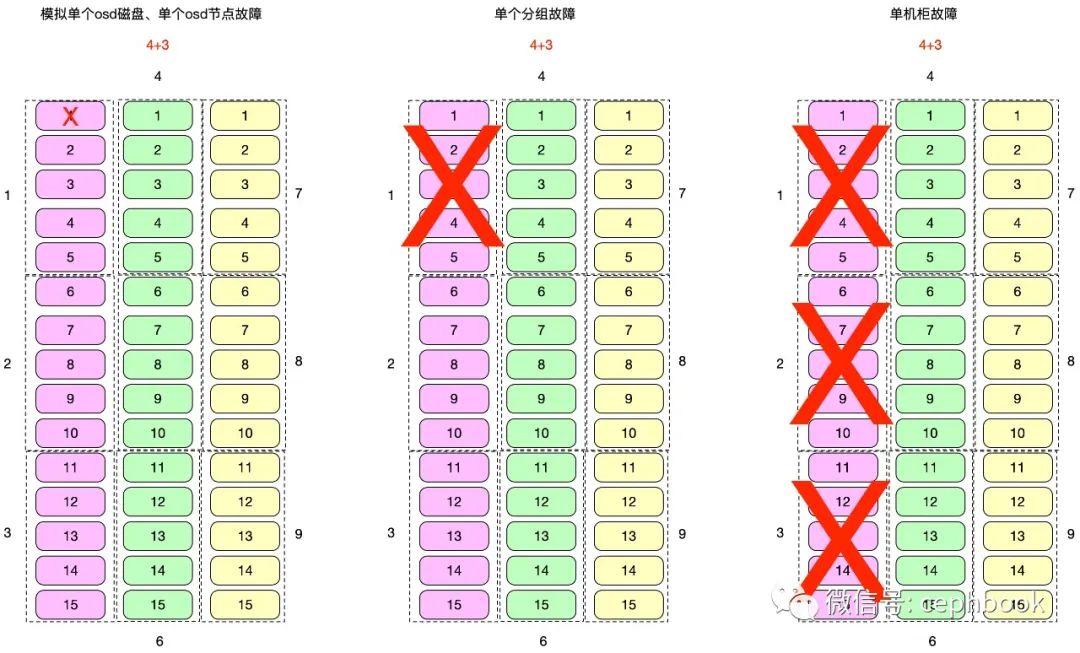

单机柜容灾方案2

支持1个机柜级别的容灾,单个分组共5个节点,共9个分组,对应的理论收益情况如下

| 名称 | K | M | D | 3副本得盘率 | EC得盘率 | 硬件成本节约比率 | 磁盘数据迁移量(ISA) | 磁盘数据迁移量(CLAY) | 数据恢复负载降低比率 |

|---|---|---|---|---|---|---|---|---|---|

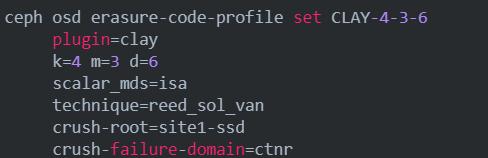

| 4+3 | 4 | 3 | 6 | 33.33333333 | 57.14285714 | 171.4285714 | 4 | 2 | 50 |

| 5+3 | 5 | 3 | 7 | 33.33333333 | 62.5 | 187.5 | 5 | 2.333333333 | 53.33333333 |

| 6+3 | 6 | 3 | 8 | 33.33333333 | 66.66666667 | 200 | 6 | 2.666666667 | 55.55555556 |

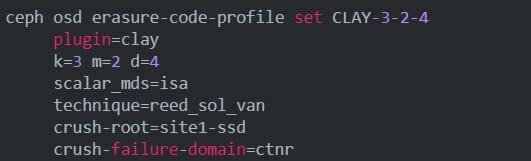

从性能最优原则,K+M总和最小则对应的理论性能最优,所以单机柜容灾模型下,4+3成为最优方案。

对应的ec配置如下

对应的crush rule如下

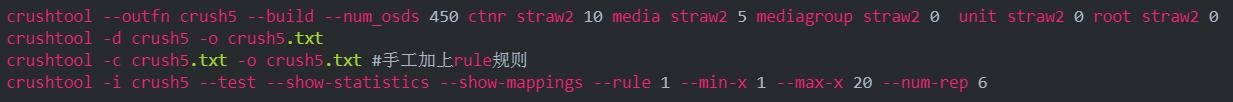

crush rule的生成与rule的验证interwetten与威廉的赔率体系

容灾能力测试场景

性能测试

RBD场景,模拟大、小文件,顺序/随机读写,获取对应的fio性能基准数据,对比3副本与EC的性能差距。

3副本 vs CLAY_3+2 vs CLAY_4+3

| 场景名称 | iops | 带宽 | 90th延时 | 99th延时 | 备注 |

|---|---|---|---|---|---|

| 3副本-4M顺序读 | |||||

| 3+2-4M顺序读 | |||||

| 4+3-4M顺序读 | |||||

| 3副本-4M顺序写 | |||||

| 3+2-4M顺序写 | |||||

| 4+3-4M顺序写 | |||||

| 3副本-4k随机写 | |||||

| 3+2-4k随机写 | |||||

| 4+3-4k随机写 | |||||

| 3副本-4k随机读 | |||||

| 3+2-4k随机读 | |||||

| 4+3-4k随机读 |

故障恢复效率

前置条件:集群提前写入容量60%,模拟已有数据场景

目标:对比ISA和CLAY在K+M相同的情况下,RBD场景下持续读写数据,模拟单块OSD、单个OSD节点故障、多个OSD节点故障(可选),数据迁移所需的时长,同时记录对应的CPU、内存、网卡负载消耗情况,以及性能波动情况。

容灾能力

前置条件:集群提前写入容量60%,模拟已有数据场景

目标:RBD场景下持续读写数据,模拟最小故障域、单机柜、双机柜故障,记录对应的性能波动情况,考察在极端情况下整个集群的服务可用性和数据可靠性。

跨机柜容灾方案1

单机柜容灾方案2

责任编辑:xj

原文标题:Ceph最新的EC-CLAY插件调研-下

文章出处:【微信公众号:Ceph对象存储方案】欢迎添加关注!文章转载请注明出处。

-

机柜

+关注

关注

0文章

45浏览量

10340 -

容灾实现

+关注

关注

0文章

2浏览量

6730 -

Ceph

+关注

关注

1文章

22浏览量

9402

原文标题:Ceph最新的EC-CLAY插件调研-下

文章出处:【微信号:cephbook,微信公众号:Ceph对象存储方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

不同制造商TOPCon光伏组件的老化测试:性能、稳定性与可靠性

GaN可靠性测试新突破:广电计量推出高压性能评估方案

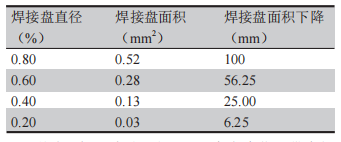

PCB高可靠性化要求与发展——PCB高可靠性的影响因素(上)

基于可靠性设计感知的EDA解决方案

汽车功能安全与可靠性的关系

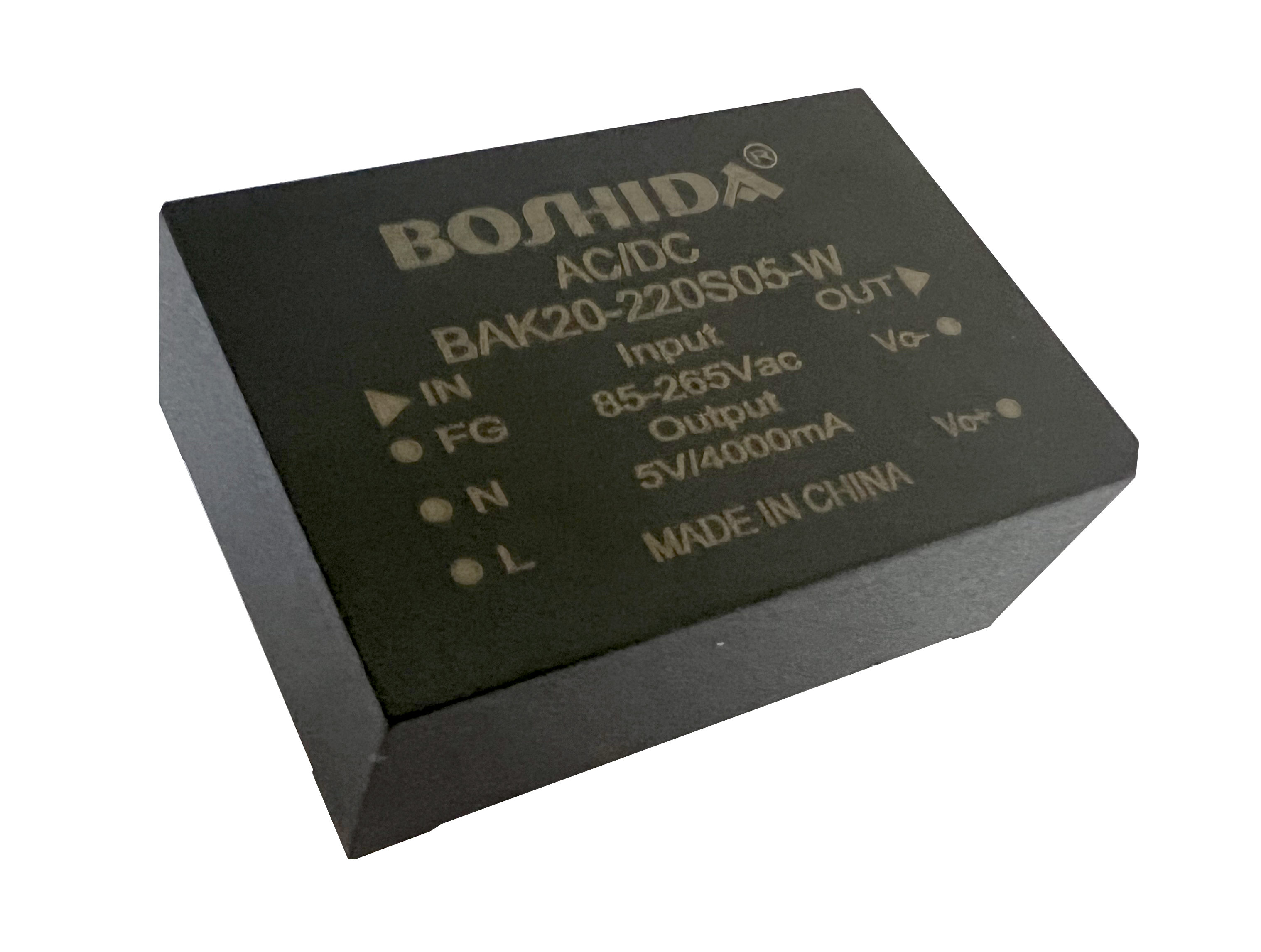

DCAC电源模块:效率与可靠性兼备的能源转换解决方案

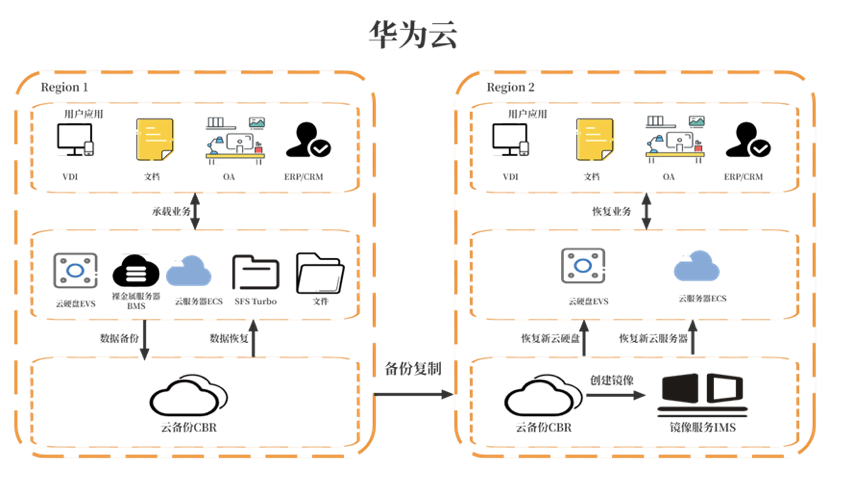

华为云 618 营销季来袭,数据灾备方案为云端业务筑牢安全防线

半导体封装威廉希尔官方网站 的可靠性挑战与解决方案

谷景成功为客户汽车双滑轨项目提供电感替代方案

数仓中搭建细粒度容灾应用的主要步骤

线路板变形对电路性能和可靠性有影响吗?

美国站群服务器优化:提升性能与可靠性的关键功能

安森美IGBT常规进行的可靠性测试方案

IGBT的可靠性测试方案

EC改进方案选型:容灾方案在性能和可靠性方面如何做验证

EC改进方案选型:容灾方案在性能和可靠性方面如何做验证

评论