昨晚AMD刚刚发布了7nm CDNA架构的MI100加速卡,NVIDIA这边就推出了A100 80GB加速卡。虽然AMD把性能夺回去了,但是A100 80GB的HBM2e显存也是史无前例了。

NVIDIA今年3月份发布了安培架构的A100加速卡(名字中没有Tesla了),升级了7nm工艺和Ampere安培架构,集成542亿晶体管,826mm2核心面积,使用了40GB HBM2显存,带宽1.6TB/s。

图片来自Anandtech网站

现在的A100 80GB加速卡在GPU芯片上没变化,依然是A100核心,6912个CUDA核心,加速频率1.41GHz,FP32性能19.5TFLOPS,FP64性能9.7TFLOPS,INT8性能624TOPS,TDP 400W。

变化的主要是显存,之前是40GB,HBM2规格的,带宽1.6TB/s,现在升级到了80GB,显存类型也变成了更先进的HBM2e,频率从2.4Gbps提升到3.2Gbps,使得带宽从1.6TB/s提升到2TB/s。

对游戏卡来说,这样的显存容量肯定是浪费了,但是在高性能计算、AI等领域,显存很容易成为瓶颈,所以翻倍到80GB之后,A100 80GB显卡可以提供更高的性能,NVIDIA官方信息称它的性能少则提升25%,多则提升200%,特别是在AI训练中,同时能效也提升了25%。

在A100 80GB加速卡发布之后,现在的A100 40GB版依然会继续销售。

责任编辑:PSY

-

amd

+关注

关注

25文章

5466浏览量

134110 -

NVIDIA

+关注

关注

14文章

4981浏览量

102999 -

显存

+关注

关注

0文章

108浏览量

13658 -

加速卡

+关注

关注

1文章

60浏览量

10943

发布评论请先 登录

相关推荐

美光发布HBM4与HBM4E项目新进展

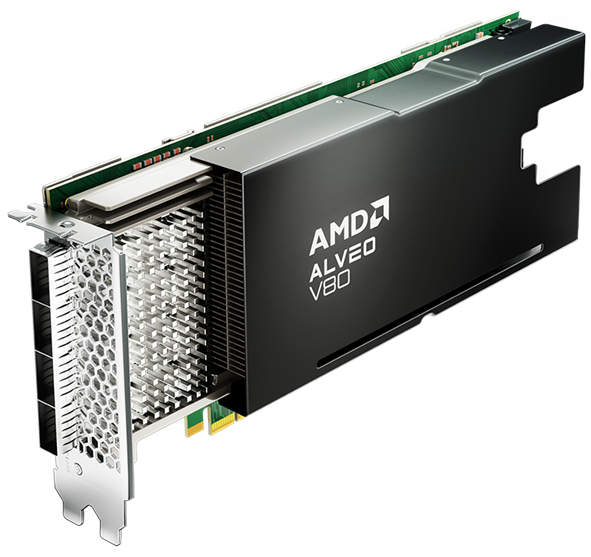

贸泽开售适用于高性能计算应用的AMD Alveo V80加速器卡

HBM上车?HBM2E被用于自动驾驶汽车

SK海力士携手Waymo提供第三代高带宽存储器(HBM2E)威廉希尔官方网站

英伟达2025年计划发布Blackwell Ultra与B200A,或大幅提升HBM消耗量

集成32GB HBM2e内存,AMD Alveo V80加速卡助力传感器处理、存储压缩等

SK海力士:HBM3E量产时间缩短50%,达到大约80%范围的目标良率

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

三星重磅发布全新12层36GB HBM3e DRAM

最强A卡刚发布 NV就出大招:80GB HBM2e、性能提升200%

最强A卡刚发布 NV就出大招:80GB HBM2e、性能提升200%

评论