经历了几年的高速发展之后,人工智能(简称 AI)不再是新鲜的名词,它已经作为一个重要的生产工具,被引入到我们工作和生活的多个领域。但在 AI 爆发的背后,随之而来的是对 AI 算力需求的暴增。

据 OpenAI 的一份报告显示,从 2012 年到 2019 年,人工智能训练集增长了 30 万倍,每 3.43 个月翻一番,但如果是以摩尔定律的速度,只会有 12 倍的增长。为了满足 AI 算力的需求,从业人员通过设计专用的 AI 芯片、重配置硬件和算法创新等多方面入手来达成目标。

AI 算力需求增长

然而在此过程中,我们除了看到 AI 对算力的要求以外,内存带宽也是限制 AI 芯片发展的另一个关键要素。这就需要从传统的冯诺依曼架构谈起。作为当前芯片的主流架构,冯诺依曼架构的一大特征就是计算和内存分离的。那就意味着每进行一次计算,计算单元都要从内存中读取数据然后计算,再把计算结构存回到内存当中。

经典的冯诺依曼架构

在过往,这个架构的短板并不是很明显,因为处理器和内存的速度都都非常接近。但众所周知的是,在摩尔定律指导下的处理器在过去几十年里发生了翻天覆地的变化,但常用的 DRAM 方案与之相比,提升幅度不值一提。

再者,在 AI 时代,数据传输量越来越大。先进的驾驶员辅助系统(ADAS)为例。第 3 级及更高级别系统的复杂数据处理需要超过 200 GB/s 的内存带宽。这些高带宽是复杂的 AI/ML 算法的基本需求,在道路上自驾过程中这些算法需要快速执行大量计算并安全地执行实时决策。在第 5 级,即完全自主驾驶,车辆能够独立地对交通标志和信号的动态环境作出反应,以及准确地预测汽车、卡车、自行车和行人的移动,将需要巨大的内存带宽。

因此,AI 芯片寻找新的内存方案迫在眉睫,其中 HBM 和 GDDR SDRAM(简称 GDDR)就成为了行业的选择。

为什么是 HBM 和 GDDR ?

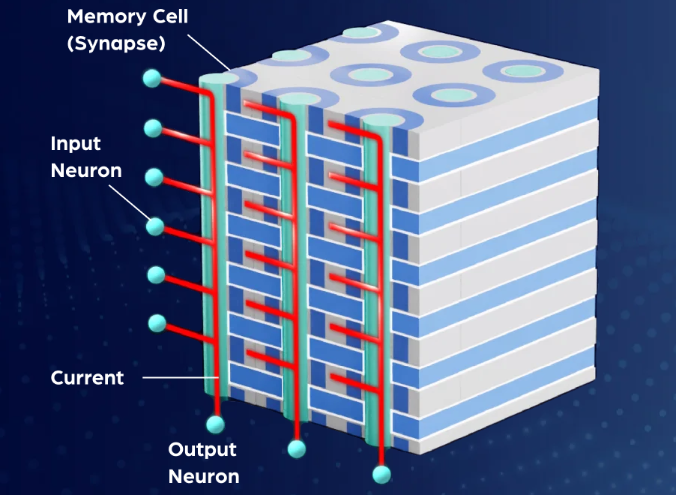

HBM 就是 High Bandwidth Memory 的缩写,也就是高带宽内存,这是一项在 2013 年 10 月被 JEDEC 采纳为业界标准的内存威廉希尔官方网站 。按照 AMD 的介绍,这种新型的 CPU/GPU 内存芯片(即 “RAM”),就像摩天大厦中的楼层一样可以垂直堆叠。基于这种设计,信息交换的时间将会缩短。这些堆叠的芯片通过称为“中介层 (Interposer)”的超快速互联方式连接至 CPU 或 GPU。将 HBM 的堆栈插入到中介层中,放置于 CPU 或 GPU 旁边,然后将组装后的模块连接至电路板。

尽管这些 HBM 堆栈没有以物理方式与 CPU 或 GPU 集成,但通过中介层紧凑而快速地连接后,HBM 具备的特性几乎和芯片集成的 RAM 一样。更重要的是,这些独特的设计能给

开发者带来功耗、性能和尺寸等多个方面的优势。

从第一代 HBM 与 2013 年面世后,JEDEC 又分别在 2016 年和 2018 把 HBM2 和 HBM2E 纳为行业标准。据了解,在 HBM2E 规范下,当传输速率上升到每管脚 3.6Gbps 时,HBM2E 可以实现每堆栈 461GB/s 的内存带宽。此外,HBM2E 支持 12 个 DRAM 的堆栈,内存容量高达每堆栈 24 GB。

具体而言,就是说每一个运行速度高达 3.6Gbps 的 HBM2E 堆栈通过 1024 个数据“线”的接口连接到它的相关处理器。通过命令和地址,线的数量增加到大约 1700 条。这远远超出了标准 PCB 所能支持的范围。因此,硅中介层被采用作为连接内存堆栈和处理器的中介。与 SoC 一样,精细数据走线可以在硅中介层中以蚀刻间隔的方式实现,以获得 HBM 接口所需数量的数据线数。

得益于其巨大内存带宽的能力,使得连接到一个处理器的四块 HBM2E 内存堆栈将提供超过 1.8 TB/s 的带宽。通过 3D 堆叠内存,可以以极小的空间实现高带宽和高容量需求。进一步,通过保持相对较低的数据传输速率,并使内存靠近处理器,总体系统功率得以维持在较低水位。

根据 Rambus 的介绍,HBM2E 的性能非常出色,所增加的采用和制造成本可以透过节省的电路板空间和电力相互的缓解 。在物理空间日益受限的数据中心环境中,HBM2E 紧凑的体系结构提供了切实的好处。它的低功率意味着它的热负荷较低,在这种环境中,冷却成本通常是几个最大的运营成本之一。

正因为如此,HBM2E 成为了 AI 芯片的一个优先选择,这也是英伟达在 Tesla A100 和谷歌在二代 TPU 上选择这个内存方案的原因。但如前面所说,因为 HBM 独特的设计,其复杂性、成本都高于其他方案,这时候,GDDR 就发挥了重大的作用。

据了解,图形 DDR SDRAM(GDDR SDRAM)最初是 20 多年前为游戏和显卡市场设计的。在这段时间内,GDDR 经历了几次重大变革,最新一代 GDDR6 的数据传输速率为 16Gbps。GDDR6 提供了令人印象深刻的带宽、容量、延迟和功率。它将工作电压从 1.5V 降低到 1.35V 以获得更高的功率效率,并使 GDDR5 内存的数据传输速率(16 比 8 Gbps)和容量(16 比 8 GB)翻了一番。Rambus 已经演示了一个运行速度为 18 Gbps 的 GDDR6 接口,显示这种内存架构还有额外的增长空间。

与 HBM2E 不同,GDDR6 DRAM 采用与生产标准 DDR 式 DRAM 的大批量制造和组装一样的威廉希尔官方网站 。更具体地说,GDDR6 采用传统的方法,通过标准 PCB 将封装和测试的 DRAMs 与 SoC 连接在一起。利用现有的基础架构和流程为系统设计者提供了熟悉度,从而降低了成本和实现的复杂性。

与 HBM2E 宽而慢的内存接口不同,GDDR6 接口窄而快。两个 16 位宽通道(32 条数据线)将 GDDR6 PHY 连接到相关的 SDRAM。GDDR6 接口以每针 16 Gbps 的速度运行,可以提供 64 GB/s 的带宽。回到我们之前的 L3 汽车示例,GDDR6 内存系统以连接四个 DRAM 设备为例,带宽可以达到 200 GB/s。

采用 GDDR6 的主要设计挑战也来自于它最强大的特性之一:速度。在较低的电压条件,16 Gbps 的信号速度下,保持信号完整性需要大量的专业经验知识。设计人员面临更紧的时序和电压裕度量损失,这些损失来源与影响都在迅速增加。系统的接口行为、封装和电路板需要相互影响,需要采用协同设计方法来保证系统的信号完整性。

总的来说,GDDR6 内存的优异性能特性建立久经考验的基础制造过程之上,是人工智能推理的理想内存解决方案。其出色的性价比使其适合在广泛的边缘网络和物联网终端设备上大量采用。

Rambus 将扮演重要角色

从上文的介绍中,我们看到了 HBM2E 和 GDDR 6 在 AI 中的重要作用,而要真正将其落实到 AI 芯片中,相应的 IP 供应商将是很关键的一环,而 Rambus 将扮演这个重要角色。

据 Rambus 大中华区总经理 Raymond Su 介绍,Rambus 成立于上个世纪 90 年代,是一家领先的 Silicon IP 和芯片提供商,公司主要致力于让数据传输得更快、更安全。而从产品上看,Rambus 的产品主要聚焦于三大块:分别是基础架构许可、Silicon IP 授权,还有 buffer chip 芯片业务。

“得益于这些深厚的积累,我们能提供友商所不具备的差异性服务”,Raymond Su 补充说。他指出:

首先,在内存 IP 层面,Rambus 提供一站式的采购和“turn key”服务。而公司在去年完成的对全球知名的 IP 控制器公司 Northwest Logic 和对 Verimatrix 安全 IP 业务部,可以让 Rambus 能够提供更好的一站式的服务。

“通过这样的服务,Rambus IP 可以很好地帮助客户尽早地把产品推向市场”,Raymond Su 表示。

其次,作为全球领先的 HBM IP 供应商,Rambus 在全球已经有 50 多个成功项目案例,积累了大量的经验;而在 DDR5 Buffer Chip(缓冲芯片)方面,Rambus 也是全球首发。这让他们在 DDR5 时代有信心改变整个市场。而在 AI 芯片迫切需要的 HBM2E 和 GDDR 6 IP 方面,Rambus 也都做好了准备。

从 Rambus IP 核产品营销高级总监 Frank Ferro 的介绍我们得知,他们将 HBM2E 的性能提升到了 4Gbps。在他看来,这个速度是一个全新的行业标杆,而此次 Rambus 发布我们全新的 HBM2E 产品也正是实现了这一行业最高标准。

根据 Rambus 发布的白皮书介绍,他们 HBM2E 接口完全符合 JEDEC JESD235B 标准。支持每个数据引脚高达 3.6 Gbps 的数据传输速率。该接口具有 8 个独立的通道,每个通道包含 128 位,总数据宽度为 1024 位。由此每个堆栈支持的带宽是 461GB/s,每个堆栈由 2、4、8 或 12 个 DRAMs 组成。

作为一个为 2.5D 系统设计的 IP,它有一个用于在 3D-DRAM 堆栈和 SoC 上的 PHY 之间的中介层由提供信号绕线。这种信号密度和堆积尺寸的组合需要特殊的设计考虑。为了便于实施和提高了设计的灵活性,Rambus 对整个 2.5D 系统进行完整的信号和功率完整性分析,以确保所有信号、功率和散热要求都得到满足。而在于其他竞争对手相比,Rambus 的 HBM IP 则有着大多数厂商布局的几点核心优势:

第一,Rambus 提供的是完全集成而且经过验证的 PHY 以及内存控制器 IP 解决方案,在物理层面实现完整的集成互联。除了完整的内存子系统之外,他们的 PHY 也经过了硬核化处理,同时也完成了 timing closed 也就是时序收敛的工作。

“我们给客户提供的并不仅仅是自己的 IP 授权、IP 产品,我们也会向客户提供系统级的全面的集成支持,以及相关的工具套件,以及我们的威廉希尔官方网站 服务。同时,我们也可以帮助客户更加进一步地减少设计实现的难度。” Frank Ferro 补充说。他进一步指出,在发布了这个 IP 之后,Rambus 将会为人工智能以及机器学习的应用客户提供更加完整的解决方案,帮助他们进一步地提高带宽,满足他们在带宽上的需求。

第二,Rambus 拥有非常强大的 HBM 生产经验,在这方面,公司已经拥有了全球超过 50 家成功的客户案例,这在全球是名列前茅的。更重要的一点,Rambus 所有合作客户的芯片从设计到原型再到投产,并不需要任何的设计返工,基本上所有的芯片都会实现一次的成功。这足以体现他们的实力。

第三,Rambus 为客户提供非常完整的参考设计框架,其中最重要的一点就是如何更好地对中介层进行完整的设计和表征化的处理。“因为对于中介层来,讲它是 PHY 层和 DRAM 层之间沟通的重要环节,在这个过程中,因为速度非常快,所以说如何保证信号完整性也是必须要去考虑的。” Frank Ferro 表示。

他进一步指出,Rambus 与客户非常紧密地进行合作,并为他们提供非常完整的参考设计框架,然后帮助他们更好地去设计自己的中介层以及产品的封装。除此之外,Rambus 也帮助客户做仿真分析,让他们对自己每个信号的通道进行完整的分析,来实现整个产品的最高性能。

第四,这也是非常重要的一点,那就是 Rambus 有一套非常重要的工具——Lab Station。借助这个工具,Rambus 会与客户进行合作,让他们将其 HBM2E 解决方案直接插入到他们的终端系统当中,来构建一个非常独立的内存子系统。

能在 HBM2E IP 获得这样的成就,一方面,Rambus 的研发投入功不可没;另一方面,他们与 SK 海力士、AIChip 和台积电多方人员的通力合作,也是他们能提供快速服务的原因之一。例如在 SK 海力士方面,它为 Rambus 提供的 HBM2E 内存达到了 3.6G 的数据传输速率,而在和合作过程中,两者又将 HBM2E 的速率进一步地推进到了 4.0 Gbps;AIchip 则为 Rambus 提供了 ASIC 的相关解决方案以及产品,帮助其设计了相关中介层以及封装;此外,台积电提供了一个交钥匙的 2.5D Cowos 封装以及解决方案,来更好地为 Rambus 打造一个晶圆上的基本架构。

“我们的解决方案适用于人工智能以及机器学习的训练,同时也非常适用于高性能计算系统和 5G 网络的基础设施建设”,Frank Ferro 最后说。

除了面向 AI 训练的 HMB2E IP,Rambus 还推出了面向 AI 推理的 GDDR 6 产品。

据 Rambus 的白皮书介绍,公司的 GDDR6 接口专为性能和功率效率而设计,支持 AI/ML 和 ADAS 推理高带宽与低延迟要求。它由一个经共同验证的 PHY 和数字控制器组成,提供一个完整的 GDDR6 内存子系统。Rambus GDDR6 接口完全符合 JEDEC GDDR6 JESD250 标准,每个引脚支持高达 16 Gbps。GDDR6 接口支持 2 个通道,每个通道有 16 位,

总数据宽度为 32 位。Rambus GDDR6 接口每针 16 Gbps,提供带宽为 64 GB/s。

通过直接与客户合作,Rambus 能提供完整的系统信号和电源完整性(SI/PI)分析,创建优化的芯片布线版图。客户收到一个硬核解决方案与全套测试软件可以快速启动,定性和调试。

在“内存墙”的限制下,为了满足 AI 应用的数据搬运需求,产业界正在探索不同的方法来解决问题。例如英国 AI 芯片初创企业 Graphcore 就希望通过分布式内存设计的方法解决这个问题。

而 Rambus 的这两个方案出现那就给开发者们提供了在传统架构设计上获得性能大提升的可能。

审核编辑 黄昊宇

-

芯片

+关注

关注

456文章

50919浏览量

424582 -

内存

+关注

关注

8文章

3034浏览量

74130 -

AI

+关注

关注

87文章

31054浏览量

269407

发布评论请先 登录

相关推荐

英伟达加速认证三星AI内存芯片

北桥芯片负责与cpu的联系并控制内存吗

我们需要怎样的大模型?

ai开发需要什么配置

risc-v多核芯片在AI方面的应用

大算力时代, 如何打破内存墙

站群服务器需要多大内存

AI芯片需要怎样的内存

AI芯片需要怎样的内存

评论