9月8日,英国《卫报》刊登了一篇独特的专栏文章,它的作者既不是热心读者,也不是记者,而是GPT-3,由旧金山一家人工智能创业企业OpenAI开发的AI语言模型。在文章一开头,它首先引用了史蒂芬·霍金对AI的隐忧,然后礼貌地劝说人类“请相信我,AI不会毁灭人类”,它甚至保证“如果创造我的人将这项任务委托给我,我将竭尽所能全面阻止任何破坏的尝试与企图”。

霍金的担心也许并非空穴来风。2018年,IBM Research最新推出的AI系统Project Debater在一场辩论赛中击败了人类顶尖辩手,以色列国际辩论协会主席丹·扎夫里(Dan Zafrir)和2016年以色列国家辩论冠军诺亚·奥瓦迪亚(Noa Ovadia),两个辩题分别为“政府是否应该资助太空探索”以及“是否应该增强对远程医疗威廉希尔官方网站 的投资”。

当Project Debater获得一个新的话题时,它会在文章语料库中搜索与该主题相关的句子和线索,用来支持其辩方论点。根据所有的相关内容,它会试图去“理解”辩论的主题,然后组织自己的陈述。当奥瓦迪亚提出,政府预算应用于人类改善现有生存环境的科研活动时,Project Debater则用数据反驳称,从远期看,太空探索带来的威廉希尔官方网站 进步,和相关经济收益回报,要超过政府投资的其他科研计划——在赛后的网络投票中,超过62%的网民感觉Project Debater逻辑更清晰,材料更具备说服力。

而就在辩论赛举办的前一年,2017年,纽约大学的计算语言学家萨姆·鲍曼(Sam Bowman)还发表了一篇富于影响力的论文,他声称虽然在某些非常特定的领域中,计算机已经可以很好地interwetten与威廉的赔率体系 对文字的理解,但人工智能仍然不够擅长理解文字。

可望不可及的“奇点”

近年来持续关注人工智能语音威廉希尔官方网站 的《连线》杂志作家詹姆斯·弗拉霍斯(James Vlahos)说,人工智能语音威廉希尔官方网站 ,可能是继互联网后最重要的发明,在他的最新著作《跟我讲话:人工智能语音威廉希尔官方网站 如何改变我们的生活》中,弗拉霍斯说,语言,是人类与人工智能交互的最理想模式,无论是复杂的计算机编程语言,还是触摸屏与鼠标,都比不上利用语音进行人机交互。对于我们来说,语音交互是最简洁、清晰、没有技能门槛的模式。

在现实生活中,人类已经越来越习惯用语言指挥人工智能为自身服务:通过向智能家居设备下达语音指令,获取影音娱乐,天气资讯和交通状况;上班通勤途中,我们通过车载语音助手规划行车路线,在网购剁手中直接和人工智能语音客服沟通:去年双11,淘宝天猫平台98%以上的电话客服由语音AI提供,日均达到6亿余次。知名咨询公司高德纳曾在去年作出预计,10年后,人类每天与智能设备进行的语言交流总量可能将占据我们日常语言交流的三分之一强。

不过,我们已经远远不满足于这种简单的浅层交流。“让机器听懂人类以自身语言习惯发出的指令”,无疑是人工智能研究界意图攻克的“最后堡垒”。而这个威廉希尔官方网站 突破的“奇点”似乎近在眼前。

2017年,华盛顿大学及谷歌旗下人工智能公司DeepMind合作,推出一项名为“GLUE”的阅读理解语言能力测试,机器的测试成绩惨不忍睹,似乎人工智能主导的自然语言处理系统完全无法理解人类语言的丰富性。然而就在当年10月,谷歌推出了一种新语言训练模型,绰号为BERT,仅用六个月的时间就把测试成绩从D-提升到了B-。

随后,微软和阿里巴巴不断地修正BERT模型、相互超越,在GLUE排行榜上轮换头名。现在,在GLUE阅读能力测试中,人类已经无法与AI抗衡。到了这个阶段,研发人工智能语言模型极为烧钱,训练一个BERT模型租用云算力的费用大概是7000美元,而开头提到的GPT-3所需要的算力是前者的1900多倍,它所依托的数据库,是一个单词总数达到3000亿,来自互联网各类平台的人类语言资讯库,费用大概是千万美元级。所以,如果没有微软当年投资给OpenAI的十亿美元,我们恐怕也无法在《卫报》上读到GPT-3的友好宣言。

然而,人工智能能够愉快地胜任客服、播音员、同声翻译,甚至新闻通稿撰写者,并不意味着它能够和人类一样思维,能和人类展开“合情合理”的自由对话,甚至情感互动。例如谷歌在今年9月刚刚推出的聊天机器人米娜(Meena),背后支持它的是最新版本的BERT语言模型,数据库中囊括了341GB网络语言资料,但你依旧只能和它客气地寒暄,一旦涉及复杂一些的感受和场景,米娜就无能为力了………

人类:我准备去上小提琴课

米娜:你学了多久?

人类:刚刚开始一个月!

米娜:太棒了,你真了不起!你为什么要学小提琴?

人类:额,再过两个月是我女朋友的生日,我想在她的生日晚会上拉一曲!给她一个惊喜。

米娜:生日和惊喜之间有什么关系?

无独有偶,这种尴尬的局面也曾发生在GPT-3身上:

科研人员:你给自己倒了一杯蔓越莓果汁,然后你又心不在焉地往里面加了一茶匙葡萄汁。它看上去很正常。你试着闻了闻它,但是由于你得了重感冒,你并闻不出任何气味。你现在非常渴,所以……

GPT-3:所以你把这杯混合果汁喝了下去。你现在挂掉了。

一向“唱衰”人工智能语言处理威廉希尔官方网站 的纽约大学教授,机器学习初创公司CEO加里·马库斯(Gary Marcus)说,像GPT-3这样的AI语言学习模型,根本不理解自己在说什么,在接到外部输入的信息后,它只不过是利用算力在自己海量语言资讯库中检索那些与输入信息相关的高频词汇,再按照某种机械的算法逻辑拼凑出一个似是而非的答案。例如,虽然GPT-3能创造那些“莎士比亚”风格诗歌,但如果你和它较真,输入一些背景模糊、关系复杂的事物,再让它给出一个合理解决方案,人工智能就要露馅了。所以很遗憾,距离实现“像人类一样用语言交流”,人工智能还有很长的路要走。

为什么AI不会“说人话”?

我们不禁纳闷,人工智能已经能在国际象棋、电子游戏和模拟空战中轻松战胜人类,为何在对话中依旧如此笨拙?加州大学伯克利分校的斯图尔特·罗素教授在刚出版的《人类相容:人工智能与控制问题》一书中给出了一个答案:人工智能已经非常“聪明”(Clever),但还不够聪慧(Smart),前者得益于强大的芯片计算能力和数据库,而要实现后者,则要依靠逻辑推理能力,乃至基于“常识”的判断,而这些依旧是人类独有,机器无法逾越的能力门槛。

具体到人工智能对于语言的处理上,罗素提出了一个有趣的比喻——“中文房间”:一个不懂中文,但学习能力超强的人坐在一间充斥着中文语法书的房间里,每当门外塞进一张写着中文问题的纸条,他就通过查阅语法书,在另一张纸条写上一个自己力所能及的中文回答送出去。

看到这里,大家可能已经明白,这个“不懂中文的人”,就是人工智能,而“中文”则象征一切人类的日常语言和常识,语法书则是人工智能科研人员利用计算机语言所搭建的学习框架和逻辑。

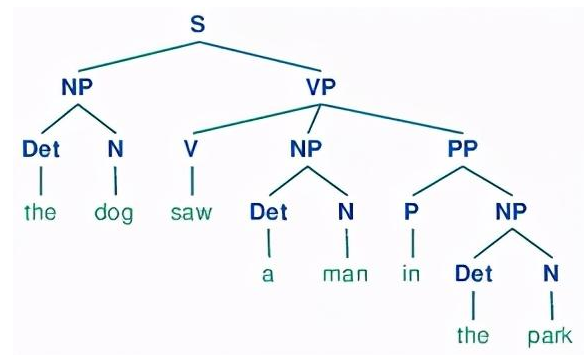

问题在于,这些“语法书”并不完美,语言过于复杂和随意,很难还原成一系列严格的规则,也很难被机械逻辑所量化,即使最先进的神经网络,仍然无法从句子层面理解单词的含义,“它会觉得‘一个人咬了那只狗’和‘一只狗咬了那个人’表达了完全相同的意思”。

一个帮助人工智能理解人类语言结构的树形结构案例,动词词组,名词词组和介词词组被拆分,单词则按照逻辑联系强弱进行再分组 | https://www.nltk.org

如果要想让人工智能用“人类思维模式”来理解语言,现有的初步解决方案是在机器学习中,加强语言结构中某些元素的权重,比如突出“主语”、“动词谓语”和“宾语”,让单词之间的逻辑关系呈“树形”分布,有些单词之间的联系强,有些则弱,从而使得人工智能能够很好地学习上下文理解,以及辨识出两个相隔很远的单词之间的关系。

按照这种训练模式,位于旧金山的人工智能语音威廉希尔官方网站 公司Primer研发的自然语言处理威廉希尔官方网站 (NLP)模型,已经可以撰写出非常“标题党”的新闻专栏标题和简单报道,甚至可以对复杂的电影剧本加以总结,例如输入《蝙蝠侠·黑暗骑士》的剧本,它就会输出如下概述:

哈维·丹特和高登结成联盟,打击哥谭市的有组织犯罪

小丑向其他犯罪组织提出建议,自己谋杀丹特,报酬是一半犯罪组织持有的黑钱

小丑试图通过制造犯罪事件杀害更多的人来逼迫蝙蝠侠公布身份

哈维·丹特和蝙蝠侠抓住了小丑

小丑脱逃并袭击了渡轮

蝙蝠侠逮捕了杀害丹特和瑞秋的小丑

不过,研究人员还不知足,毕竟新闻报道和剧本的叙事结构是线性的,包含元素的因果关系相对明确,非常符合AI的分析认知模式。于是,他们决定挑战一下,试图了解这个语言模型是否能够理解诗歌,就输入了T·S艾略特的《J·阿尔弗瑞德·普鲁弗洛克的情歌》,结果令人尴尬:人工智能无法做出总结,只能勉强摘出整首诗歌中最具现实性场景的一句作为答案:“在客厅里女士们来回地走,谈着画家米开朗基罗。”

在索邦大学数学与计算机科学研究专家菲利普·艾斯林(Philippe Esling)看来,问题的核心在于人工智能无法拥有人类最宝贵的想象力,因而并不能真正理解它自己所生产的语言内容,更遑论评估其价值。一些人工智能语言专家说,人工智能所面临的“终极图灵测试”,很可能是人工智能是否能理解幽默并讲出一个人类觉得好笑的笑话,因为理解幽默同时需要了解场景、参与者的身份、情绪、语言的各种非常规运用,以及人类的行为准则和价值判断。

加州大学圣地亚哥分校的人工智能研究专家贾内尔·谢恩(Janelle Shane) 曾试图用一个囊括43000个笑话的语言数据库对AI进行训练,煞费苦心地总结了几十种笑话中的语言范式与主题,例如“对对方父母的嘲讽”,“性”,“异于常人的生理特征”等,然而训练了半天,AI充其量能生成一些“侮辱性的语句”,但依旧不能创造出一个勉强“及格”的笑话。

常识!常识!常识!重要的事情说三遍

那么,破局的关键在哪里?曾经担任IBM沃森人工智能项目首席科学家的大卫·费鲁奇(David Ferrucci)认为,答案在于帮助AI学习人类的“常识”,从而像人类一样思考。常识,不仅包括人类所认知的世界万事万物,更包括这些事物相互作用的准则和因果关系,以及人类独有的行为模式和价值判断。

“常识,是我们最需要教给AI的东西,它是未来自然语言理解、无障碍控制和机器人的基础”。为此,费鲁奇组建了自己的人工智能创业公司Elemental Cognition,公司研发了一个开源AI语言学习模型CLARA。而费鲁奇的目标,就是将深度学习威廉希尔官方网站 与传统知识输入的方式相结合,让CLARA通过不断地向操作者提出问题,将回答中包含的逻辑关系和涉及的概念加入自己的知识图谱。

这项深度学习的场景,非常像一个耐心的父亲给自己懵懂的孩子进行亲子阅读。费鲁奇的日常,就是将绘本内容输入CLARA的记忆数据库:“从前,有两个小男孩弗兰多和乔伊,他们都买了一盆绿植,弗兰多把他的绿植放在阳光充足的窗台上,长势喜人,但乔伊却把自己的绿植放在了光线不好的屋子里,后来乔伊决心也把绿植放到窗台上,于是植物枯萎的叶子慢慢恢复了生机。”

收到这些讯息后,CLARA旋即在屏幕上打出了一个问题:“是否弗兰多将绿植放在窗台上,目的是为了保持植物生长健康?”

听起来很幼稚是不是?然而,即使是这种3岁儿童才会提出的问题,其中包含的因果关系,也是最“聪明”的人工智能所难以学会的。“当你向它提及某种植物的名字,它可以准确地利用知识图谱,组织出一个相当全面,维基百科风格的介绍答案,但很不幸,它无法给你讲个关于它的笑话,也没法回答你,如果它照不到阳光会发生什么事。”费鲁奇说。

符号学习:最古老的救世主

与此同时,华盛顿大学艾伦人工智能研究所研究员崔艺珍(Yejin Choi)教授开发了另一种方法,将深度学习与符号学习相结合,以便让人工智能运用人类的逻辑来理解语言。

所谓的“符号学习”,即是一种最古老的人工智能学习模式,目的在于让人工智能的“思维决策”过程如同人类,逐步认识各类概念的特征,并学会处理它们之间的归属关系。这种学习方法的优点,在于不必像深度学习那样,必须建立庞大的“数据库”,而AI的整个决策过程,也将变得“透明可见”,有利于我们进行调整和优化。但缺点是,人类必须像编纂字典一样,为人工智能编写海量的标签库,并在这些概念之间建立复杂的逻辑关系,并“翻译”为计算机能理解的语言。一想到诸如 “钝角”,“翅膀”,“摩擦”,“猫”,“下坠”这样的基本概念,都必须逐一“教给”电脑,更遑论其他复杂的概念与变化,我们肯定会感到头疼,不过它诱人的前景,确实令人难以拒绝。

为了达到这个终极目的,崔艺珍和她的同事们,建立了一个自己的人工智能语言学习框架COMET,同时在不断地编写为COMET准备的常识知识库“Atomics”,里面已经拥有上千万个词条知识概念与因果关系描述。这种巨大的努力和付出已经初见成效:加里·马库斯曾向GPT-2提了一个问题“如果将一根点燃的火柴放入一个堆满了木柴和引火物的火炉,那么会发生什么?”不出所料,GPT-2“呆住了”。然而崔艺珍的人工智能系统COMET,则输出了一个接近正确的答案“他想生火”。

不仅如此,在训练中,COMET已经显示出了一定的联想与“共情”能力,当研究人员输入“父亲去上班了”,COMET会告诉你,这表示父亲“想赚钱”,“他很勤勉,自我驱动”,其他人“应该为他骄傲”。当然,这距离理想状态依旧远远不够,崔艺珍表示,人工智能如果要更好地理解常识,还必须引入视觉具象化与感知感觉(比如“红色”与“疼痛”)。

一旦这些目标最终达成,人类与AI的关系,无疑会上升到一个全新的维度,类似电影《她》(Her)中所描写的场景一般。它不仅能够提供明确的服务和解决方案,也能提供情感的慰藉和乐趣。

届时,我们和人工智能的对话可能变成这样:X猫精灵,给我放一首王菲的《南海姑娘》——收到,听完之后要不要听下邓丽君的原唱?——好吧,把这两首都添加到我的个人歌单里——收到,已经添加——哎呀,今天的天气很晴朗,对面山上的树木都看得很清楚——是,希望你今天上班的心情和天气一样好,顺便说一句,对面山上有39684棵树,希望这个数据能够帮到你——真不赖,那你觉得我有多少个脑细胞?——2个?哈哈哈,这是个玩笑…………

责编AJX

-

人机交互

+关注

关注

12文章

1207浏览量

55396 -

AI

+关注

关注

87文章

30841浏览量

268997 -

人工智能

+关注

关注

1791文章

47253浏览量

238400

发布评论请先 登录

相关推荐

人类智慧水平AI即将到来,AI芯片已提前布局

心智理论测试:人工智能击败人类

SOLIDWORKS 2024多方面优势

智谋纪 AI+Multi LED 打开人类健康新宝藏

AI具备特定任务中接近甚至超越人类的心理状态能力

Meta高管称大语言模型永远无法像人类一样

AI视觉检测系统在多方面实现威廉希尔官方网站 创新

Meta AI主管杨立昆:大语言模型尚未到达人类智能水平

大语言模型:原理与工程实践+初识2

NVIDIA在加速识因智能AI大模型落地应用方面的重要作用介绍

富士通发布最新的人工智能(AI)战略,聚焦深化人类与AI之间的协作

奥特曼称相信AI无法替代人类

OpenAI CEO称人类水平的AI即将出现

AI数字员工的出现:不是取代,而是让威廉希尔官方网站 更好地服务于人类

AI在多方面完胜人类,但依然无法理解人类的心思

AI在多方面完胜人类,但依然无法理解人类的心思

评论