漫画是很多人的童年回忆,除了经典的《银魂》、《海贼王》、《火影》,久保带人的作品《死神》也很有人气。最近,六位来自北航的研究者推出了一款漫画脸转换模型「MangaGAN」,实现了真人照片到漫画脸的完美转换。

我们可以合理怀疑,几位论文作者都是久保带人的粉丝。

这篇论文中提出的「MangaGAN」,是一种基于生成对抗网络(GAN)的非成对照片到漫画转换方法。用来训练 MangaGAN 的数据集也来源于一部非常受欢迎的漫画作品——久保带人的《死神(Bleach)》,包含漫画人脸的面部特征、特征点、身体等元素,所以生成结果也带有强烈的久保带人风格。

标准漫画脸是如何生成的?

MangaGAN 生成漫画脸的整体流程。

总体来说,MangaGAN 包含两个分支:

一个分支通过几何转换网络(Geometric Transformation Network,GTN)学习几何映射;

另一个分支通过外观转换网络(Appearance Transformation Network,ATN)学习外观映射。

最后通过合成模块将二者融合,从而生成漫画脸。

假设 P 表示照片,M 表示生成的漫画脸,二者之间不存在成对关系。给定一张照片 p∈P,MangaGAN 学习映射

将 p 迁移至样本

(m∈M),同时为 m 加上漫画风格和面部相似度。

图中(f)步骤通过 GTN 勾勒出夸张的几何线条,并确定五官的几何分布位置;图中(e)步骤则通过 ATN 生成所有的面部特征,包括眼睛、鼻子和嘴巴。继而通过合成模块将几何轮廓和面部特征相融合,输出漫画脸 m∈M。

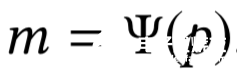

外观转换:ATN

ATN 是一个 multi-GAN 结构的网络,包含四个局部 GAN,分别用来转换眼、口、鼻和头发这四个面部位置。针对每个部位的 GAN,会有专属的训练策略和编码器以改善其性能。

眼睛和嘴巴是漫画脸的灵魂所在,但也是最难转换的部分,随着表情的变化,这两个部位的特征也会变化。

对于眼睛和嘴巴部位,为了实现更好的非成对数据匹配,研究者将 CycleGAN 与反向映射(reverse mapping)相结合,并进行了三项改进:

第一,设计了一个带有 SP loss L_SP 的 Similarity Preserving (SP) 模块,以增强相似度;

第二,训练编码器 E^eye 用于提取 p^eye 的主干,训练编码器 E^mouth 用于提取 p^mouth 的轮廓线条;

第三,提出结构平滑损失 L_SS,帮助网络生成笔触平滑的漫画脸。

使用不同的改进方法得到的眼部和嘴部区域对比情况。

上图第 5 列和第 11 列展示了使用 SP 模块进行改进的效果;第 6 列和第 12 列分别展示了使用编码器 E^eye 和 E^mouth 的改进效果;第 4 列和第 10 列展示了使用结构平滑损失进行改进的效果。

鼻子和头发的生成则相对简单,大部分动漫人物的鼻型相似,因此该研究使用基于 ProGAN 的架构生成鼻子。头发部分则使用了 APDdrawingGAN,通过头发分割方法划分出大致的头发区域,然后使用肖像分割方法移除多余的背景区域,即可生成类似漫画风格的头发样式。

几何转换:GTN

在转换面部特征点时会遇到一个问题:面部特征的搭配模式限制了结果的多样性。比如,脸型相同的人可能有着不同的眼口鼻大小或位置,但 GAN 在接受全局人脸特征点训练时可能遵循固定或类似的搭配模式。因此研究者也将「几何特征」分解为三种属性:脸型、位置、大小,并使用三个 sub-GAN 分别转换。

GTN pipeline。几何信息被分为三种独立属性:位置、大小和脸型,然后使用 N_loc、N_siz、N_sha 三个 sub-GAN 分别进行转换。

最终,如图 5(b) 所示,基于预定义的脸颊和额头比例,生成了整张漫画脸的几何特征。

最后一步:融合

这一步的目的是融合人脸特征和几何特征,从而生成漫画脸。

如上图所示,首先,根据几何特征来调整和定位各面部特征组件;

其次,基于分段三次 Hermite 插值多项式 (PCHIP) 方法,获得平滑的曲线并保留脸部形状,然后通过拟合生成人脸特征点的曲线来绘制脸型;

然后,模型提供了 10 种漫画式耳朵供选择,而非按照片重新生成,因为耳朵的样式对面部表情来说影响不大;

此外,研究者还收集了 8 种漫画人物身体(manga body),用来与生成的漫画脸搭配。

最后就可以输出漫画结果啦。该模型提供了快速微调尺寸和位置的工具,以及鼻子、耳朵和骨架等组件的切换工具,用户可以按照个人喜好进行调整,生成自己喜欢的漫画脸。

MangaGAN 效果如何?

该研究所用的实验数据集包括三部分:漫画数据集、照片数据集和人像数据集。漫画数据集来源于一部流行的漫画作品《死神》,包括 448 双眼睛、109 个鼻子、179 个嘴巴和 106 张正面漫画脸。

研究者将 MangaGAN 与 9 种漫画脸生成 SOTA 方法进行了对比,效果生成如下图所示:

可以看到,其他方法生成的漫画脸都会有扭曲和突兀的线条,或是面部存在莫名的阴影,其原因在于生成过程中忽视了几何特征的转换。相比之下,MangaGAN 生成的脸部十分干净利落,没有多余的部分。

接下来是跨域转换层面中 MangaGAN 与其他方法的对比。为公平起见,CycleGAN 和 UNIT 先转换全脸再转换每个人脸特征。最终效果如下图所示:

很明显,其他方法在匹配照片和漫画时容易出现问题,它们更关心二者的黑暗区域是否匹配,但没有转换脸型和笔触。MangaGAN 的生成结果则更接近理想中的漫画脸,脸型棱角分明,眉形平滑,嘴巴也进行了简化,几乎完全符合手绘漫画的人物长相特征。

责任编辑:pj

-

几何

+关注

关注

0文章

37浏览量

12350 -

合成

+关注

关注

0文章

16浏览量

13780 -

ATN

+关注

关注

0文章

5浏览量

3615

发布评论请先 登录

相关推荐

光波导系统中光栅几何结构的优化

光波导系统中光栅几何结构的优化

TVP7002+THS8200 VGA输出图像出现垂直线条有锯齿,是什么原因导致的?

dac38j82 IOUTx为什么没有波形输出?

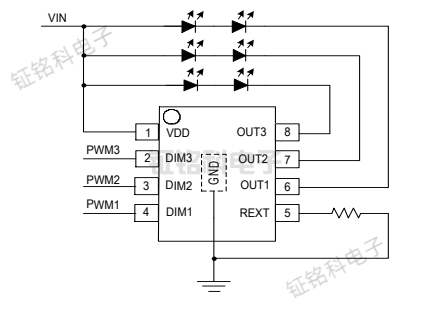

低压线性恒流LED恒流驱动芯片:用于洗墙灯和线条灯

机床的几何精度什么和什么时是有区别的

数控机床的几何精度是表明所测量的什么

Thinborne揭示Galaxy Z Fold6 CAD渲染图,线条硬朗,重量轻盈

WD4000无图晶圆几何量测系统

低压线性恒流LED恒流驱动芯片SM15633EH:用于洗墙灯和线条灯

mpo光纤跳线2进24出的怎么接?

“芯”动未来,无图晶圆几何量测系统提升半导体竞争力

基于图像处理威廉希尔官方网站 的螺纹几何参数测量系统设计

GTN可以勾勒出夸张的几何线条?

GTN可以勾勒出夸张的几何线条?

评论