随着无线协议变得越来越复杂,频谱环境的竞争日益激烈,电子战也越来越复杂。无线电所需的基带处理程度也更加复杂和专业化。

在充满威胁的复杂环境下,想要完全优化射频系统是不现实的。设计人员以前一直依赖简化的封闭式模型,但是这些模型无法准确捕捉到真实效果;而且对系统的优化也非常零碎,仅能优化单个组件,无法进行完整的端到端优化。

在过去几年里,人工智能已经取得了长足的进步,尤其是机器学习威廉希尔官方网站 中的深度学习。为了解决众多棘手问题,人类设计人员一直都在花费大量精力研究手动式工程解决方案,而深度学习则直接将目标对准了针对特定问题的大型复杂数据集。

AI和无线电射频

如要了解AI如何简化RF系统设计的复杂性,就需要从大局上了解最近哪些威廉希尔官方网站 进步推动了AI系统的迅速普及。“AI”这个术语已经使用了几十年,从广义上讲,是指基于机器决策的问题解决方法。机器学习(ML)属于AI的一种,指使用数据对机器进行训练,以解决特定问题。深度学习是一类具有“特征学习”能力的机器学习威廉希尔官方网站 ,在这个过程中,由机器决定使用哪些方面的数据作为决策依据,而不是由人类设计人员规定某些明显的特征作为决策依据。

例如,设计人员以前都是根据多年的特征识别威廉希尔官方网站 研究心得,手动编写面部识别算法。而深度学习方法将包含人脸的图像数据集与操作人员训练结合起来,可识别出人脸的位置。机器会学习识别人脸的构成,不需要设计人员定义算法。

同样,RF信号分类和频谱感知算法也从深度学习方法中获益匪浅。过去的自动调制分类(AMC)和频谱监测方法需要耗费大量人力来进行手动工程特征提取(工程师团队通常需要花费数月时间进行设计和部署),而基于深度学习的系统通过几小时的训练,就能识别新的信号类型。深度学习还允许端到端学习,通过这种方式,一个模型可以同时学习编码器和解码器,从而构成一个完整的收发系统。该模型不需要尝试逐个优化每个组件(例如,数模转换器[DAC]、模数转换器[ADC]、射频转换器、无线信道和接收器网络),并将它们拼接在一起,而是将系统视为端到端函数,学习从整体上优化系统。

SDR将宽带前端和功能强大的处理器相结合,为信号分析应用提供了理想的平台。人工智能和深度学习威廉希尔官方网站 可以训练系统,使系统检测信号的速度远超手工编写的算法。了解DeepSig如何将COTS SDR与人工智能和深度学习相结合。

用于防御的COTS CR 系统通常包括两种类型:

1. 部署在现场的紧凑型系统,利用人工智能实时确定可作为行动依据的情报。这些系统采用FPGA和通用处理器(GPP),有时会额外配备紧凑型图形处理单元(GPU)模块。

2. 需要密集计算的模块化可扩展系统,通常由与高端服务器相连的CR组成,具有功能强大的GPU,可进行离线处理。这些系统经常需要用到较大型的RF仪器,而且由于数据处理量增加,往往需要使用吞吐量更高的总线,例如PCIe。

对于低SWaP系统来说,FPGA硬件处理效率、低延迟性能以及GPP可编程性就非常关键。虽然对FPGA进行编程可能会使开发变得复杂一些,但这是实时系统实现低SWaP的关键。为此,NI和Ettus Research联合开发了通用软件无线电外设(USRP),为这些系统提供了紧凑的现成平台。用户可编程FPGA是USRP设备的固有组成部分,直接集成LabVIEW或开源软件,例如芯片射频网络(RFNoC),可降低使用硬件描述语言对FPGA进行编程的难度。

对于大型计算密集型系统而言,拥有可扩展并且可以异构利用同类最佳处理器的硬件架构意义重大。这些架构通常包括用于基带处理的FPGA、用于控制的GPP以及用于AI处理的GPU。GPU既能够处理大量数据,同时也相对易于编程。GPU的缺点是数据管道长,导致传输时间较长,不过这个问题只对需要超低延迟的系统有影响。当然,这两类系统中都有许多设备以牺牲性能为代价来降低功耗,在设计分析中应该对此加以权衡。

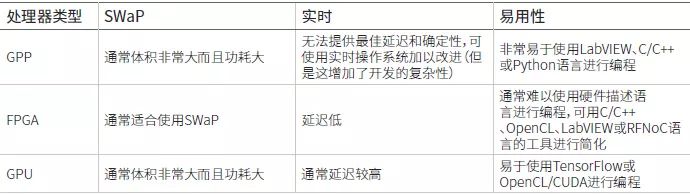

表1. 认知无线电的处理器选项

举例来说,美国国防高级研究计划局(DARPA)频谱协同挑战赛(Spectrum Collaboration Challenge)中使用的Colosseum试验台就是一个大型计算密集型系统。该系统包含128个带有板载FPGA的双通道USRP(Ettus X310)、带有多个FPGA的ATCA-3671刀片服务器,以及基于GPU的高端服务器,其中ATCA-3671服务器主要用于数据聚合,GPU则可进行强大的AI处理。

图1.DARPA Colosseum测试台配备128个Ettus X310 USRP和NI ATCA-3671处理单元。

部署系统中的AI

如果使用经过训练的深层神经网络执行信号检测和分类,只需要几毫秒的时间。与使用传统方法的迭代和算法式信号搜索、检测和分类相比,这种模式可将性能提高好几个数量级。这些优势同时也有助于降低功耗和计算要求,训练模型的灵敏度通常至少是现有方法的两倍。

美国的DeepSig是一家专门从事信号处理和无线电系统业务的初创公司。其OmniSIG传感器软件产品中使用了基于深度学习的商业化RF传感威廉希尔官方网站 。该产品可与NI和Ettus Research的USRP兼容。借助深度学习的自动特征学习功能,OmniSIG传感器只需经过几秒钟的信号捕获和训练,就可以识别新的信号类型。

对于学习型通信系统,包括便于直接在物理层进行训练的端到端学习,可使用DeepSig的OmniPHY软件来学习如何在恶劣的信道条件和频谱环境以及硬件性能有限的情况下优化通信系统。其中包括非视距通信;抗干扰能力;激烈对抗环境中的多用户系统;和硬件失真效应抑制。

图2.OmniSIG传感器使用通用SDR对蜂窝频段内的信号进行检测和分类。

学习型通信系统的优势之一是可以针对不同任务轻松进行优化。比如有些用户更关心吞吐量和延迟,而有些用户可能会优先考虑作战信息链距离、功耗,甚至签名和检测或拦截概率。此外,在机器学习中,对作战环境越了解,训练出的解决方案就越有效。

将基于深度学习的感测和有源无线电波形相结合,可实现全新的自适应波形和电子战,从而能够应对当今对抗激烈频谱的环境。对于基于深度学习的系统训练而言,处理器性能十分重要,但是经过训练后,该模型就可以很容易地部署到低SWaP嵌入式系统中,例如边缘传感器和战术无线电。

为什么在信号分析系统中使用SDR?

SDR的核心元件是射频前端和处理单元,因而非常适合原型和部署基于AI的信号分析系统。USRP的低SWaP使其非常适合通信情报部署,用于检测低于6 GHz频率的信号。

对于高频率和计算密集型应用,PXI平台仪器可以扩展至毫米波频率,可处理的频段最高可达Ka频段,通过x8 PCIe链路提供更高的数据吞吐量,并采用包含多个Xilinx Virtex-7 FPGA的ATCA模块进行海量数据处理。

如果要检测可能采用扩频或跳频威廉希尔官方网站 且频率未知的不良信号,就需要采用宽带接收机。COTS SDR集成了最新的宽带ADC和DAC来解决这一问题。另外,您可以组成多通道系统,通过将接收器信道调谐到相邻频段来扩展有效带宽,或者通过共享本地振荡器来实现通道间的相位一致性。这样不仅能够检测和识别信号,还能对信号进行测向和定位。

NI和Ettus Research USRP采用异构架构来处理SDR和主机PC上的信号。由于认知系统需要生成输出信号来响应频谱感测或接收到的信号,SDR上的板载内联处理功能就显得非常重要。FPGA板载处理可以提供很多好处,例如,通过传输或仅存储感兴趣的信号,来降低延迟(与主机双向传输所有数据相比)和减少数据链路或总线上的数据。

恶劣的电磁环境要求信号分析系统能够检测未知信号并快速适应新的威胁。具有深度学习能力的算法可以接受训练以识别新信号,同时缩短开发时间。而且,SDR架构具有低SWaP、实时处理能力、宽带前端和灵活编程等优点,无疑是部署基于AI的信号分析系统的理想之选。

-

射频

+关注

关注

104文章

5585浏览量

167738 -

SDR

+关注

关注

7文章

233浏览量

50482 -

深度学习

+关注

关注

73文章

5503浏览量

121154

原文标题:人工智能应用于SDR的信号分析系统

文章出处:【微信号:mwrfnet,微信公众号:微波射频网】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

《算力芯片 高性能 CPUGPUNPU 微架构分析》第3篇阅读心得:GPU革命:从图形引擎到AI加速器的蜕变

NPU威廉希尔官方网站 如何提升AI性能

NPU在深度学习中的应用

pcie在深度学习中的应用

AI干货补给站 | 深度学习与机器视觉的融合探索

FPGA加速深度学习模型的案例

FPGA做深度学习能走多远?

NVIDIA推出全新深度学习框架fVDB

基于AI深度学习的缺陷检测系统

人工智能、机器学习和深度学习是什么

泰禾智能携AI智选深度学习系列新品亮相临沂花生展

HDC2024华为发布鸿蒙原生智能:AI与OS深度融合,开启全新的AI时代

基于AI与深度学习的SDR硬件架构

基于AI与深度学习的SDR硬件架构

评论