神经模态芯片的发展方向首先是规模化,即扩大神经元的规模,这也是Intel和IBM等大厂主要押注的方向。

如果我们回顾深度学习的发展历程,我们会发现其实神经网络的原理早在上世纪60年代就已初见雏形,但是由于训练数据量不够以及算力不够,因此直到2012年才被人们重新发现,并且发现了众多之前完全没有想到的应用场景和市场。对于神经模态计算,大厂押注的也是类似的情况:神经模态计算的原理看起来是正确的(尤其是今天深度学习已经获得了很大的成功,那么基于相似原理的神经模态计算应该不会很不靠谱),目前或许只要把神经元的数量和神经突触连接数量跨过一个阈值(就像当年AlexNet跨过网络深度的门槛一样),那么神经模态计算就有可能爆发出巨大的能量,甚至远超之前的想象。这次Intel发布的超过八百万神经元的Pohoiki Beach系统显然就是在往规模化的方向大力发展。

根据Intel的官方消息,下一步将继续发布神经元数量更大的Pohoiki Spring计划,可见Intel是在往大规模神经模态计算的方向大力推进。

除了发展规模化之外,另一个方向就是利用神经模态计算低功耗和低延迟的特点并进一步优化芯片设计来开发出高能效比低延迟的芯片。这类芯片或许神经元数量不多,但是可以实现非常低的功耗和非常好的能效比,从而可以部署在传统深度学习无法部署的场景。事实上,目前如何高效训练大规模神经模态神经元的算法还没有找到,因此在现有训练框架的基础下,或许优先把能效比做到极致是比把神经元数量做大更接地气的方向。

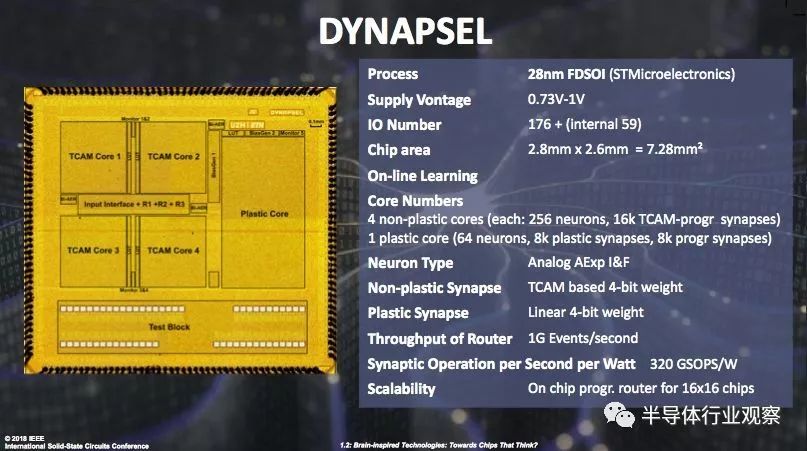

瑞士苏黎世理工大学的Giacomo Indiveri教授就是这个方向的代表性人物,研究组在十数年内已经发表了多篇电路和系统论文,其研发的芯片作为欧洲神经模态计算研究的代表性工作在2018年ISSCC主题演讲中被重点介绍。

-

IBM

+关注

关注

3文章

1757浏览量

74691 -

intel

+关注

关注

19文章

3482浏览量

185990

原文标题:市面精品 | 全套英语学习资源泄露,手慢则无!(禁止外传)

文章出处:【微信号:AI_shequ,微信公众号:人工智能爱好者社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

模态分解合集matlab代码

结合芯片行业现状,数字芯片设计什么方向最值得投身?

未来AI大模型的发展趋势

人工智能神经网络芯片的介绍

神经网络芯片与传统芯片的区别和联系

神经网络芯片和普通芯片区别

OpenHarmony实战开发-如何实现模态转场

自动驾驶和多模态大语言模型的发展历程

语音识别威廉希尔官方网站 最新进展:视听融合的多模态交互成为主要演进方向

神经模态芯片发展的方向

神经模态芯片发展的方向

评论