解析机器学习的局限与明天

在论坛开场之初,戴文渊引出主题:机器学习的明天是一个很难的问题,公众关心更多的可能是机器学习或深度学习,以及随阿法狗出现火起来的强化深度学习。机器学习的明天很可能是今天大家看来是一个冷板凳的领域,正如20年前的深度学习。因此今天要谈的明天的机器学习,戴文渊认为一定不是深度学习。因此,本次论坛要探讨的很可能是一个在大家看来会觉得离应用很远、很不现实的事物,但是很可能会成为十年后重要机器学习方向之一。

今日头条科学家李磊带来的演讲是《会思考的通用智能机器还有多远?》。在演讲中,李磊主要对人工智能是什么?人工智能发展到什么程度以及面临的挑战三个方面进行了阐述,李磊首先阐述了对人工智能的两种定义:类人智能和理性智能。类人智能的目标是让机器像人那样思考、决策、解决问题,具备学习能力和行动能力。理性智能是研究如何通过计算方法达到合理的感知、决策、解决问题、学习和行为能力。不是和人去比较,而是把计算看成自然现象。

人工智能要研究的内容十分广泛,包括知识表示、形式化推理、规划与决策、机器学习、理解文字、自然语言(人类语言)、语音识别与合成、理解图像、视觉感知以及机器人控制。目前人工智能在某些具体任务上达到或超过人类能力,但通用型智能还有漫漫长路。

李磊介绍到头条最近发布了一款奥运机器人,可以在奥运期间自动发布了450条新闻。他谈到经过过去多次的实践证明:深度学习加大数据可以较好地解决监督学习的问题。

深度学习从人脑解决问题的的思路出发,创造了人工神经网络和人工神经单元的概念,随着层数的加深,神经网络能够完成一些合理对话之类的任务。但是仍需注意人工智能和机器学习不仅仅是监督学习和深度学习,要解决的问题其实更多,目前的深度学习还有很大的局限性,例如依赖大量标注数据,并且这些数据的获取代价非常高;此外,目前的深度学习的通用性还不够强。

最后,李磊总结了明天机器学习需要突破的三个方面:

需要有可解释性的机器学习,当机器学习模型成功和失败的时候,需要知道它成功或者失败的原因;机器学习能够做更多的推理,而不仅仅是简单的判断;过去做深度学习时需要很多的计算集群,需要耗费大量的能力,未来的是否可以实现在不影响性能的情况下实现单位能耗呢?

林宙辰:机器学习一阶优化算

北京大学信息科学威廉希尔官方网站

学院机器感知与智能教育部重点实验室教授林宙辰带来的分享是 《机器学习一阶优化算法》。他主要分享了机器学习在过去、现在、未来的优化方面的问题。从上个世纪90年代,优化威廉希尔官方网站

就已经发展的比较完备了。在此之前,可以划分为两个阶段,第一阶段到上世界60年代,此前的优化方法较为缓慢;在60年代到90年代,随着计算机的发明,有着很大进展。

按照当时所用信息类别可以划分为三类:

第一类是只用目标函数的方法;第二类是一阶的方法,也就是目标函数和梯度方法;第三类是二阶方法,如Newton’s Methods、Sequential Quadratic Programming、Interior Point Methods。

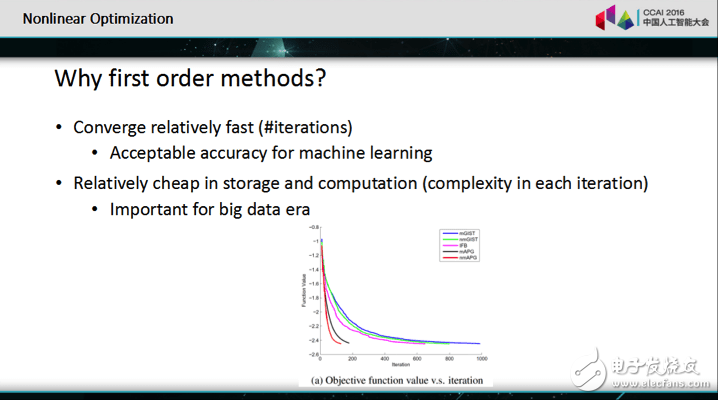

接着,林宙辰谈到了选择一阶方法的两个原因,并认为一阶的方法是机器学习里面一个主流的学习方法。

因为一阶方法对数字精度的要求不太高;一阶方法的存储和和计算的成本较低。

从90年代到现在,主要是对一些现有的方法进行复兴和更好的改进。接着,他总结了一阶方法从过去到现在的研究进展,主要包括六个方面:

Smooth -》 Nonsmooth:光滑可以对每一个点选一个梯度,选非光滑就不能选梯度,那么次梯度就比较慢,现在就是使用Proximal; Convex -》 Nonconvex:首先一般只能证明非真的,如果好一点就每个据点都会收到临界点上面,2012年开始有一个非常好的理论突破,就是把这个几何理论引入到优化里面,常用的函数基本都属于这种函数类型;Deterministic -》 Stochastic:在大数据情况下,很难能够有计算量支持确定性,所以只能随机抽取一些样本来算,2013年张老师提出来方差下降,可以进行加速; One/Two Blocks -》 Multiple Blocks:如果是一个或者两个Block可以作为一个交界;Synchronous -》 Asynchronous:同步会导致很多机器要等着其他的机器算完之后才能进行分析,所以需要异步; Convergence & Convergence Rate:Convergence Rate分析方面有更好的威廉希尔官方网站 ,尤其是加速差值技巧。

演讲结尾,林宙辰表示,未来的机器研究方面会集中在两个方向:

计算的规模会进一步增加,需要采用完全随机的方式进行,否则大数据之下是无法完成这些计算的;利用量子计算的方法来参与规划,可以在两个层面进行:

将传统的算法每个步骤进行量子化;在整体上设计量子的算法。

非常好我支持^.^

(0) 0%

不好我反对

(0) 0%