电子发烧友网报道(文/李弯弯)在深度学习中,经常听到一个词“模型训练”,但是模型是什么?又是怎么训练的?在人工智能中,面对大量的数据,要在杂乱无章的内容中,准确、容易地识别,输出需要的图像/语音

2022-10-23 00:19:00 24517

24517 分布式深度学习框架中,包括数据/模型切分、本地单机优化算法训练、通信机制、和数据/模型聚合等模块。现有的算法一般采用随机置乱切分的数据分配方式,随机优化算法(例如随机梯度法)的本地训练算法,同步或者异步通信机制,以及参数平均的模型聚合方式。

2018-07-09 08:48:22 13627

13627

随着预训练语言模型(PLMs)的不断发展,各种NLP任务设置上都取得了不俗的性能。尽管PLMs可以从大量语料库中学习一定的知识,但仍旧存在很多问题,如知识量有限、受训练数据长尾分布影响鲁棒性不好

2022-04-02 17:21:43 8830

8830 NLP领域的研究目前由像RoBERTa等经过数十亿个字符的语料经过预训练的模型汇主导。那么对于一个预训练模型,对于不同量级下的预训练数据能够提取到的知识和能力有何不同?

2023-03-03 11:21:51 1353

1353 训练好的ai模型导入cubemx不成功咋办,试了好几个模型压缩了也不行,ram占用过大,有无解决方案?

2023-08-04 09:16:28

Edge Impulse是一个应用于嵌入式领域的在线的机器学习网站,不仅为用户提供了一些现成的神经网络模型以供训练,还能直接将训练好的模型转换成能在单片机MCU上运行的代码,使用方便,容易上手。本文

2021-12-20 06:51:26

工具篇Flair之训练模型教程

2020-04-27 14:03:05

),其中y取值1或-1(代表二分类的类别标签),这也是GBDT可以用来解决分类问题的原因。模型训练代码地址 https://github.com/qianshuang/ml-expdef train

2019-01-23 14:38:58

PaddlePaddle Fluid版本的PaddlePaddle如何在训练前加载此前训练好的模型?

2019-04-15 11:19:15

本教程以实际应用、工程开发为目的,着重介绍模型训练过程中遇到的实际问题和方法。在机器学习模型开发中,主要涉及三大部分,分别是数据、模型和损失函数及优化器。本文也按顺序的依次介绍数据、模型和损失函数

2018-12-21 09:18:02

能否直接调用训练好的模型文件?

2021-06-22 14:51:03

本帖最后由 wcl86 于 2021-9-9 10:39 编辑

`labview调用深度学习tensorflow模型非常简单,效果如下,附上源码和训练过的模型:[hide][/hide

2021-06-03 16:38:25

准备开始为家猫做模型训练检测,要去官网https://maix.sipeed.com/home 注册帐号,文章尾部的视频是官方的,与目前网站略有出路,说明训练网站的功能更新得很快。其实整个的过程

2022-06-26 21:19:40

TOP1的桂冠,可想大家对本书的认可和支持!

这本书为什么如此受欢迎?它究竟讲了什么?下面就给大家详细~~

本书主要内容

本书围绕大语言模型构建的四个主要阶段——预训练、有监督微调、奖励建模和强化

2024-03-11 15:16:39

,导出onnx

这里就取了个巧,直接用torch官方库里面预训练好的模型导出来,得到onnx模型。后续还可以进一步转化为-sim.onnx文件,做了一定的简化,不过差别不大。

import torch

2023-12-10 16:34:43

` EasyDL网站可以免费生成针对EdgeBoard板卡FZ5的离线训练模型SDK,该SDK可以完美与FZ5硬件契合,最重要的是——free(免费)。下面就是针对FZ5生成模型SDK的实例——图片

2021-03-23 14:32:35

的模型似乎只提供了更多的图像,而世界上并不缺少图像。研究生成模型有几个原因,包括: ●从生成模型中进行训练和采样是对我们表示和操作高维概率分布能力的极好测试。高维概率分布是...

2021-09-15 06:03:29

医疗模型人训练系统是为满足广大医学生的需要而设计的。我国现代医疗模拟威廉希尔官方网站

的发展处于刚刚起步阶段,大部分仿真系统产品都源于国外,虽然对于模拟人仿真已经出现一些产品,但那些产品只是就模拟人的某一部分,某一个功能实现的仿真,没有一个完整的系统综合其所有功能。

2019-08-19 08:32:45

RS-LiDAR-Algorithms 感知算法。经过与多个自动驾驶汽车研发团队的联合调试打磨,RS-LiDAR-Algorithms 目前已经可以驾驭常见的大部分自动驾驶场景,其以内测为主的阶段性使命已经完成。速腾

2017-12-15 14:20:48

增加学习功能并应用于机器学 习,发明了感知器算法[20],该算法使用 MCP 模型能够 采用梯度下降法从训练样本中自动学习并更新权 值,并能对输入的多维数据进行二分类,其理论与实 践的效果引起了

2022-08-02 10:39:39

问题最近在Ubuntu上使用Nvidia GPU训练模型的时候,没有问题,过一会再训练出现非常卡顿,使用nvidia-smi查看发现,显示GPU的风扇和电源报错:解决方案自动风扇控制在nvidia

2022-01-03 08:24:09

CV:基于Keras利用训练好的hdf5模型进行目标检测实现输出模型中的脸部表情或性别的gradcam(可视化)

2018-12-27 16:48:28

一个超平面上的线性二分类模型。作为原著第二章,实在是简单得不能再简单了。然而实际运用中,越简单的模型往往生命力越顽强。这里唯一需要补充的是,感知机是个在线学习模型,学习一个训练实例后,就可以更新整个

2019-01-14 11:15:41

使用TensorFlow的transform_graph工具生成一个优化的8位模型,该模型效率更高,但精度较低。

4.在设备上对优化的模型进行基准测试,并选择最符合您部署需求的模型。

本教程使用预训练

2023-08-02 06:43:57

我正在尝试使用 eIQ 门户训练人脸检测模型。我正在尝试从 tensorflow 数据集 (tfds) 导入数据集,特别是 coco/2017 数据集。但是,我只想导入 wider_face。但是,当我尝试这样做时,会出现导入程序错误,如下图所示。任何帮助都可以。

2023-04-06 08:45:14

无法确定如何转换 PyTorch 掩码 R-CNN 模型以配合OpenVINO™使用。

2023-08-15 07:04:51

PyTorch Hub 加载预训练的 YOLOv5s 模型,model并传递图像进行推理。'yolov5s'是最轻最快的 YOLOv5 型号。有关所有可用模型的详细信息,请参阅自述文件。详细示例此示例

2022-07-22 16:02:42

(1 GPU)和时间(24小时)资源下从头开始训练ViT模型。首先,提出了一种向ViT架构添加局部性的有效方法。其次,开发了一种新的图像大小课程学习策略,该策略允许在训练开始时减少从每个图像中提

2022-11-24 14:56:31

永磁交流伺服电机模型是什么?永磁交流伺服电机模型有哪几种控制策略?

2021-09-27 06:04:42

到准备模型,然后再在边缘的嵌入式系统上运行。训练深度学习模型是过程的工作量和时间密集型部分,其中通过提供需要时间和

2021-10-27 06:34:15

深度融合模型的特点,背景深度学习模型在训练完成之后,部署并应用在生产环境的这一步至关重要,毕竟训练出来的模型不能只接受一些公开数据集和榜单的检验,还需要在真正的业务场景下创造价值,不能只是为了PR而

2021-07-16 06:08:20

tensorflow模型部署系列的一部分,用于tflite实现通用模型的部署。本文主要使用pb格式的模型文件,其它格式的模型文件请先进行格式转换,参考tensorflow模型部署系列————预训练模型导出。从...

2021-12-22 06:51:18

),其中y取值1或-1(代表二分类的类别标签),这也是GBDT可以用来解决分类问题的原因。模型训练代码地址 https://github.com/qianshuang/ml-expdef train

2019-01-25 15:02:15

请问LIDAR感知挑战有哪些?

2021-06-17 11:49:08

目前官方的线上模型训练只支持K210,请问K510什么时候可以支持

2023-09-13 06:12:13

我在matlab中训练好了一个神经网络模型,想在labview中调用,请问应该怎么做呢?或者labview有自己的神经网络工具包吗?

2018-07-05 17:32:32

基于模型的动态测试工具TPTTPT特性PikeTec公司是全球知名的基于模型的嵌入式系统测试工具TPT的软件供应商,总部位于德国柏林,其创始人均在戴姆勒公司拥有十多年的软件测试经验。TPT作为针对

2022-07-25 15:35:26

分析动态自适应网络安全模型P2DR的缺陷,提出对P2DR模型的几点改进建议。针对模型中策略相关不足设计了一个策略部署模型,该部署模型实现了策略统一定制、自动分发、自适应管

2009-04-13 09:40:16 27

27 在介绍策略、域和策略目标等基本概念的基础上,提出了一个通用性的策略部署模型,该模型采用基于域的分层结构,把策略存储在离策略目标最近的域中,并以递增式算法进行收

2009-05-25 21:47:02 7

7 最佳捕鱼策略的数学模型本文的数学模型提法清楚,相对于捕捞强度递增的不同预测值,对鱼群变化进行动态模拨。

2009-09-16 11:37:32 113

113 本文通过对水印系统感知特性和感知现象的讨论,分析watson感知模型设计思想,研究Watson感知模型的应用。

2011-09-01 10:14:50 2888

2888 水印系统不可能产生不可察觉的水印,其感知性只能用高低来衡量。这就需要对水印的感知性进行感知效果评价及建立相应的感知模型进行描述。本文通过对水印系统感知特性和感知现

2011-10-13 17:05:38 24

24 雾霾监测点作为雾霾数据感知的源头,由于缺乏有效的评价方法,导致感知的数据不可靠。针对此问题,提出一种感知源信任评价和筛选模型,该模型采用数据触发检测方式来进行。当感知源的数据到达时,首先

2017-12-23 10:34:46 0

0 由于触觉是一种主动的感觉,即感觉器官在感觉过程中被移动,所以这些模型经常描述优化感知结果的运动策略。

2018-05-03 16:18:55 4458

4458 深度学习模型和数据集的规模增长速度已经让 GPU 算力也开始捉襟见肘,如果你的 GPU 连一个样本都容不下,你要如何训练大批量模型?通过本文介绍的方法,我们可以在训练批量甚至单个训练样本大于 GPU

2018-12-03 17:24:01 676

676 在三维非刚性模型分析中,通常需要对不同姿态下的模型进行配准。针对传统配准算法存在复杂度高、计算量大、精确度低等问题,提出一种新的基于分层策略的三维非刚性模型配准算法。首先,定义热核签名函数为模型

2019-01-23 14:50:48 3

3 正如我们在本文中所述,ULMFiT使用新颖的NLP威廉希尔官方网站

取得了令人瞩目的成果。该方法对预训练语言模型进行微调,将其在WikiText-103数据集(维基百科的长期依赖语言建模数据集Wikitext之一)上训练,从而得到新数据集,通过这种方式使其不会忘记之前学过的内容。

2019-04-04 11:26:26 23207

23207

机器学习模型的训练,通常是通过学习某一组输入特征与输出目标之间的映射来进行的。一般来说,对于映射的学习是通过优化某些成本函数,来使预测的误差最小化。在训练出最佳模型之后,将其正式发布上线,再根据未来

2020-04-10 08:00:00 0

0 在这篇文章中,我会介绍一篇最新的预训练语言模型的论文,出自MASS的同一作者。这篇文章的亮点是:将两种经典的预训练语言模型(MaskedLanguage Model, Permuted

2020-11-02 15:09:36 2354

2354 本文把对抗训练用到了预训练和微调两个阶段,对抗训练的方法是针对embedding space,通过最大化对抗损失、最小化模型损失的方式进行对抗,在下游任务上取得了一致的效果提升。 有趣的是,这种对抗

2020-11-02 15:26:49 1818

1818

本期推送介绍了哈工大讯飞联合实验室在自然语言处理重要国际会议COLING 2020上发表的工作,提出了一种字符感知预训练模型CharBERT,在多个自然语言处理任务中取得显著性能提升,并且大幅度

2020-11-27 10:47:09 1595

1595

量化感知训练(Quantization Aware Training )是在模型中插入伪量化模块(fake\_quant module)模拟量化模型在推理过程中进行的舍入(r...

2020-12-08 22:57:05 1733

1733 导读:预训练模型在NLP大放异彩,并开启了预训练-微调的NLP范式时代。由于工业领域相关业务的复杂性,以及工业应用对推理性能的要求,大规模预训练模型往往不能简单直接地被应用于NLP业务中。本文将为

2020-12-31 10:17:11 2227

2227

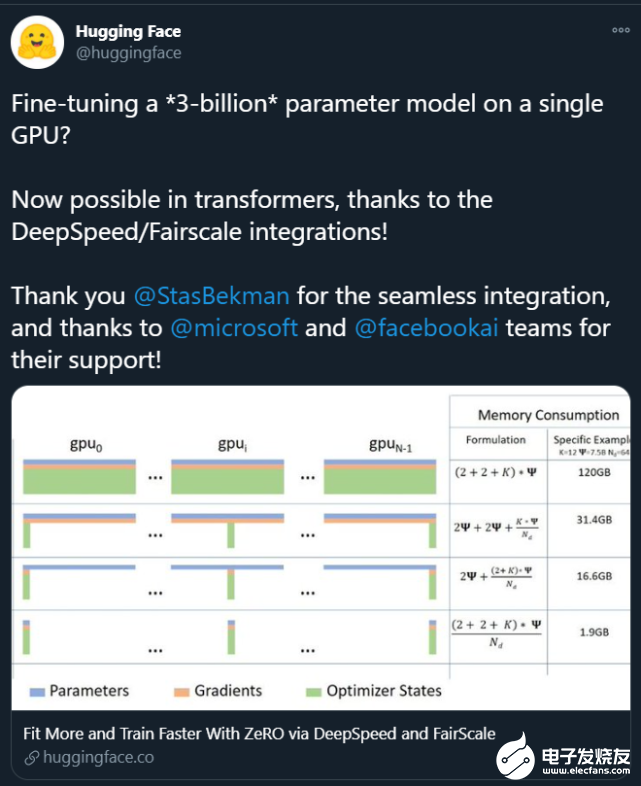

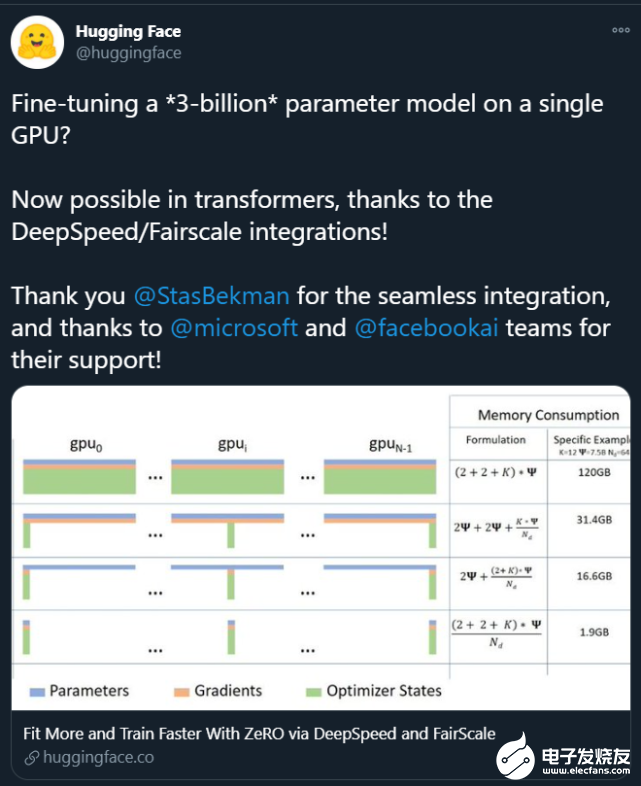

。这些大模型的出现让普通研究者越发绝望:没有「钞能力」、没有一大堆 GPU 就做不了 AI 研究了吗? 在此背景下,部分研究者开始思考:如何让这些大模型的训练变得更加接地气?也就是说,怎么用更少的卡训练更大的模型? 为了解决这个问题,来自微软、加州大学默塞德分校的研究

2021-02-11 09:04:00 2184

2184

为提高卷积神经网络目标检测模型精度并增强检测器对小目标的检测能力,提出一种脱离预训练的多尺度目标检测网络模型。采用脱离预训练检测网络使其达到甚至超过预训练模型的精度,针对小目标特点

2021-04-02 11:35:50 26

26 作为模型的初始化词向量。但是,随机词向量存在不具备语乂和语法信息的缺点;预训练词向量存在¨一词-乂”的缺点,无法为模型提供具备上下文依赖的词向量。针对该问题,提岀了一种基于预训练模型BERT和长短期记忆网络的深度学习

2021-04-20 14:29:06 19

19 针对孪生区域候选网络(RPN)易受干扰且目标丢失后无法跟踪的问题,引人锚框掩码网络机制,设计种新型孪生RPN模型。设置多尺度模板图片,并将其与目标图片进行卷积操作,实现全图检测以避免目标丢失。通过

2021-06-08 14:58:13 18

18 基于多层感知机模型的自适应简化率预测

2021-06-21 16:27:29 8

8 本文关注于向大规模预训练语言模型(如RoBERTa、BERT等)中融入知识。

2021-06-23 15:07:31 3536

3536

在某一方面的智能程度。具体来说是,领域专家人工构造标准数据集,然后在其上训练及评价相关模型及方法。但由于相关威廉希尔官方网站

的限制,要想获得效果更好、能力更强的模型,往往需要在大量的有标注的数据上进行训练。 近期预训练模型的

2021-09-06 10:06:53 3378

3378

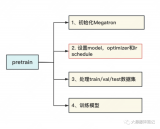

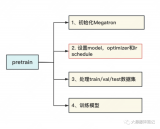

NVIDIA Megatron 是一个基于 PyTorch 的框架,用于训练基于 Transformer 架构的巨型语言模型。本系列文章将详细介绍Megatron的设计和实践,探索这一框架如何助力

2021-10-20 09:25:43 2096

2096 2021 OPPO开发者大会:NLP预训练大模型 2021 OPPO开发者大会上介绍了融合知识的NLP预训练大模型。 责任编辑:haq

2021-10-27 14:18:41 1504

1504

NLP中,预训练大模型Finetune是一种非常常见的解决问题的范式。利用在海量文本上预训练得到的Bert、GPT等模型,在下游不同任务上分别进行finetune,得到下游任务的模型。然而,这种方式

2022-03-21 15:33:30 1867

1867 由于乱序语言模型不使用[MASK]标记,减轻了预训练任务与微调任务之间的gap,并由于预测空间大小为输入序列长度,使得计算效率高于掩码语言模型。PERT模型结构与BERT模型一致,因此在下游预训练时,不需要修改原始BERT模型的任何代码与脚本。

2022-05-10 15:01:27 1193

1193 TAO 工具提供提供 QAT (Quantize Aware Training) 量化感知的训练模式,不过目前 QAT 效果还在验证当中,倒也不急于使用,因此我们还是以标准模式来训练,就是将配置文件

2022-05-13 10:57:19 1192

1192 为了减轻上述问题,提出了NoisyTune方法,即,在finetune前加入给预训练模型的参数增加少量噪音,给原始模型增加一些扰动,从而提高预训练语言模型在下游任务的效果,如下图所示,

2022-06-07 09:57:32 2006

2006 本文对任务低维本征子空间的探索是基于 prompt tuning, 而不是fine-tuning。原因是预训练模型的参数实在是太多了,很难找到这么多参数的低维本征子空间。作者基于之前的工作提出

2022-07-08 11:28:24 954

954 表示输入的特征,在传统的对抗训练中, 通常是 token 序列或者是 token 的 embedding, 表示 ground truth. 对于由 参数化的模型,模型的预测结果可以表示为 。

2022-07-08 16:57:09 1062

1062 电子发烧友网报道(文/李弯弯)在深度学习中,经常听到一个词“模型训练”,但是模型是什么?又是怎么训练的?在人工智能中,面对大量的数据,要在杂乱无章的内容中,准确、容易地识别,输出需要的图像/语音

2022-10-23 00:20:03 7397

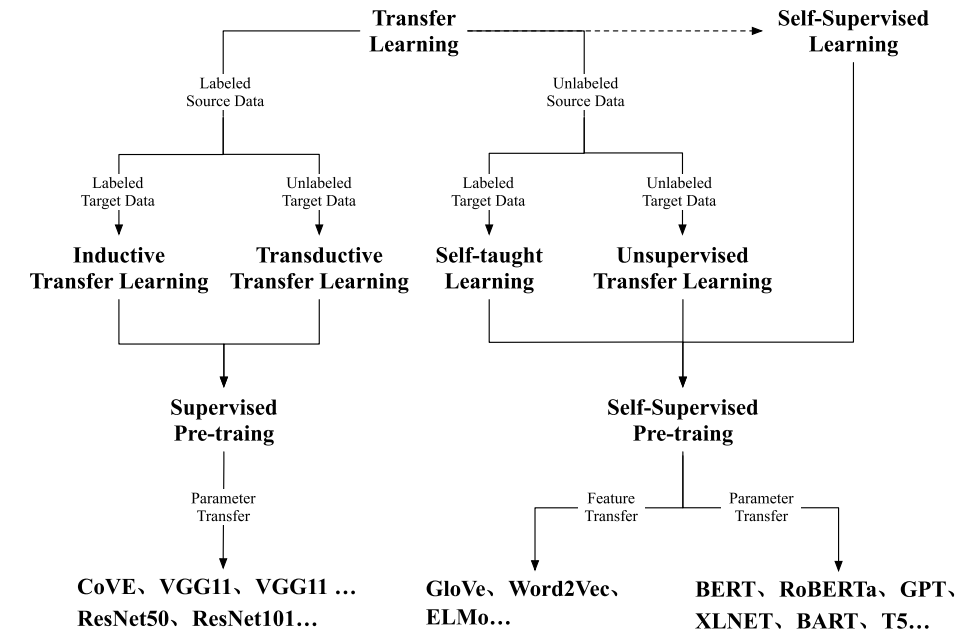

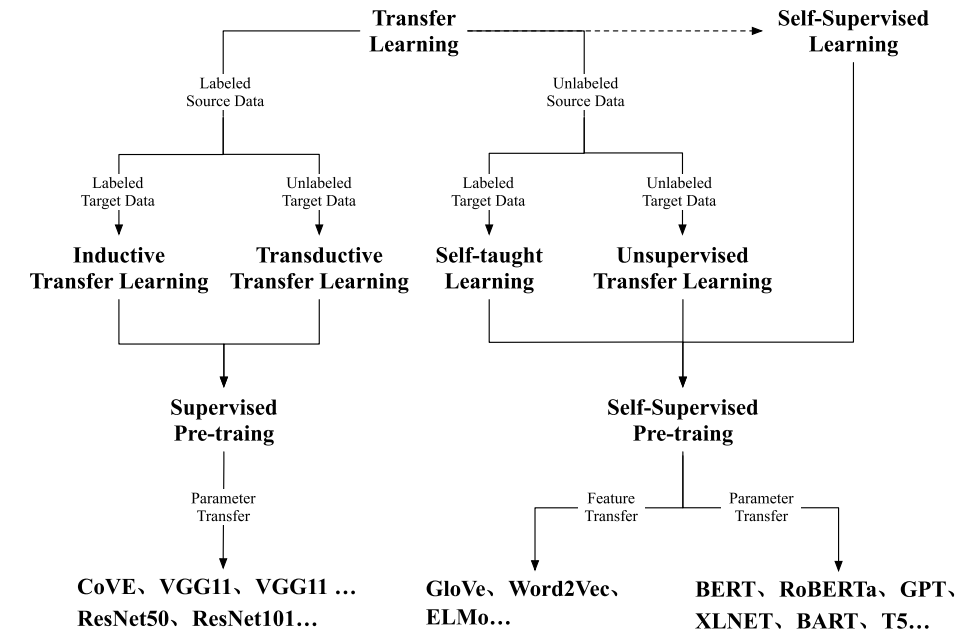

7397 随着BERT、GPT等预训练模型取得成功,预训-微调范式已经被运用在自然语言处理、计算机视觉、多模态语言模型等多种场景,越来越多的预训练模型取得了优异的效果。

2022-11-08 09:57:19 3777

3777 ON Semiconductor Gen3 扫描 LiDAR 演示器的性能测量和模型验证

2022-11-15 20:12:52 0

0 NVIDIA 发布了 TAO 工具套件 4.0 。该工具套件通过全新的 AutoML 功能、与第三方 MLOPs 服务的集成以及新的预训练视觉 AI 模型提高开发者的生产力。该工具套件的企业版现在

2022-12-15 19:40:06 737

737 2022年下半年开始,涌现出一大批“大模型”的优秀应用,其中比较出圈的当属AI作画与ChatGPT,刷爆了各类社交平台,其让人惊艳的效果,让AI以一个鲜明的姿态,站到了广大民众面前,让不懂AI的人也能直观地体会到AI的强大。大模型即大规模预训练模型 。

2023-02-20 14:09:11 1424

1424

BERT类模型的工作模式简单,但取得的效果也是极佳的,其在各项任务上的良好表现主要得益于其在大量无监督文本上学习到的文本表征能力。那么如何从语言学的特征角度来衡量一个预训练模型的究竟学习到了什么样的语言学文本知识呢?

2023-03-03 11:20:00 931

931 预训练 AI 模型是为了完成特定任务而在大型数据集上训练的深度学习模型。这些模型既可以直接使用,也可以根据不同行业的应用需求进行自定义。 如果要教一个刚学会走路的孩子什么是独角兽,那么我们首先应

2023-04-04 01:45:02 1055

1055 作为深度学习领域的 “github”,HuggingFace 已经共享了超过 100,000 个预训练模型

2023-05-19 15:57:43 512

512

预训练 AI 模型是为了完成特定任务而在大型数据集上训练的深度学习模型。这些模型既可以直接使用,也可以根据不同行业的应用需求进行自定义。

2023-05-25 17:10:09 613

613 本文章将依次介绍如何将Pytorch自训练模型经过一系列变换变成OpenVINO IR模型形式,而后使用OpenVINO Python API 对IR模型进行推理,并将推理结果通过OpenCV API显示在实时画面上。

2023-06-07 09:31:42 1092

1092

前文说过,用Megatron做分布式训练的开源大模型有很多,我们选用的是THUDM开源的CodeGeeX(代码生成式大模型,类比于openAI Codex)。选用它的原因是“完全开源”与“清晰的模型架构和预训练配置图”,能帮助我们高效阅读源码。我们再来回顾下这两张图。

2023-06-07 15:08:24 2323

2323

在一些非自然图像中要比传统模型表现更好 CoOp 增加一些 prompt 会让模型能力进一步提升 怎么让能力更好?可以引入其他知识,即其他的预训练模型,包括大语言模型、多模态模型 也包括

2023-06-15 16:36:11 296

296

ai大模型和小模型的区别 人工智能领域中的模型分为两种,一种是大模型,另一种是小模型,两者在训练和应用中有着明显的区别。 本文将从定义、特点、应用等方面详细介绍这两种模型的区别。 一、概念定义

2023-08-08 17:30:54 4787

4787 卷积神经网络模型训练步骤 卷积神经网络(Convolutional Neural Network, CNN)是一种常用的深度学习算法,广泛应用于图像识别、语音识别、自然语言处理等诸多领域。CNN

2023-08-21 16:42:00 955

955 在《英特尔锐炫 显卡+ oneAPI 和 OpenVINO 实现英特尔 视频 AI 计算盒训推一体-上篇》一文中,我们详细介绍基于英特尔 独立显卡搭建 YOLOv7 模型的训练环境,并完成了 YOLOv7 模型训练,获得了最佳精度的模型权重。

2023-08-25 11:08:58 851

851

生成式AI和大语言模型(LLM)正在以难以置信的方式吸引全世界的目光,本文简要介绍了大语言模型,训练这些模型带来的硬件挑战,以及GPU和网络行业如何针对训练的工作负载不断优化硬件。

2023-09-01 17:14:56 1065

1065

华为盘古大模型以Transformer模型架构为基础,利用深层学习威廉希尔官方网站

进行训练。模型的每个数量达到2.6亿个,是目前世界上最大的汉语预备训练模型之一。这些模型包含许多小模型,其中最大的模型包含1亿4千万个参数。

2023-09-05 09:55:56 1304

1304 前面已经讲过了Yolov5模型目标检测和分类模型训练流程,这一篇讲解一下yolov5模型结构,数据增强,以及训练策略。

2023-09-11 11:15:21 979

979

近期,一支来自中国的研究团队正是针对这些问题提出了解决方案,他们推出了FLM-101B模型及其配套的训练策略。FLM-101B不仅大幅降低了训练成本,而且其性能表现仍然非常出色,它是目前训练成本最低的100B+ LLM。

2023-09-12 16:30:30 952

952

finetune)、rlhf(optional). State of GPT:大神 Andrej 揭秘 OpenAI 大模型原理和训练过程 。 supervised finetune 一般在 base

2023-09-19 10:00:06 530

530

Hello大家好,今天给大家分享一下如何基于深度学习模型训练实现圆检测与圆心位置预测,主要是通过对YOLOv8姿态评估模型在自定义的数据集上训练,生成一个自定义的圆检测与圆心定位预测模型

2023-12-21 10:50:05 562

562

Hello大家好,今天给大家分享一下如何基于深度学习模型训练实现工件切割点位置预测,主要是通过对YOLOv8姿态评估模型在自定义的数据集上训练,生成一个工件切割分离点预测模型

2023-12-22 11:07:46 318

318

谷歌模型训练软件主要是指ELECTRA,这是一种新的预训练方法,源自谷歌AI。ELECTRA不仅拥有BERT的优势,而且在效率上更胜一筹。

2024-02-29 17:37:39 362

362 谷歌在模型训练方面提供了一些强大的软件工具和平台。以下是几个常用的谷歌模型训练软件及其特点。

2024-03-01 16:24:01 219

219

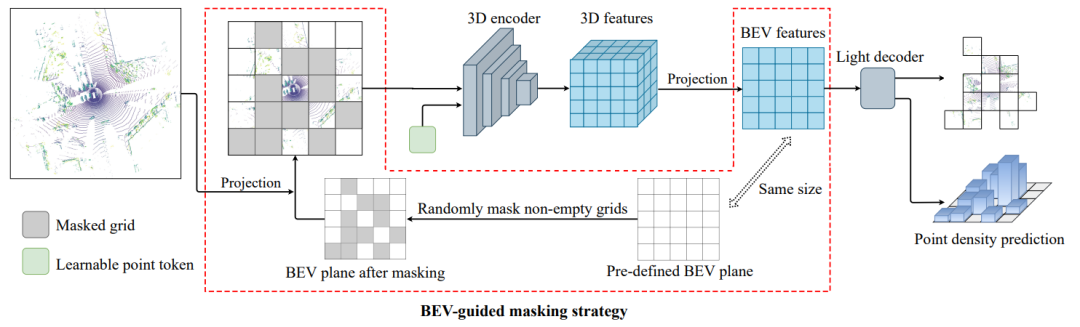

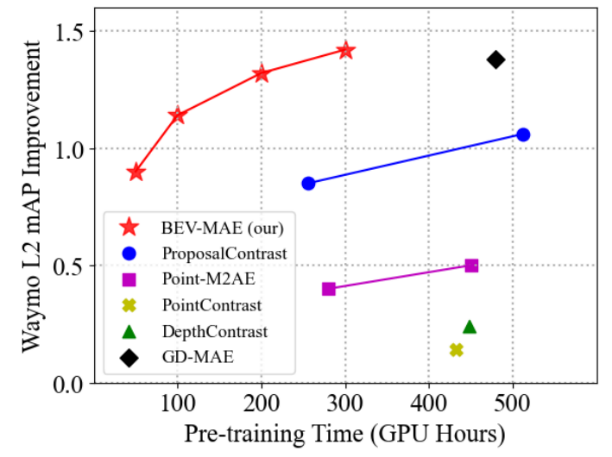

,首先预定义一个大小为

,首先预定义一个大小为 的网格状鸟瞰图平面。然后,根据点云的坐标将每个点云投影到预定义平面的相应鸟瞰图网格中。之后,作者将随机选择一部分非空的鸟瞰图网格作为被掩码的网格,并将其余的鸟瞰图网格视为可见网格。最后将所有投影到可见网格中的点云视为掩码后的点云输入到网络中。

的网格状鸟瞰图平面。然后,根据点云的坐标将每个点云投影到预定义平面的相应鸟瞰图网格中。之后,作者将随机选择一部分非空的鸟瞰图网格作为被掩码的网格,并将其余的鸟瞰图网格视为可见网格。最后将所有投影到可见网格中的点云视为掩码后的点云输入到网络中。

电子发烧友App

电子发烧友App

评论